Depuis plus d’un mois, le groupe californien est tourmenté par ce scandale, alimenté par les documents internes révélés par la lanceuse d’alerte Frances Haugen. Retour sur les principales problématiques soulevées dans cette affaire.

13 septembre 2021 : le Wall Street Journal publie le premier article de son enquête baptisée les « Facebook Files ». Alors que le réseau social assure que tout le monde est soumis aux mêmes règles de modération, le quotidien américain révèle que des célébrités et responsables politiques font l’objet de mesures particulières. Ils peuvent ainsi poster des contenus enfreignant les règles le temps qu’un employé de l’entreprise les examine. Le footballeur international Neymar a par exemple publié des photos nues d’une femme qui l’accusait de viol avant qu’elles ne soient supprimées en 2019.

S’en suit une vague de révélations où l’on apprend notamment qu’Instagram sait parfaitement que sa plateforme est toxique pour la santé mentale des adolescentes, et que les contenus clivants sont davantage mis en avant que les autres après un changement d’algorithme. On doit ces divulgations à Frances Haugen, ancienne employée ayant quitté l’entreprise en mai dernier avec des milliers de documents internes. Facebook est depuis dans la tourmente et ce n’est pas fini : les langues d’anciens employés continuent à se délier.

Instagram, un réseau social toxique pour la santé mentale des jeunes

En surexposant les adolescents aux vies apparemment idéales d’autres personnes ainsi qu’à des images et publicités inappropriées, Instagram semble nuire à leur santé mentale. Et Facebook, propriétaire de l’application de partage de photos et de vidéos, le sait. Depuis trois ans, la firme californienne mène des études sur la façon dont la plateforme affecte ses millions de jeunes utilisateurs, a révélé le Wall Street Journal. Les chercheurs de l’entreprise ont ainsi constaté, à plusieurs reprises, qu’Instagram est nocif, notamment pour les jeunes filles : « 32% des adolescentes ont déclaré que lorsqu’elles se sentaient mal dans leur corps, Instagram les faisait se sentir encore plus mal ».

Facebook, critiqué sur le sujet, a annoncé fin septembre qu’il mettait « en pause » le développement d’une version pour enfants de son application. De nouvelles fonctionnalités ont également été très récemment dévoilées dans le but de préserver la santé mentale des jeunes utilisateurs : ils seront prochainement incités à regarder un autre sujet lorsqu’ils s’attardent sur du contenu nuisible et à faire une pause dans leur utilisation du réseau social. Reste à voir si les mesures seront suffisantes face à des algorithmes de recommandation assez redoutables.

Un problème de contrôle des algorithmes

On le sait, les réseaux sociaux utilisent des algorithmes de recommandation pour proposer les contenus les plus pertinents aux utilisateurs, en fonction de critères qu’ils définissent. Ces systèmes reposent sur l’intelligence artificielle (IA). Chez Facebook, le plus important est celui concernant le fil d’actualité, permettant un classement des publications en fonction d’un « score », obtenu par le biais de divers signaux (nombre de personnes abonnées à une page, intérêt manifesté par les « amis » d’un utilisateur sur un sujet). Les contenus s’affichant en premier sont donc les mieux notés.

Le problème, c’est que certains d’entre eux se retrouvent avec un score trop élevé à cause de l’accumulation de signaux ajoutés au fil du temps. Parmi eux, figurent notamment des publications problématiques, telles que des vidéos pornographiques sur l’onglet Watch (espace dédié à la vidéo) en Inde. Et une baisse de leur note ne suffit malheureusement pas à réduire leur popularité : « certains de ces contenus resteraient en tête même si on appliquait une baisse de leur score de 90% », a expliqué l’auteur d’un document dans Le Monde. Il s’agirait là de l’une des conséquences indésirables des multiples changements d’algorithmes chez Facebook.

Une modification effectuée sur le système gérant le fil d’actualité en 2018 pour privilégier les « interactions sociales significatives » a d’ailleurs eu un effet dévastateur. L’entreprise voulait renforcer les liens entre les utilisateurs, en les encourageant à interagir davantage avec leurs amis et leur famille que sur des contenus produits par des professionnels, considérés comme « nocifs ». Résultat : les publications clivantes ont été optimisées, l’algorithme mettant en avant celles partagées par les proches, susceptibles de provenir de pages douteuses ou engagées politiquement. Facebook en était apparemment conscient, mais il n’a pas cherché à inverser la tendance, les contenus clivants générant plus d’engagement et de réactions de la part des abonnés au réseau.

Une modération insuffisante

Le plus grand réseau social au monde manque d’effectifs qualifiés pour assurer la modération de ses contenus dans les pays en conflit. Concrètement, les modérateurs ne sont pas en mesure de comprendre les langues ou dialectes, ni les contextes sociopolitiques. Ils suppriment ainsi des pages ou des publications par « erreur » ou ignorance. C’est ce qui arrive dans les pays arabophones comme l’Irak, le Yémen ou l’Afghanistan. Ironie du sort, l’arabe est la troisième langue la plus parlée sur le réseau social.

Ce manque d’effectifs affecte la capacité des systèmes de modération automatique de la firme. Ces logiciels ont besoin de données afin d’apprendre à réaliser les tâches pour lesquelles ils ont été conçus. Dans le cas de Facebook, il s’agit de contenus correctement modérés. Mais ces derniers ne sont pas assez nombreux pour entraîner les outils d’IA, les modérateurs humains n’étant pas compétents dans ce domaine. C’est ainsi que seulement 2% des contenus haineux sont modérés automatiquement en Afghanistan.

Face à ses révélations, Facebook se défend en affirmant que ses systèmes de modération humains et automatiques se sont améliorés, notamment par le biais de recrutements. Il refuse pourtant de communiquer le nombre de modérateurs dédiés à chaque pays ou langue. Actuellement, ces systèmes fonctionnent mieux aux États-Unis, grâce à l’anglais. Malgré cela, le réseau social n’a pas échappé aux problèmes de gestion de désinformation.

La mobilisation du 6 janvier 2021 en question

Le 6 janvier dernier, plusieurs centaines de manifestants envahissent le Capitole à Washington. Une première historique à laquelle Facebook est accusée d’avoir contribué. Ses algorithmes sont mis en cause pour avoir permis à de nombreux utilisateurs de se mobiliser en vue de la manifestation. Le groupe californien avait pourtant prévu des mesures d’urgence, comme la suspension des commentaires dans les groupes identifiés comme « à risque ». Mises en place lors de l’élection présidentielle américaine de 2020, celles-ci auraient été désactivées après le scrutin, selon Frances Haugen. Lors de la « prise du Capitole », des problèmes administratifs et techniques auraient retardé l’instauration de ces règles.

Facebook manquait par ailleurs ce jour-là de modérateurs. En effet, des équipes mobilisées pour lutter contre les « fake news » lors du scrutin – à l’image de la division « intégrité civique » dans laquelle travaillait Frances Haugen – avaient été démantelées.

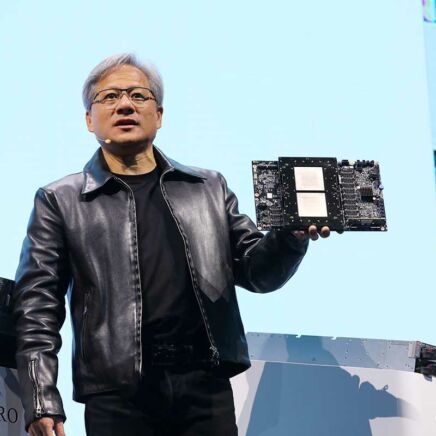

Face aux révélations des dernières semaines, Mark Zuckerberg s’est exprimé pour accuser les médias « d’utiliser de manière sélective des documents divulgués pour peindre une fausse image de l’entreprise ». Ce n’est pas un hasard si l’ancien étudiant surdoué de Harvard cherche à détourner l’attention en rebaptisant le 28 octobre Facebook Inc. en Meta. Un changement de nom et de logo qui tombe à point nommé, quand bien même il viserait à mieux refléter les nouvelles ambitions du groupe pour le metaverse. Mais cette tentative de diversion passagère n’empêchera pas les régulateurs de vouloir mieux protéger les mineurs avec de nouvelles lois et de réclamer plus de transparence sur le fonctionnement des algorithmes de recommandation et du système de modération de Facebook.