Les images créées par l’IA s’améliorent de façon exponentielle, au point que de nombreuses personnes sont incapables de les distinguer de la réalité. Contrefaçons, manipulations… comment faire le tri ?

L’IA réinvente le paysage médiatique avec les deepfakes, brouillant la frontière entre réel et virtuel. Une avancée technologique doublée d’un défi éthique, nous poussant à questionner l’authenticité à l’ère du numérique. D’un côté, grâce à l’intelligence artificielle générative (ChatGPT, DALL-E, Midjourney, Stable Diffusion…), les frontières entre le réel et le virtuel s’estompent, donnant naissance à des œuvres médiatiques d’un réalisme époustouflant. Cet essor de la créativité, porté par l’IA, promet un monde riche en innovations et en explorations artistiques. Toutefois, cette médaille a son revers : l’émergence des deepfakes. Ces créations manipulées avec une finesse inouïe, qu’il s’agisse d’images, de vidéos ou de pistes audio, nous plongent dans un véritable casse-tête quant à la détection de leur authenticité.

Face aux deepfakes, développer un esprit critique est primordial

Ces fausses images ou vidéos sèment le trouble alors même que nous sommes plus que jamais dans une quête de vérité en ces périodes troublées. Elles viennent remettre en question l’authenticité même de nos médias. Les implications sont loin d’être anodines : de la propagation de fausses informations à la manipulation de l’opinion publique, en passant par l’extorsion de données personnelles sensibles, les abus sont multiples. Cette forme de média synthétique redéfinit les contours de l’intelligence artificielle, nous confrontant à des défis éthiques et moraux majeurs. À l’instar de la mésaventure subie par Taylor Swift, qui a vu des vidéos manipulées la concernant inonder le Web. Mais alors, comment détecter ces deepfakes ?

Avant toute chose, il devient impératif de cultiver un esprit critique. Avant de réagir impulsivement sans prendre de recul à la moindre photo ou vidéo qui circule sur les réseaux sociaux – voire qui sont parfois reprises par des médias plus ou moins sérieux –, il convient de s’interroger. L’enjeu ? Préserver notre capacité à discerner la réalité dans un monde numérique où les illusions sont plus vraies que nature. Pour l’heure, mais cela pourrait évoluer rapidement, les deepfakes ne sont pas parfaits. Il faut donc passer en mode « détective » quand une image ou une vidéo est choquante ou particulièrement inhabituelle.

Dans les images, souvent, on trouve des anomalies dans la texture de la peau, sur les yeux ou les lèvres. Les mains aussi sont un bon indicateur, ainsi que la position des bras ou des jambes par rapport au reste du corps. Vous pouvez aussi télécharger une image pour faire une recherche inversée à l’aide d’un moteur de recherche (Google propose cette option par exemple) afin de vérifier si des parties de la photo ne proviennent pas d’autres images et auraient été fusionnées avec d’autres éléments pour créer une polémique de toutes pièces.

Dans les vidéos, un clignement irrégulier des yeux (ou l’absence de clignement), des distorsions au niveau des lèvres ou des ombres incohérentes peuvent indiquer une manipulation. Le mouvement naturel est encore difficile à imiter parfaitement pour les IA : les mouvements saccadés, les transitions maladroites ou les expressions faciales qui ne correspondent pas émotionnellement au contexte peuvent signaler une vidéo deepfake.

Même chose du côté du son. Les imperfections dans la synchronisation labiale ou des anomalies dans la tonalité de la voix peuvent indiquer une manipulation. Les progrès dans le domaine des deepfakes audio sont significatifs, mais certaines subtilités restent encore difficiles à reproduire fidèlement.

Des réflexes à adopter systématiquement

En dehors de l’aspect visuel ou sonore, il convient aussi de s’interroger sur le but du partage de telle image ou telle vidéo. Quelle cause cela sert-il ? Qui partage ? Quelle est la source ? La vérification de l’origine d’une image ou d’une vidéo est fondamentale. Rechercher la source ou d’autres occurrences de l’image peut aider à déterminer son authenticité. Là encore, des outils de vérification d’images inversées comme Google Images peuvent être utiles.

Souvent, les deepfakes se cachent derrière des (faux) logos de médias bien connus. BFMTV, TF1, LCI, CNN… Les faussaires se cachent derrière des noms sérieux pour profiter de leur réputation et faire plus facilement circuler leurs contrefaçons visuelles. Il ne faut donc pas hésiter à remonter à la source : cette vidéo venant soi-disant de FranceInfo TV est-elle bien présente sur leur site ou leurs réseaux sociaux ? Si ce n’est pas le cas, méfiance.

Utiliser des outils de détection spécialisés : est-ce fiable ?

De plus en plus, les sociétés derrière les intelligences artificielles essaient de développer des outils de détection de ces deepfakes. Mais les résultats sont assez inégaux. Pourtant, ces outils sont essentiels dans la lutte contre la désinformation et la manipulation médiatique. Plusieurs entreprises et instituts de recherche travaillent sur des solutions avancées pour détecter les manipulations. Voici quelques exemples notables :

Microsoft Video Authenticator : la firme de Redmond a développé un outil capable d’analyser des photos ou vidéos et de fournir un score indiquant la probabilité qu’elles soient manipulées. Cet outil utilise des techniques d’apprentissage machine (machine learning) pour identifier des artefacts subtils qui peuvent ne pas être perceptibles par l’œil humain.

Deepware Scanner : il s’agit d’une application conçue pour détecter les deepfakes en recherchant des signes de manipulation. Elle utilise des algorithmes d’intelligence artificielle pour évaluer la probabilité qu’une vidéo soit générée par IA.

Adobe Content Authenticity Initiative (CAI) : bien que le focus principal d’Adobe CAI soit la création d’un cadre pour l’authentification du contenu numérique, ils travaillent également sur des technologies pour détecter les manipulations, y compris les deepfakes. L’initiative vise à augmenter la transparence et à fournir aux consommateurs des informations sur l’origine et l’état du contenu numérique.

Dans le secteur de la recherche universitaire aussi : des institutions académiques à travers le monde mènent des recherches pour améliorer la détection des deepfakes. Par exemple, l’Université de Californie à Berkeley et d’autres institutions ont développé des méthodes basées sur l’IA pour identifier les vidéos manipulées en détectant des incohérences dans les mouvements des visages ou des gestes qui ne sont pas naturels.

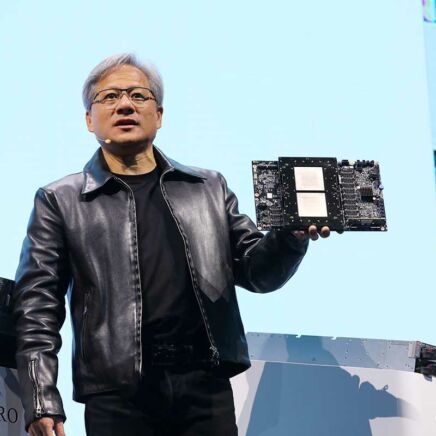

Néanmoins, il est fort probable que les erreurs basiques des IA génératives actuelles disparaissent dans un futur proche. Il deviendra alors très compliqué d’identifier des deepfakes par un simple « scan » en quête d’anomalies. En parallèle, des firmes telles qu’Adobe, OpenAI, Stability ou Google planchent sur un système de filigrane standardisé permettant d’identifier visuellement une création (ou modification) par IA. Même s’il est évident qu’il y aura toujours des solutions de contournement de ces garde-fous…