Alors qu’en 2024, la moitié de la population mondiale est appelée aux urnes pour diverses élections, le spectre de la désinformation à l’aide de l’intelligence artificielle plane sur les scrutins.

Faut-il avoir peur que l’intelligence artificielle influence les élections ? Aux États-Unis, « la question, elle est vite répondue ». Le cas a déjà eu lieu il y a quelques jours. Dans le cadre des primaires pour la présidentielle américaine, qui se tiendra en novembre, des électeurs du New Hampshire ont reçu de faux appels de Joe Biden, bien reconnaissable à sa voix, leur affirmant : « Ce ne sont que des balivernes. Votre vote fera la différence en novembre, pas ce mardi ». Bref, pas besoin d’aller voter… et un cas flagrant de désinformation créée par IA. Et qui vient se rajouter aux dangers liés aux IA génératives d’images.

Car si ces appels enregistrés sont courants aux États-Unis, ici, il ne s’agissait pas d’un message du président, mais d’une déclaration trompeuse imaginée à l’aide de l’intelligence artificielle par des opposants au démocrate. La FCC (Commission fédérale des communications) a immédiatement pris des mesures pour interdire les « appels téléphoniques non sollicités afin d’arnaquer des membres vulnérables de la famille, d’imiter des célébrités et de désinformer les électeurs ». L’amende pourrait grimper jusqu’à 21 000 euros par appel. « Cela ressemble à quelque chose d’un futur lointain, mais c’est déjà là », a déclaré la présidente de la FCC, Jessica Rosenworcel.

Élections en pagaille en 2024… pagaille dans les élections ?

Le cas américain n’est pas isolé. Il pourrait surtout se multiplier ces prochaines semaines et mois. L’année 2024 est en effet une année bien particulière au niveau mondial puisque plus de la moitié de la population est appelée aux urnes pour divers scrutins, dont 76 nationaux. Côté présidentielle, Taîwan, l’Indonésie, les USA ou encore la Russie convoquent leurs électeurs cette année. L’Inde, la Corée du Sud, l’Afrique du Sud ou encore l’Iran vont organiser des scrutins nationaux (législatives, par exemple) en 2024. Des pays comme le Brésil et la Turquie organisent des élections municipales. Enfin, les élections au Parlement européen auront lieu du 6 au 9 juin 2024. Au total, plus de 4 milliards de citoyens sont appelés à s’exprimer.

Et les risques liés à l’intelligence artificielle n’ont jamais été aussi grands avec les progrès rapides des IA génératives. Les inquiétudes concernant l’utilisation de l’IA, notamment la possibilité de reproduire les voix et les images de politiciens et de célébrités – pour appeler à voter pour tel ou tel candidat ou désinformer – s’est développée ces derniers mois à mesure que la technologie permettant de recréer des personnages a décollé. Au quotidien déjà, le problème se pose. Ainsi, l’acteur Tom Hanks a fait, à son insu la plus totale, la promotion de soins dentaires. Dernièrement, des vidéos au contenu sexuellement explicite de la chanteuse Taylor Swift ont afflué sur X/Twitter. Ces images, qu’on appelle deep fakes, pourraient donc faire pencher des élections dans un sens ou dans l’autre si elles se déversent sur Internet. À qui faire confiance dans ces conditions ?

Les sociétés derrière ces IA sommées de créer des garde-fous

Un peu partout dans le monde, que ce soit en Europe, aux États-Unis ou même en Chine, les législateurs s’efforcent de trouver des solutions. En parallèle, les géants de la tech eux-mêmes font preuve de bon vouloir, sous la pression politique, et cherchent des solutions pour identifier clairement les contenus générés par intelligence artificielle. OpenAI (ChatGPT, DALL-E…), Google (Gemini), Meta, Microsoft, Nvidia, Adobe, Midjourney, Stable Diffusion… ont tous entamé des réflexions sur le sujet et certains ont même fait leurs premières annonces.

Début février, Google a ainsi déclaré qu’il s’associait à un effort visant à développer des moyens d’identification pour toute sorte de contenu numérique. Un peu à l’instar d’un « nutri-score » mais adapté au contenu, ce système pourrait identifier quand et comment une photographie, une vidéo, un clip audio, un texte… a été produit ou modifié – y compris avec de l’intelligence artificielle, mais pas que. Google a annoncé qu’il allait collaborer pour cela avec des sociétés comme Adobe, la BBC, Microsoft et Sony pour affiner les normes techniques. La difficulté aujourd’hui est que la technologie se révèle parfois incapable d’identifier une création assistée par IA tant le résultat est précis et sans « hallucination ». Quelques jours plus tôt, Meta avait fait des annonces similaires.

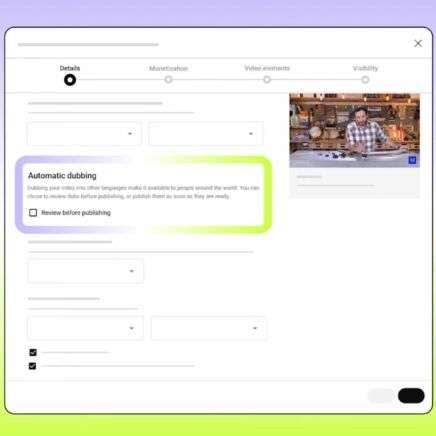

Le groupe de Mark Zuckerberg s’est prononcé en faveur d’un système de signalisation standardisé des contenus numériques. De son côté, OpenAI a indiqué qu’il intégrerait bientôt des filigranes aux images générées par IA, conformément aux normes de la C2PA (Coalition for Content Provenance and Authenticity). Les images produites par son chatbot en ligne, ChatGPT, et la technologie de génération d’images autonome, DALL-E, incluront à la fois un filigrane visuel et des métadonnées cachées, conçus pour les identifier comme créées par intelligence artificielle. Cependant, OpenAI met en garde : ce système « n’est pas une solution miracle pour résoudre les problèmes de provenance ». En effet, les balises « peuvent facilement être supprimées, que ce soit accidentellement ou intentionnellement ».

Il y a donc un « sentiment partagé d’urgence » des géants de la tech, comme l’a écrit Andy Parsons, directeur de la Content Authenticity Initiative chez Adobe, sur son blog. Et ce, d’autant plus que « les enjeux n’ont jamais été aussi élevés pour s’assurer que les gens, partout dans le monde, ont accès à la transparence afin de pouvoir vérifier, puis faire confiance au contenu qu’ils voient en ligne. ». L’envie est là et les outils se développent, mais, à l’heure actuelle, les faussaires de l’IA s’en donnent encore à cœur joie. La méfiance reste donc de mise… et sans doute pour longtemps encore.