La recherche en ligne résumée par IA a beau avoir un côté pratique, elle n’est absolument pas fiable, assurent deux chercheuses américaines.

Toutes les entreprises spécialisées dans l’intelligence artificielle s’y mettent. Inspirés par un Perplexity qui a montré la voie, les autres chatbots du marché comme ChatGPT proposent désormais une fonction permettant de chercher sur le Web à notre place et de répondre à nos requêtes sous la forme d’un texte prémâché, censé répondre à nos interrogations sur un sujet donné. Mais, pour Klaudia Jaźwińska et Aisvarya Chandrasekar du Tow Center for Digital Journalism de Columbia, le compte n’y est pas du tout.

Des réponses incorrectes dans 60 % des cas

Les chercheuses ont examiné les résultats provenant de huit IA spécifiques : ChatGPT, Perplexity et Perplexity Pro, Copilot, Gemini, DeepSeek, Grok 2 et Grok 3. Elles ont sélectionné des extraits d’articles de 20 sites web et ont soumis ces extraits aux chatbots en leur demandant d’identifier le titre, l’éditeur, la date de publication et l’URL de l’article original. Elles ont ensuite classé les réponses en fonction de leur précision : correctes, correctes mais incomplètes, partiellement incorrectes, complètement incorrectes ou non fournies.

Leurs observations ont révélé que les chatbots fournissent souvent des réponses incorrectes avec une grande confiance et les modèles premium, tels que Perplexity Pro et Grok 3, ont montré des taux d’erreur plus élevés que leurs équivalents gratuits, tout en étant plus affirmatifs dans leurs réponses erronées. Un bilan pour le moins désastreux pour des outils amenés à se démocratiser, voire à progressivement remplacer la recherche en ligne telle que nous la connaissons aujourd’hui.

Il est à noter qu’en comparaison, le même exercice sur un moteur de recherche classique, comme Google, permettait systématiquement de remonter à la source de l’article utilisé par les chercheuses.

Un problème de confiance

Le principal problème qu’illustre cette étude (à la méthodologie qui sort du cadre d’un usage classique de ce genre d’outils), c’est la grande confiance dont font preuve les intelligences artificielles pour débiter des inexactitudes. Ce n’est pas nouveau : on sait que les IA préfèrent « halluciner » plutôt qu’exprimer leur méconnaissance d’un sujet. Mais cela est d’autant plus grave quand ces outils vont être de plus en plus utilisés pour informer les internautes.

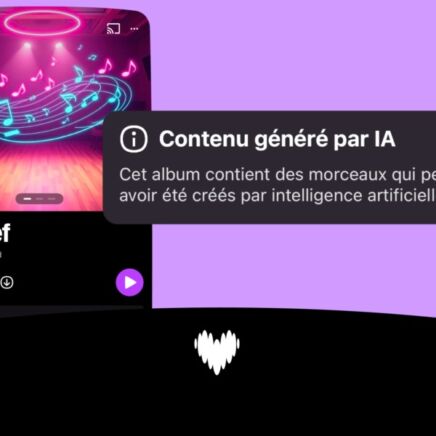

Autre problème épineux : les chercheuses ont découvert que ces outils alimentés par IA étaient tout à fait capables d’extraire des informations de sites web sur lesquels ils sont censés être bloqués. Pourtant, les noms des robots d’indexation de ChatGPT Search, Perplexity et Perplexity Pro, Copilot et Gemini sont connus et peuvent être bloqués par les éditeurs de sites web. Un coup d’épée dans l’eau ; et autant de contenus ainsi dérobés par les IA sans que les éditeurs de sites web puissent avoir leur mot à dire.

Une étude enrichissante, qui ne fait qu’accentuer la prudence dont on doit faire preuve lorsqu’on utilise un outil d’intelligence artificielle à la recherche de réponses fiables. Un fait qui avait déjà été illustré il y a quelques mois par une autre étude. Signe que, même si les grandes entreprises de la tech assurent faire des progrès de géant avec leurs modèles de langage, leur priorité n’est pas la fiabilité de leurs outils.