Dans un rapport publié le 1er décembre, l’ONG Human Rights Watch alerte sur les risques posés par les robots tueurs et explique la nécessité d’une nouvelle loi pour les encadrer.

Ils n’existent pas encore, mais font beaucoup parler d’eux. Ils, ce sont les robots tueurs ou systèmes d’armes létales autonomes (SALA). Ces armes sont potentiellement capables d’identifier, d’engager et de neutraliser une cible… sans aucune intervention humaine. Étant des machines, elles présenteraient plusieurs bénéfices : contrairement aux hommes, elles ne ressentiraient pas la faim, la fatigue, la douleur ou la peur. Elles constituent aussi des risques pour les mêmes raisons : elles manqueraient d’empathie et ne seraient pas capables de comprendre la dignité humaine, soit le fait qu’une personne ne doit jamais être traitée comme un objet ou un moyen.

Des pays tels que le Royaume-Uni ou la Russie investissent dans le développement de ces systèmes autonomes. Le premier cherche par exemple à concevoir un drone capable d’identifier par lui-même une cible. À partir du 13 décembre, l’utilisation de ces robots sera discutée à l’occasion de la Convention sur certaines armes classiques (CCAC). Dans ce cadre, l’organisation non gouvernementale (ONG) Human Rights Watch a publié un rapport expliquant le besoin de créer une loi pour répondre aux risques que posent ces machines.

Une nouvelle loi pour compléter le droit international humanitaire

Pour l’ONG, le droit international humanitaire (DIH) ne permet pas d’encadrer l’utilisation des SALA. Cet ensemble de règles vise à limiter les effets des conflits armés pour des raisons humanitaires. Il protège ainsi les personnes ne participant pas ou plus aux combats. Il interdit, en outre, l’emploi de moyens et de méthodes militaires, où la distinction entre les combattants et les civils est impossible. C’est le cas des armes biologiques et chimiques. « Il faut d’urgence élaborer un traité pour remédier aux lacunes du droit international humanitaire, et l’actualiser de manière à répondre aux questions légales, éthiques et sociétales liées à l’intelligence artificielle actuelle et aux technologies émergentes », explique Bonne Docherty, chercheuse senior auprès de la division Armes chez Human Rights Watch dans un communiqué.

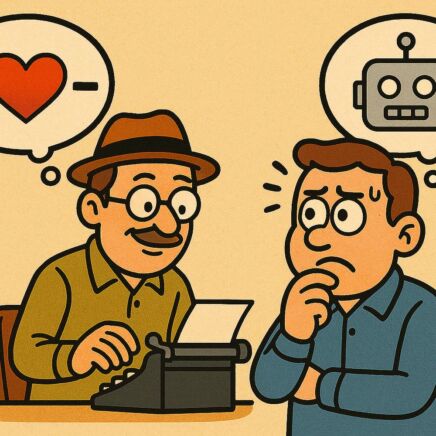

Les robots tueurs étant autonomes, les humains ne prendraient plus part aux décisions de recours à la force. Les cibles seraient alors réduites à de simples modèles de données, sans distinction entre combattants et civils. Ce type d’armes suscite ainsi des questions éthiques. Les hommes sont en effet les seuls à pouvoir s’identifier aux autres, à interpréter certains signes comme le ton de la voix ou les expressions faciales avant de prendre une décision. Programmées à l’avance, les machines n’en sont pas capables. Elles ne pourraient pas reconnaître un soldat tentant de se rendre, par exemple.

Les robots tueurs soulèvent en outre des problèmes de biais algorithmique, comme tous les systèmes basés sur l’intelligence artificielle. Entraînés avec des données reflétant les biais de la société, ils tendent à porter préjudice aux femmes, aux groupes ethniques minoritaires ou encore aux personnes LGBTI. La reconnaissance faciale peut ainsi provoquer des résultats discriminatoires.

Des questions de responsabilité et de sécurité

Les SALA posent un problème en termes de responsabilité : qui est responsable des actes de l’un d’eux ? Le robot lui-même ou son concepteur ? Le premier ne peut pas être tenu légalement responsable de ses actions. Juridiquement parlant, il n’est pas considéré comme une « personne physique », soit un être humain avec des droits et des obligations. Le robot est en effet reconnu comme une chose, un objet de droit. La responsabilité des actes ne peut pas non plus être imputée au fabricant de la machine, car celui-ci n’est pas en mesure de prévoir la commission d’actes illicites par cette dernière.

Pour Human Rights Watch, les systèmes d’armes autonomes présentent, par ailleurs, des risques de sécurité. Leur développement et leur production est susceptible de mener à une course aux armements. Les États pourraient se précipiter pour développer des technologies afin de suivre ou dépasser leurs adversaires, sans forcément se soucier de la protection civile. Les robots tueurs seraient en outre exposés au piratage.

Pour toutes ces raisons, l’ONG recommande une nouvelle loi afin d’assurer un contrôle humain sur ces machines, avec des règlementations et des interdictions. La dignité humaine serait respectée et la responsabilité reviendrait à la personne aux commandes. Enfin, le droit international humanitaire se concentrant uniquement sur l’utilisation des armes, cette loi permettrait d’atténuer les menaces à la sécurité, en concernant également le développement et la production de celles-ci.

Un désaccord entre pays

Autriche, Brésil, Mexique… Les pays sont nombreux à partager le point de vue de Human Rights Watch sur la nécessité de maintenir un contrôle humain sur ces machines. La France en fait partie. En avril dernier, le comité d’éthique de la défense a émis un avis sur le sujet : il s’oppose au développement et à l’emploi des SALA. Il est cependant favorable aux systèmes d’armes létaux intégrant de l’autonomie. L’humain resterait ainsi au cœur des décisions d’usage létal de la force, avec des robots capables de tuer, mais incapables d’agir seuls.

Si les avancées portant sur une nouvelle loi se retrouvent bloquées, c’est parce qu’un infime nombre d’États estime que cela est prématuré. Ce sont principalement des pays qui investissent dans le développement de systèmes d’armes autonomes, comme les États-Unis, le Royaume-Uni ou la Russie.