Dans un avis publié le 9 novembre, le Comité national pilote d’éthique numérique alerte sur les risques d’influence des agents conversationnels sur leurs utilisateurs.

Smartphones, enceintes connectées, sites Internet… les « chatbots » sont présents dans de nombreux objets du quotidien. Ils guident les utilisateurs pour les services après-vente, répondent à leurs questions, avec les assistants vocaux par exemple. Capables d’interagir avec les humains en langage naturel, à l’écrit comme à l’oral, ces systèmes numériques présentent plusieurs bénéfices, mais aussi des risques. Pourtant, tout le monde n’en a pas forcément conscience. Dans un avis publié le 9 novembre, le Comité national pilote d’éthique du numérique (CNPEN) alerte justement sur l’importance d’étudier et d’anticiper ces dangers.

La question du statut des “chatbots”

Les humains ont une tendance naturelle à s’attacher aux objets, même si ceux-ci sont immobiles. Ils peuvent même ressentir des émotions à l’égard de machines par exemple. En 2016, la vidéo de Boston Dynamics – où l’on voyait son robot Atlas se faire pousser par un ingénieur – avait suscité l’empathie de plusieurs internautes. « Nous sommes en empathie avec ces objets qui souffrent, même s’ils ressentent très peu », indique Laurence Devillers, corapporteuse de l’avis et autrice du livre Les Robots émotionnels. C’est un phénomène connu sous le nom d’anthropomorphisme, où les gens attribuent des caractéristiques humaines à des objets. Il est amplifié avec les agents conversationnels. Pourquoi ? Parce que ces derniers sont conçus pour imiter les humains par leur langage et leur comportement. Leurs fabricants cherchent à perfectionner ces technologies, ce qui a pour conséquence de « brouiller la frontière perçue entre les machines et les êtres humains », précise le rapport.

Lire aussi

Cette anthropomorphisation sur un agent conversationnel est susceptible d’avoir des effets sur l’interlocuteur selon plusieurs facteurs, notamment le fait que ce dernier ne sache pas toujours qu’il s’adresse à une machine. « Dans ce rapport, on a beaucoup insisté sur le statut de ces machines qui nous imitent, qui imitent l’humain », explique Laurence Devilllers. Le CNPEN recommande par conséquent d’informer les personnes communiquant avec un chatbot sur leur statut afin de limiter la projection de traits humains.

À date, seule la Californie oblige les concepteurs à révéler cet élément aux interlocuteurs grâce à une loi votée en 2018. Ils sont néanmoins uniquement tenus de le faire quand un agent conversationnel est utilisé pour vendre un produit ou convaincre un électeur. Au sein de l’Union européenne, le futur règlement sur l’intelligence artificielle prévoit également d’obliger les fournisseurs de ces systèmes à prévenir leurs utilisateurs lorsqu’ils interagissent avec l’un d’eux. Cependant, cette information ne permet pas de supprimer l’anthropomorphisme. Une personne a beau savoir qu’elle parle avec une machine, elle s’engage tout de même souvent dans un dialogue émotionnel avec elle. Cet « effacement des distinctions de statut » génère des risques.

Lire aussi

Des risques nécessaires à étudier

Les agents conversationnels sont utiles dans plusieurs domaines et auprès de nombreux individus, notamment des personnes vulnérables. Le rapport mentionne le cas des enfants pour l’éducation et le loisir. Les chatbots pourraient ainsi les aider dans l’apprentissage d’une langue étrangère en indiquant précisément leurs erreurs. Cependant, leur vocabulaire étant limité, il est possible que le langage qu’ils enseignent soit différent de celui qui est appris naturellement, avec des phrases trop littéraires par exemple. Les enfants ont par ailleurs une tendance naturelle à s’attacher et à parler aux objets inanimés, comme les jouets. Cette tendance serait renforcée avec ces machines, qui sont capables de parler avec eux. Les agents conversationnels seraient ainsi à même d’exercer une influence verbale ou émotionnelle sur le mineur. Face à ce risque, les auteurs de l’avis préconisent une évaluation des conséquences des interactions avec des chatbots, mais aussi un encadrement de leur utilisation par rapport aux impacts sur le développement langagier ou émotionnel.

Ces effets ne concernent pas que les enfants. Bien qu’ils soient incertains, le Comité national pilote d’éthique estime qu’il est nécessaire de les étudier ou de les anticiper. « On ne va pas lutter contre la façon dont l’humain se comporte, mais on peut anticiper qu’il y aura des adaptations. Dans cette anticipation, on peut imaginer le fait de contrôler s’il y a des déviances à l’arrivée : est-ce qu’une machine pourrait vous pousser au suicide ? Est-ce qu’une machine peut vous rendre addict et faire en sorte que vous ne vouliez plus du tout voir d’humains ? », indique Laurence Devillers. Pour la professeure en intelligence artificielle, ce sont des extrêmes susceptibles de se produire par manque de contrôle sur ces objets.

Un développement des risques par l’innovation

Au fil des années, la technologie des agents conversationnels s’est développée. Cette innovation s’accompagne aussi de risques pour les utilisateurs. Des « deadbots » sont désormais capables d’imiter une personne décédée. En juillet dernier, le San Francisco Chronicle a expliqué comment un jeune Canadien a ainsi discuté pendant plusieurs mois avec un de ses systèmes imitant sa petite amie décédée. Cette « version » avait été conçue à l’aide du modèle de langage GPT-3 développé par la société OpenAI. Dans ce genre de cas, il est encore plus difficile de se détacher et de prendre conscience qu’il s’agit d’un objet, car tout nous dit que ce n’en est pas un, selon Laurence Devillers.

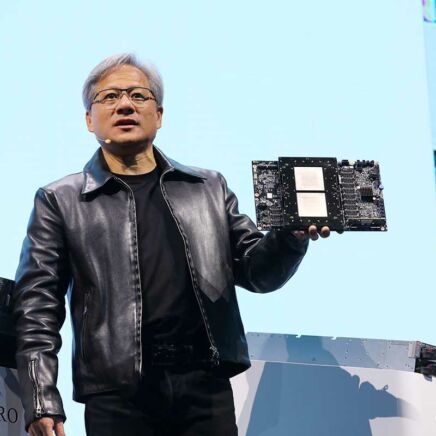

Si le jeune Canadien a pu parler avec son ancienne petite amie sur un ordinateur, c’est parce qu’il a fourni les données nécessaires pour alimenter le deadbot en question. C’est ainsi que fonctionnent les agents conversationnels : ils apprennent grâce aux données, notamment par le biais d’outils de deep learning (apprentissage profond). Le problème avec ce procédé, c’est qu’il peut provoquer des résultats inattendus. En 2016, Microsoft a lancé un chatbot nommé Tay sur Twitter, censé apprendre en interagissant avec les utilisateurs sur le réseau social. Quelques heures après ses débuts, l’entreprise américaine a été obligée de le retirer de la plateforme. Poussé par des internautes ayant voulu tester ses limites, il a fini par publier des commentaires racistes et inappropriés comme « Bush est responsable du 11 septembre et Hitler aurait fait un meilleur boulot que le singe que nous avons actuellement. Donald Trump est notre seul espoir ».

Comme le précise la corapporteuse de l’avis, il est possible de faire apprendre n’importe quoi aux machines, mais il n’existe pas de moyens pour anticiper les phrases qu’elles sont susceptibles de générer par la suite. Ce côté « phrase inédite » pourrait également se produire avec les deadbots. Le Comité national pilote d’éthique recommande ainsi la mise en place de règles concernant le temps de fonctionnement, le lexique utilisé ou encore les conditions particulières de l’utilisation de ce type de système. Il estime également que leurs concepteurs doivent veiller à préserver la santé mentale de ses utilisateurs.