Il est désormais possible d’utiliser une IA personnalisée sur son propre PC, pour peu que l’on dispose du matériel adéquat. Voici comment faire et ce qu’il faut savoir.

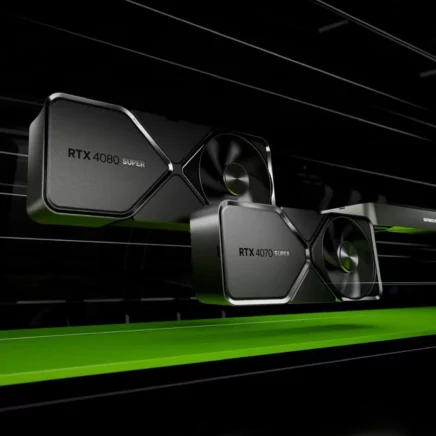

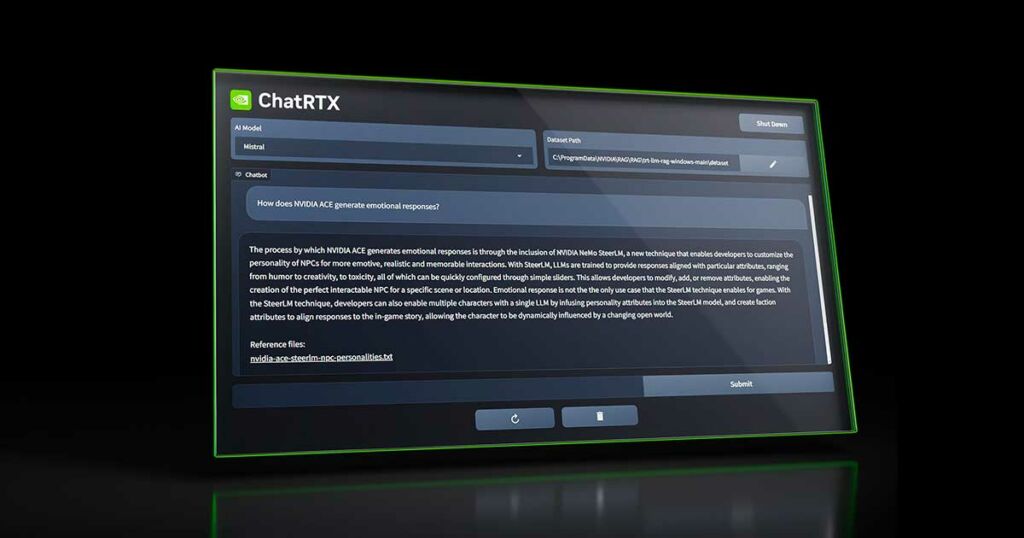

Depuis 2018, un nombre grandissant de composants de nos ordinateurs sont équipés de cartes graphiques accélératrices d’IA, ce qui leur permet d’utiliser localement des applications d’intelligence artificielle. Nvidia fut l’un des premiers à emprunter ce chemin pour le grand public et vient récemment de sortir un logiciel, Chat with RTX, qui vous permet désormais d’entraîner votre propre IA sur votre PC. En principe, Chat with RTX vous permet tout simplement de profiter d’une IA conversationnelle, comparable à celle proposée par le célèbre ChatGPT, sur votre PC. Disposer d’une telle application locale peut représenter un certain nombre d’avantages par rapport à une solution en ligne.

L’intérêt d’avoir une IA locale

Pour commencer, vos données restent privées et ne sont pas partagées avec des serveurs sur lesquels vous n’avez pas de contrôle; il n’y a donc pas de risque de collecte ou de vol de données, notamment si vous travaillez avec des documents que vous souhaitez garder privés. Ensuite, le fait de disposer d’une IA locale vous permet d’en choisir certains paramètres, notamment le LLM (Large Language Model, ou Grand Modèle de Langue en français).

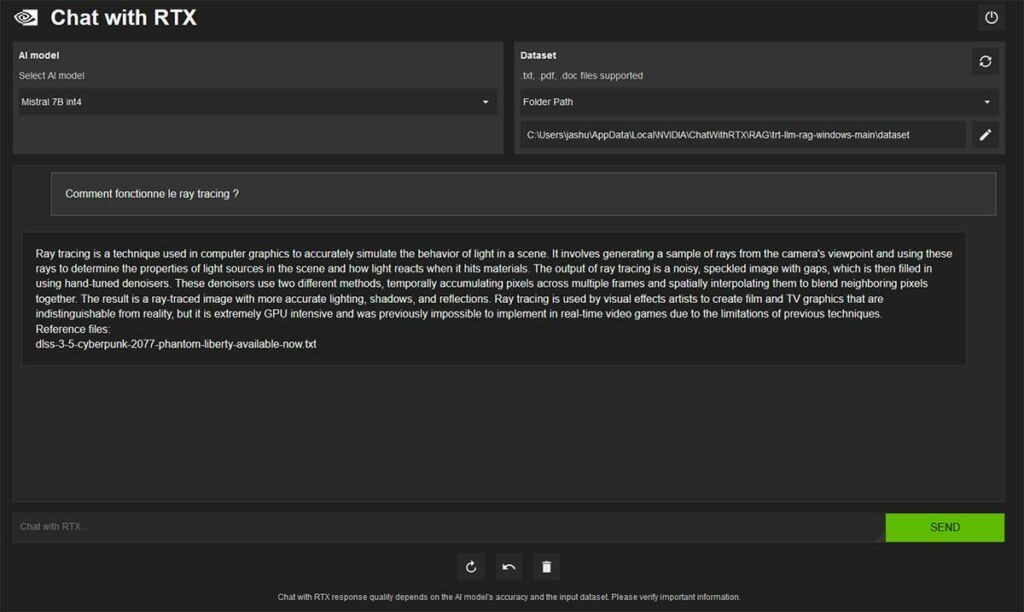

Il s’agit du moteur de votre IA, le système qui va lui permettre de générer les réponses qui vous seront fournies. Dans le cas de Chat with RTX, vous aurez le choix entre deux LLM : Mistral (un LLM indépendant développé en France) et Llama (développé par Meta). Enfin, cela vous donne également la possibilité de choisir les données sur lesquelles l’IA va se baser pour vous fournir des réponses précises. Vous pourrez, par exemple, lui indiquer le chemin du dossier contenant vos documents de travail, lui demander de vous résumer la journée d’hier et les tâches restant à accomplir, et elle vous fournira une réponse en indiquant les documents sur lesquels elle s’appuie. Nvidia indique que pour l’instant, l’IA n’est compatible qu’avec les fichiers de type TXT, DOC et PDF. Il est également possible d’utiliser des sources externes et vous pouvez, par exemple, lui fournir le lien vers une vidéo YouTube et lui demander de vous en résumer le contenu.

Il y a toutefois quelques contraintes à prendre en compte pour utiliser Chat with RTX. Pour commencer, le programme n’existe qu’en anglais pour le moment, bien qu’il semble raisonnable de penser qu’une mise à jour future inclura le français. Pour être clair, rien ne vous empêche de parler à l’IA en français, ou encore de lui fournir des documents sources en français, mais ses réponses, aussi précises qu’elles soient, seront invariablement en anglais. Ensuite, il sera nécessaire de disposer d’une machine compatible pour en profiter. Nvidia impose la possession d’une carte graphique GeForce RTX de la série 30 ou 40, et équipée d’au minimum 8 Go de mémoire vidéo. Sur ce point, il semble, selon nos tests, que 8 Go soit juste suffisant pour utiliser Mistral, tandis que Llama 2 nécessitera au moins 16 Go de mémoire vidéo.

Installer Chat with RTX

Pour le reste, Nvidia recommande au moins 16 Go de mémoire centrale, des pilotes à jour, ainsi que beaucoup d’espace de stockage. En effet, le simple téléchargement du programme (sur le site de Nvidia) occupera 35 Go avant sa décompression. L’installation, quant à elle, nécessitera de télécharger les fameux LLM d’une taille imposante. Au total, l’installation de Chat with RTX nécessitera un peu moins de 100 Go disponibles sur votre machine, et sa durée dépendra surtout de la vitesse de votre connexion à Internet. Dans certains cas, l’installation complète peut prendre plus d’une heure.

Une fois l’installation terminée, vous noterez que l’interface de Chat with RTX s’utilisera via votre navigateur. Cela ne signifie pas que vous êtes en ligne : tout est géré localement et le navigateur agit simplement comme une interface entre vous et le LLM. À partir de cette interface, vous pourrez choisir votre modèle ainsi que le dossier dans lequel celui-ci travaillera pour fournir ses réponses (un dossier par défaut est déjà présent avec l’installation pour tester vos premières requêtes). Dans ce champ, vous pouvez choisir un dossier contenant les documents que vous voulez que l’IA utilise (rappelez-vous qu’elle ne travaille pour l’instant que sur les fichiers TXT, DOC et PDF) ou y entrer l’adresse d’une vidéo YouTube.

Les alternatives à Chat with RTX

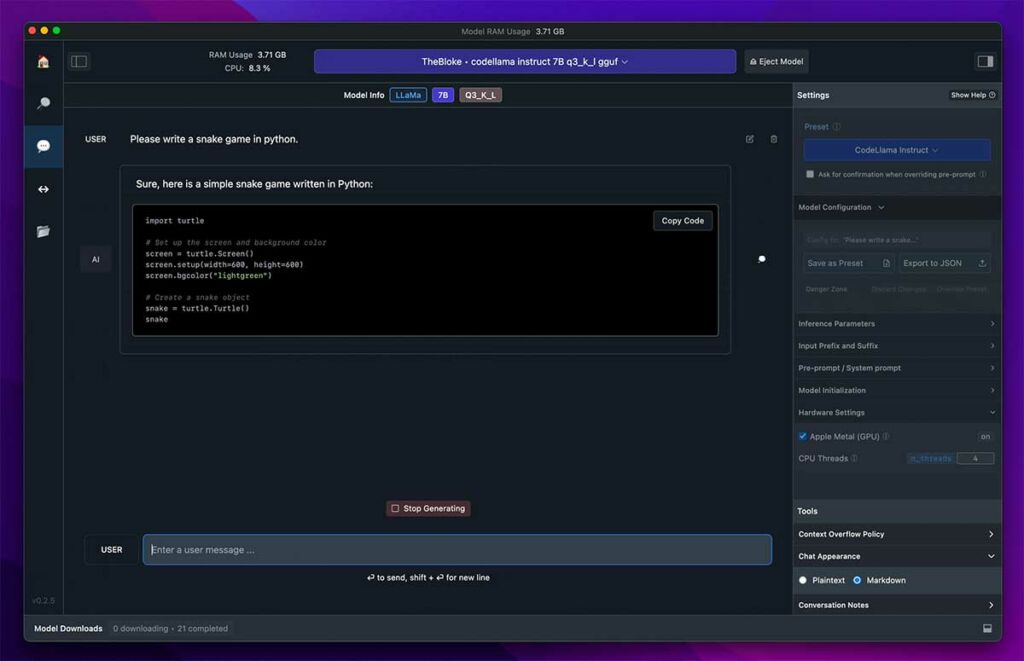

Comme nous l’avons vu, Chat with RTX nécessite avant tout de disposer d’une carte graphique de marque Nvidia suffisamment récente et puissante pour pouvoir s’exécuter. Mais si ce n’est pas votre cas, tout espoir n’est pas perdu pour utiliser votre propre IA en local. Depuis peu, AMD propose également dans ses CPU et GPU des unités d’accélération d’IA qui, avec le bon logiciel, sont capables de reproduire l’expérience de Chat with RTX sur votre machine. Aussi, les Radeon 7000, de la dernière génération, disposent de telles unités de calcul, et bien qu’elles n’aient pour l’instant que peu d’usages mis en avant par AMD, des logiciels tiers comme LM Studio pourront vous permettre de les exploiter.

LM Studio vous permet, de la même manière que Chat with RTX, d’utiliser un LLM localement sur votre ordinateur. Le logiciel est téléchargeable gratuitement, mais n’est pas équipé d’un modèle par défaut et vous laissera le choix de le télécharger vous-même. Parmi quelques exemples de modèles libres et gratuits, vous trouverez Mistral et Llama 2, mais aussi Bloom, conçu pour la recherche scientifique. Vous trouverez de nombreux modèles libres à essayer sur le site Hugging Face, qui les recense, et une fois votre modèle téléchargé, il suffit d’indiquer l’emplacement de ses fichiers à LM Studio pour pouvoir l’utiliser. LM Studio recommande de disposer d’au moins 16 Go de mémoire vive et 6 Go de mémoire vidéo pour fonctionner, mais notez que le modèle que vous choisirez aura lui aussi ses propres spécifications techniques pour tourner sur votre machine. Une fois le modèle choisi installé, vous pourrez là encore lui fournir un set de données et poser des questions à votre IA.

Vous voilà prêt à créer votre propre IA taillée pour vos besoins. Rappelez-vous cependant qu’étant donné que votre IA tournera localement, les résultats ne seront pas toujours aussi précis et pourront parfois nécessiter plus d’attente qu’un service en ligne comme ChatGPT, qui fonctionne sur des serveurs beaucoup plus puissants qu’un PC de bureau. Pour l’instant, le matériel et les logiciels en sont à leurs débuts, et les performances iront en s’améliorant à l’avenir, mais les outils déjà disponibles constituent une bonne introduction aux capacités des IA actuelles.