Bénéfique à bien des égards, l’intelligence artificielle est aussi une technologie qui fait peur à nombre d’entre nous, pour plusieurs raisons.

67 %, c’est la part de Français qui voient l’intelligence artificielle (IA) comme une menace, d’après un sondage publié en juin. Une perception liée à un sentiment de vulnérabilité et à la crainte d’être dépassé par cette technologie. Bien que l’IA offre de nombreux bénéfices, elle en inquiète plus d’un, à commencer par Elon Musk, qui avertit sur les dangers de celle-ci depuis plusieurs années. Fin mai, des centaines d’experts et chefs d’entreprise du secteur ont également alerté sur la menace existentielle que cette technologie représente pour l’humanité. Mais pourquoi l’IA fait-elle si peur ? Explications.

Une peur liée à un malentendu

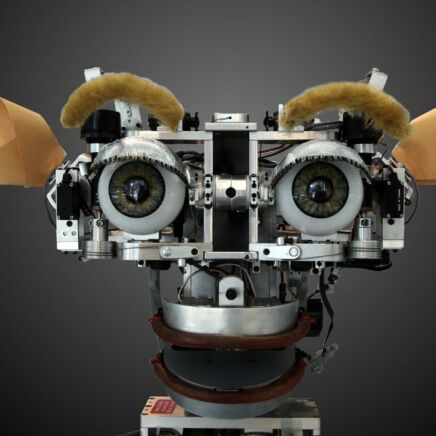

Selon Jean-Gabriel Ganascia, professeur d’informatique à la faculté des sciences de Sorbonne Université et spécialiste en IA, la raison pour laquelle nous craignons cette technologie depuis sa naissance tient à un malentendu. « On pense que l’intelligence artificielle a pour objet de fabriquer des objets qui s’animent et donc qui nous dépassent, un peu comme si on se mettait à la place du Créateur et que l’on créait à sa place. C’est une très vieille crainte qui est ancrée dans le cœur de l’homme, celle de voir sa propre œuvre, tout d’un coup, prendre son autonomie », explique-t-il.

Cette peur est, de plus, différente selon les cultures, avance Jean-Gabriel Ganascia : « Au Japon, on m’a expliqué qu’il y avait une tradition animiste et qu’attribuer un esprit à une machine n’était pas inhabituel. Ça posait donc moins de problèmes. C’est peut-être la tradition judéo-chrétienne qui conduit à cette peur de l’intelligence artificielle. »

La peur de l’IA peut également être liée aux films de science-fiction comme 2001, L’Odyssée de l’espace avec le supercalculateur doté d’IA HAL 9000 qui contrôle le vaisseau spatial. Ils sont le reflet de cette inquiétude ancrée dans le cœur des humains, selon le spécialiste en IA. « Les questions que posaient les films de science-fiction comme 2001, L’Odyssée de l’espace ou HER sont devenues des réalités », alerte, de son côté, Laurence Devillers, professeure en IA à Sorbonne Université et directrice de recherche au CNRS – LISN (Laboratoire Interdisciplinaire des Sciences du Numérique ).

Des peurs plus proches de la science-fiction

Si la science-fiction peut, en partie, expliquer les craintes autour de l’IA, certaines relèvent plus du fictif que de la réalité. Tel est le cas de l’intelligence artificielle générale (IAG) dans le futur, soit un système capable de penser, d’apprendre et de comprendre comme un humain. Cela, « car les pseudo experts et certains industriels transhumanistes entretiennent les ambiguïtés et la possibilité que demain, l’IA dépasse l’intelligence humaine sans préciser pourquoi, sur quels sujets, etc. », justifie Laurence Devillers, ajoutant que « ces peurs fantasmagoriques sont agitées devant nous pour nous empêcher de penser aux problèmes éthiques actuels dus au développement de l’IA ».

L’idée qu’une machine ait une conscience n’a pas de sens, estime, de son côté, Jean-Gabriel Ganascia. L’intelligence artificielle étant une discipline empirique, elle consiste à modéliser les différentes facultés cognitives pour ensuite les confronter aux capacités humaines. Les progrès de cette technologie ces 70 dernières années ne signifient pas pour autant que l’on parviendra à l’IAG dans le futur. « L’intelligence artificielle générale, c’est l’idée que l’intelligence serait une substance. Or, l’intelligence n’est pas une quantité, c’est la résultante de facultés mentales et ce sont ces facultés que l’on simule sur la machine », explique le professeur d’informatique.

« L’IA fait peur avec raison, car elle peut remplacer de nombreux métiers et de nombreuses pratiques dans la société. »

Laurence Devillers

De cette idée est né le malentendu selon lequel les machines pourraient, un jour, être dotées de conscience. Il vient aussi d’une autre notion très ancienne, le QI, soit l’idée de pouvoir mesurer l’intelligence des individus. « C’est quelque chose qui est scientifiquement non fondé, car il y a une diversité des intelligences. Une personne qui sera meilleure en maths sera peut-être moins bonne pour d’autres capacités cognitives qui sont extrêmement importantes. D’ailleurs, le QI lui-même est fondé sur un certain nombre d’épreuves plus ou moins développées, donnant des résultats plus ou moins bons selon les personnes », souligne Jean-Gabriel Ganascia.

Une crainte justifiée

La peur de l’IA peut par ailleurs être justifiée par les dangers de cette technologie. Elle est notamment considérée comme une menace par de nombreux employés craignant d’être remplacés par celle-ci. « L’IA fait peur avec raison, car elle peut remplacer de nombreux métiers et de nombreuses pratiques dans la société », affirme Laurence Devillers, ajoutant qu’il est nécessaire « d’apprendre à vivre en interaction avec ces nouvelles machines “intelligentes” dès à présent ».

Utiles dans de nombreux domaines, les systèmes génératifs comme ChatGPT d’OpenAI ou Bard de Google inquiètent aussi, pouvant notamment générer de fausses informations sur des individus. Un animateur de radio américain a par exemple déposé plainte contre le créateur de ChatGPT en juin, après que le chatbot l’a accusé à tort d’avoir fraudé et détourné des fonds d’une organisation à but non lucratif. Ces systèmes « construisent des scénarios sans se préoccuper de la véracité, ils ne s’occupent que de la vraisemblance, car ils alignent les mots les uns à la suite des autres », précise Jean-Gabriel Ganascia.

« Ces technologies vont continuer à se déployer et à jouer un rôle extrêmement important, et cela est essentiel, car nous sommes dans une société de l’information. »

Jean-Gabriel Ganascia

Outre les erreurs commises par ces IA, elles peuvent aussi être utilisées pour créer de faux contenus susceptibles de causer de réels dégâts, à l’instar de la fausse image d’une explosion au Pentagone devenue virale sur Twitter, qui a provoqué une chute des marchés financiers. Amplifiant la diffusion massive de faux contenus, « les futurs ChatGPT risquent de faire chuter le niveau de connaissances collectives s’ils sont nourris de données artificielles venant de ces systèmes », met en garde Laurence Devillers.

Entre bénéfices et dangers

Au-delà de la peur de l’IA, les deux experts partagent leur inquiétude concernant les créateurs de ces systèmes, avec une concentration rapide du pouvoir et des données aux mains des principales entreprises du secteur. « Le principal risque est qu’une poignée d’entrepreneurs ou de gouvernements non éthiques gouvernent le monde. L’IA amène un énorme pouvoir de manipulation de masse », alerte la chercheuse. « Ce qui m’inquiète, c’est qu’on rentre dans un monde où de nouveaux acteurs vont jouer un rôle de plus en plus important et qui risquent de nous rendre esclaves. Aujourd’hui, ces acteurs sont plus puissants que les États », avertit également Jean-Gabriel Ganascia.

Malgré les risques et les craintes autour de l’IA, les deux experts restent optimistes concernant le futur de cette technologie. Pourquoi ? Parce que « l’Europe veut se doter des moyens de réguler les IA et les chercheurs et académiques alertent de plus en plus les gouvernements et les citoyens des risques de l’utilisation de ces outils. Nous allons peut-être apprendre à nous servir de ces outils intelligemment en évitant les apprentis-sorciers et en même temps sans prendre de retard pour notre économie », justifie Laurence Devillers.

Souhaitant encadrer cette technologie, l’Union européenne travaille en effet sur un projet de loi – l’AI Act – qui a récemment été approuvé par le Parlement, ouvrant la voie aux négociations pour le finaliser.

Autre raison : à une époque où les technologies de l’information et de la communication occupent une place importante dans notre société, l’IA apporte des bénéfices dans de nombreux domaines, comme la santé, avec les progrès en termes de diagnostic médical. « Ces technologies vont continuer à se déployer et à jouer un rôle extrêmement important, et cela est essentiel, car nous sommes dans une société de l’information. Ces flots d’informations doivent donc être traités et l’IA est capable de les traiter », assure Jean-Gabriel Ganascia.