Disponible uniquement aux États-Unis depuis décembre, cette fonction sera prochainement déployée dans plusieurs pays, mais pas encore en France.

Apple souhaite que les enfants puissent communiquer en toute sécurité sur ses différents appareils. En décembre, l’entreprise californienne a introduit une fonctionnalité appelée « sécurité des communications dans les Messages » aux États-Unis, par le biais d’une nouvelle version de son système d’exploitation mobile. Elle sera prochainement disponible pour les messages sur iOS, iPadOS et macOS au Royaume-Uni, au Canada, en Nouvelle-Zélande et en Australie.

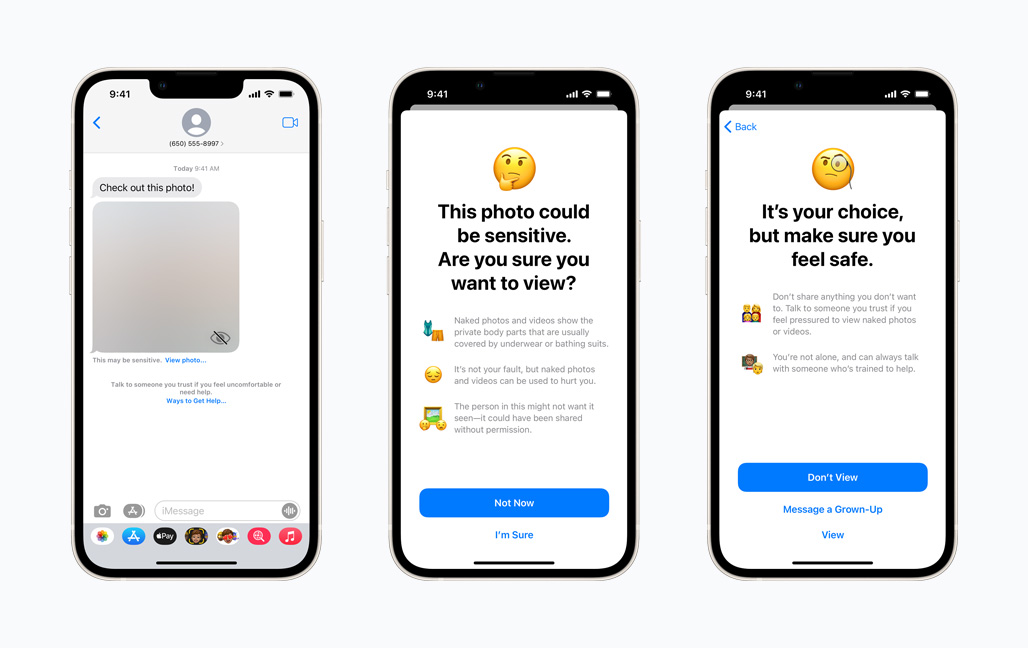

Une fois activée, cette fonctionnalité permet de protéger les enfants contre les images contenant de la nudité. Lorsqu’un mineur reçoit ce type de contenu, la photo est floutée et il est averti que celle-ci peut être sensible. Il peut ainsi choisir de voir ou non l’image en question. L’application Messages propose également plusieurs moyens pour l’aider, comme quitter la conversation, bloquer le contact ou encore accéder à des ressources de sécurité en ligne. La photo est aussi floutée lorsqu’un enfant tente d’envoyer une image dénudée. Des conseils et des ressources adaptés à son âge lui sont fournis pour l’aider à faire un choix sûr.

Des fonctionnalités pour assurer la sécurité des enfants

Que ce soit pour la réception ou l’envoi de photos contenant de la nudité, les enfants peuvent obtenir de l’aide en envoyant un message à une personne de confiance s’ils le souhaitent. Par ailleurs, dans le cas où le mineur est âgé de moins de 13 ans, l’application Messages l’invite à entamer une conversation avec ses parents.

Pour détecter l’envoi et la réception de ce type de contenu, l’application d’Apple utilise l’apprentissage automatique. Cette forme d’intelligence artificielle lui permet d’analyser les images et de déterminer si une photo semble contenir de la nudité. De plus, Apple affirme avoir conçu sa fonctionnalité pour que la firme n’ait pas accès aux photos. Les indications de détection de nudité restent ainsi au sein de l’appareil et l’entreprise ne peut pas voir les messages qui sont toujours chiffrés de bout en bout.

Enfin, Apple a étendu le déploiement d’une autre fonctionnalité pour les recherches avec Siri, Safari et Spotlight. Elle dirige les utilisateurs vers des ressources de sécurité lorsqu’ils cherchent des contenus liés à l’exploitation des enfants. Ils sont également informés que l’intérêt pour ce sujet est nuisible et problématique.