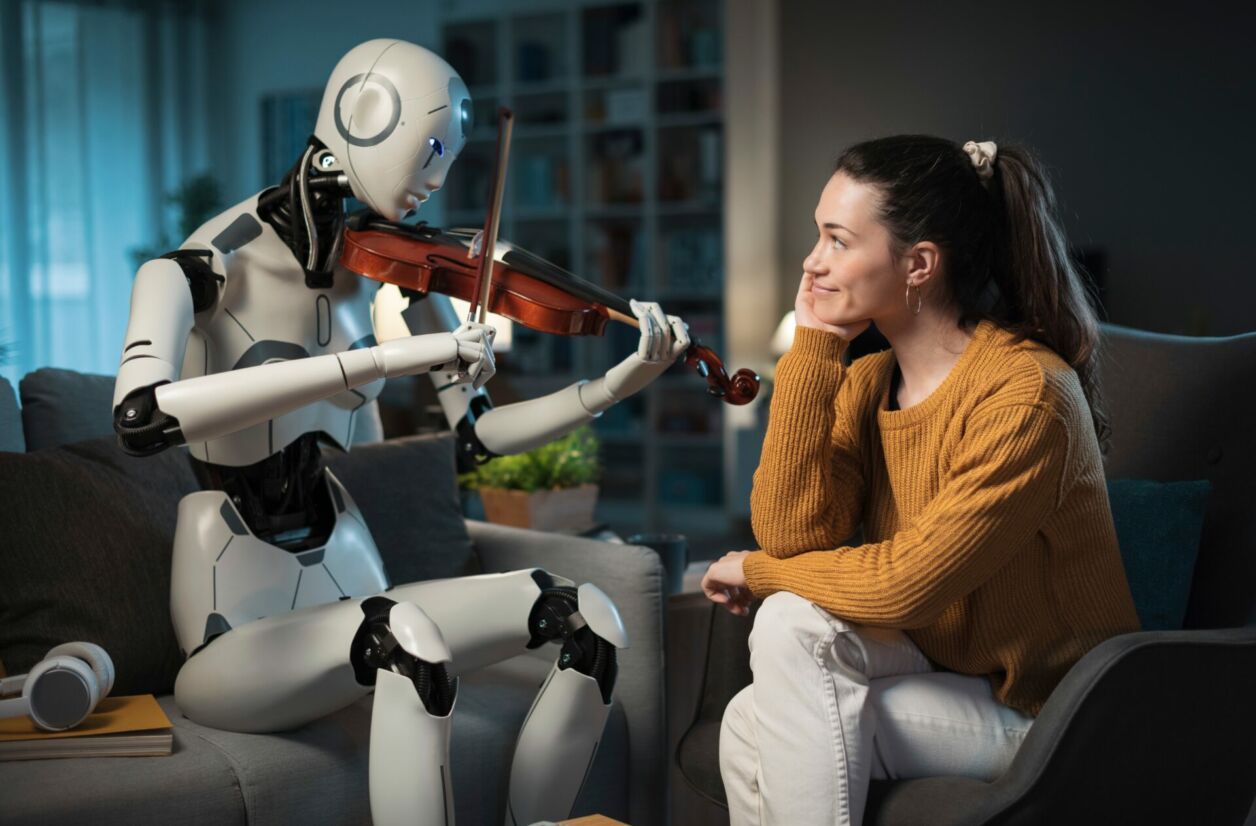

L’intérêt des mathématiciens et chercheurs pour la musique ne date pas d’hier. De l’imagination de Boris Vian aux morceaux composés sans intervention humaine, état des lieux des apports et des risques de l’intelligence artificielle dans la musique.

En 1947, Boris Vian imaginait le pianocktail, un instrument de musique composant à la volée des cocktails en s’inspirant des notes jouées par le pianiste. Complètement délirante à l’époque, cette invention nous semble aujourd’hui très contemporaine, tant nous avons pris l’habitude d’être confrontés à des intelligences artificielles piochant dans des bases de données et interprétants des instructions pour créer des images, des textes, des sons ou des vidéos bluffantes de réalisme.

Pourtant, l’idée de faire composer de la musique à des cerveaux artificiels n’a rien de nouveau. Retour aux origines de l’informatique moderne, dans les années 1950.

Premières tentatives, premières mélodies

Dès 1951, le mathématicien Alan Turing a entrepris d’utiliser des ordinateurs pour créer de la musique. Il ne s’agissait pas alors de créer des pistes originales, mais bien de prouver qu’une machine pouvait programmer et jouer une partition simple : un véritable exploit pour l’époque.

En 1957, deux compositeurs américains poussent le concept beaucoup plus loin. En utilisant un ordinateur ILLIAC 1 de l’Université du Michigan, Lejaren Hiller et Leonard Isaacson entrent une suite d’instructions et de règles, laissant les circuits de la machine assembler le tout en un morceau cohérent. Le résultat est Illiac Suite for String Quartet, généralement considéré comme le premier morceau créé par une intelligence artificielle.

Il ne faudra que quelques années de plus pour que les universités soviétiques rejoignent les chercheurs américains sur la question : en 1960, le mathématicien Rudolf Khafizovich Zaripov publie le premier article consacré aux algorithmes musicaux. Dès lors, les tentatives de créer des pièces originales via des instructions précises susurrées à des cerveaux artificiels se multiplient.

La première machine capable de composer automatiquement des morceaux de piano dans différents styles est créée en 1965 par l’inventeur américain Ray Kurzweil, alors âgé de seulement 17 ans. L’invention a un côté gadget, mais prouve qu’il est possible d’aller plus loin dans le domaine. Les années 1970 et 1980 donneront raison à Kurzweil : la composition automatique est un champ d’investigation scientifique à fort potentiel.

Des progrès rapides dans les années 1970 et 1980

Entre 1973 et 1980, de nombreuses initiatives universitaires se penchent sur la création de musique par intelligence artificielle. Le MIT ouvre un studio dédié, une conférence internationale sur la musique générée par ordinateur est organisée annuellement, et, finalement, une avancée majeure a lieu en 1980.

David Cope, de l’Université de Californie, met cette année-là au point le très impressionnant EMI (Experiments in Music Intelligence), un système permettant de générer des modèles non pas basés sur de simples règles et algorithmes, mais sur des morceaux déjà existants. En clair : EMI était capable « d’assimiler » le style de Mozart ou des Rolling Stones et de composer des mélodies dans le même registre.

Il devient dès lors possible d’imaginer la création d’albums instrumentaux complets, alors que se pose déjà la question des droits liés à ces musiques. Entre l’EMI, David Cope et feu Vivaldi lui-même, qui est le « véritable » créateur du morceau ? La question continue de diviser les spécialistes 40 ans plus tard.

Un objet de vague curiosité pour l’industrie musicale

La musique générée par IA reste cependant longtemps l’apanage des laboratoires de recherche et intéresse encore peu l’industrie du disque. Seul Sony semble alors suivre d’assez près le sujet en fondant le Sony CSL en 1988, un laboratoire privé situé à Paris et chargé de développer des technologies informatiques avancées, dont des outils destinés à la génération musicale.

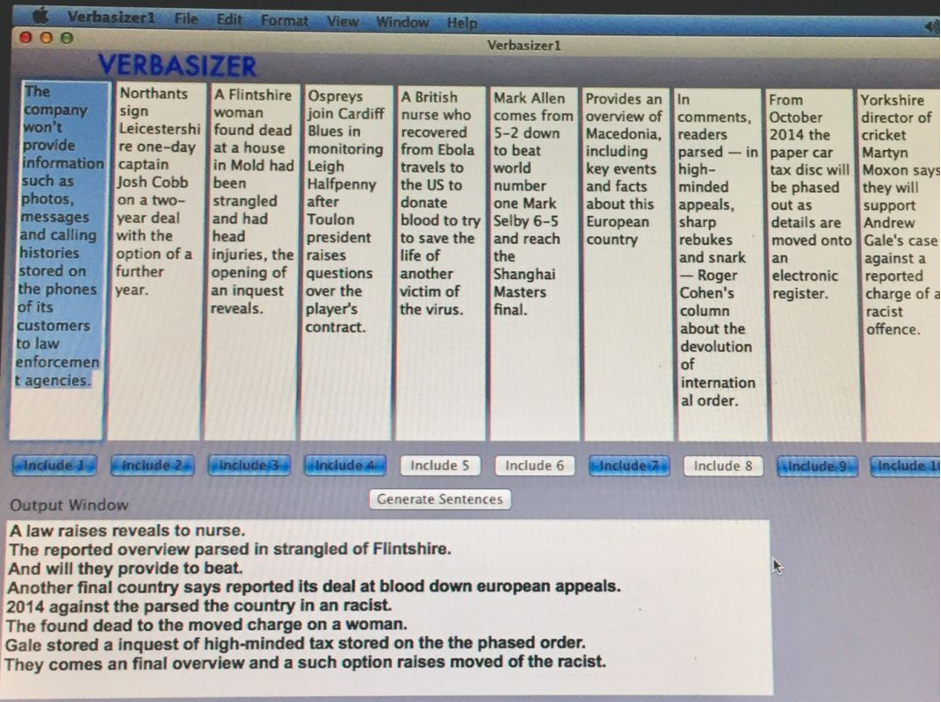

Mais, à ceci près, les innovations liées à ce type de morceaux resteront longtemps lettre morte. Il convient cependant de noter une exception : la collaboration durant les années 1990 entre le musicien David Bowie et le programmeur Ty Roberts pour créer le Verbasizer, un outil chargé de piocher dans un corpus de mots, de phrases et de textes pour composer des paroles de chanson. Le résultat sera régulièrement utilisé pour composer des chansons de Bowie lui-même.

Cette relative indifférence des acteurs de la création musicale n’empêche pas les progrès technologiques de s’accumuler en la matière : en 1995, l’Imagination Engine parvient à générer plus de 10 000 mélodies cohérentes dans des styles variés. En 2002, les équipes de François Pachet du SCL créent un programme capable de continuer à improviser sur un début de musique. En 2009, le programme Emily Lowell crée un album entier en tenant compte des retours des auditeurs pour corriger certaines mélodies.

L’ordinateur Iamus, de l’université de Malaga, enfin, compose fin 2010 ses propres morceaux originaux de musique classique non retouchés par une main humaine. Et si le résultat est parfois un peu rude à l’oreille, il reste techniquement bluffant.

Une explosion et une démocratisation du contenu depuis quelques années

Il faudra finalement attendre le milieu des années 2010 pour que le grand public commence à découvrir plus largement ces technologies et à s’en emparer. En 2016, le logiciel AIVA fait sensation en permettant de générer à la volée des morceaux de classique originaux, tandis que Sony publie le très impressionnant Daddy’s Car, une chanson imitant à la perfection le style des Beatles. Les chansons IA deviennent rapidement relativement indiscernables à l’oreille de celles composées de manière plus traditionnelle.

L’industrie musicale rattrape alors son retard. Des sociétés comme Jukin Media se mettent à générer et à vendre des morceaux composés par des algorithmes pour des bandes originales de films, de série ou de publicités, tandis que des internautes plus anonymes peuvent s’essayer facilement à la création d’étonnantes chansons de Noël horrifiques écrites par des robots.

L’accès plus simple et plus large à ces technologies, soutenu par les géants de la tech et de grands noms de la pop musique s’est accompagné d’un fort développement des techniques d’imitation vocales. Il est depuis quelques années tout à fait possible de singer à la quasi-perfection la voix, les mimiques et le timbre de n’importe quel chanteur ou groupe connu, au risque de voir se créer de véritables contrefaçons. Ces dernières sont parfois purement humoristiques, mais parfois relativement problématiques au regard de la conception actuelle du droit à la propriété intellectuelle.

Difficile d’ailleurs de dire quelle place prendra la musique générée par IA dans les prochaines années dans le domaine de la création musicale. La démocratisation du procédé a en effet été extrêmement rapide, et son utilisation est, pour le moment, un véritable Far West législatif.

Certaines applications expérimentales et créatives d’ores et déjà en circulation sont néanmoins véritablement fascinantes, à l’image du groupe Yacht entraînant des IA à jouer sur leur propre catalogue pour composer de nouveaux morceaux, ou du All Music Project cherchant à composer… toutes les mélodies mathématiquement possibles. Nous ne sommes donc qu’au tout début de nos surprises en la matière !