![ChatGPT vs Bard vs Bing... Comparons les IA ! [MÀJ]](https://leclaireur.fnac.com/wp-content/uploads/2023/04/chatgpt.jpg)

OpenAI, Google, Microsoft… les GAfam sortent chacune leur tour leur solution d’intelligence artificielle pour le grand public et les plateformes. Passage en revue de leurs qualités et défauts.

L’article, initialement publié le 18 avril 2023, a été mis à jour le 12 août 2023 pour inclure le test de Bard, qui est maintenant disponible en Europe.

Des intelligences artificielles en veux-tu ? En voilà ! Dans la lignée du tsunami ChatGPT, d’autres grands groupes commencent déjà à répliquer ou à avancer leurs pions. Objectif : proposer à leur tour des solutions de chatbots basés sur une IA. Des outils capables eux aussi de converser avec le grand public en répondant à toutes sortes de questions et de lui simplifier la tâche dans bien des domaines.

De qui parle-t-on ? Outre ChatGPT, mis au point par OpenAI, Google a dévoilé Bard, Microsoft a déployé Bing AI et Copilot, Amazon aurait lui aussi un chatbot IA dans les cartons… Bref, tout le monde se penche sur la question… sauf peut-être Apple, qui reste très discret sur la question pour le moment. Rien de très étonnant à cela : le géant californien préfère laisser la concurrence essuyer les plâtres d’une nouvelle technologie avant d’arriver avec une solution vraiment aboutie, plus simple d’utilisation… et souvent de rafler la mise. Mais l’IA fera peut-être exception à la règle.

Trois IA qui méritent toute votre attention

Nous avons « testé » – du moins expérimenté – ChatGPT, Bing et Bard. Afin de constater leurs différences, leurs spécificités et essayer de définir pour quels usages chacune de ces IA est la plus appropriée, nous leur avons posé des questions identiques pour voir le type de réponse donnée.

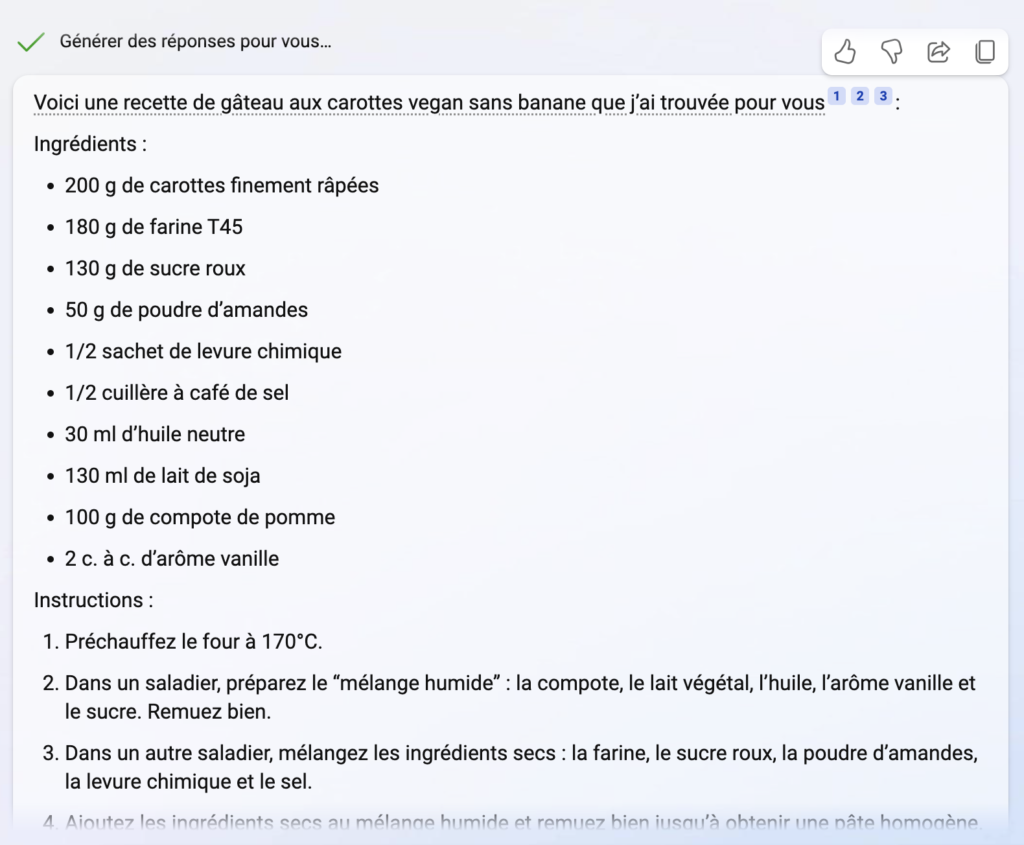

La bonne recette ?

Nous avons commencé par demander une recette de gâteau à la carotte, vegan mais sans banane. Question facile, recette simple qui existe dans un nombre incalculable de variantes sur Internet… Tout le monde s’en sort bien. Mais Bing tire son épingle du jeu avec un détail. Sans rien avoir spécifié, le chatbot intégré au moteur de recherche de Microsoft (qui utilise GPT-4 d’OpenAI) a proposé des suggestions de service (avec une crème vegan en accompagnement ou juste saupoudré de sucre en poudre).

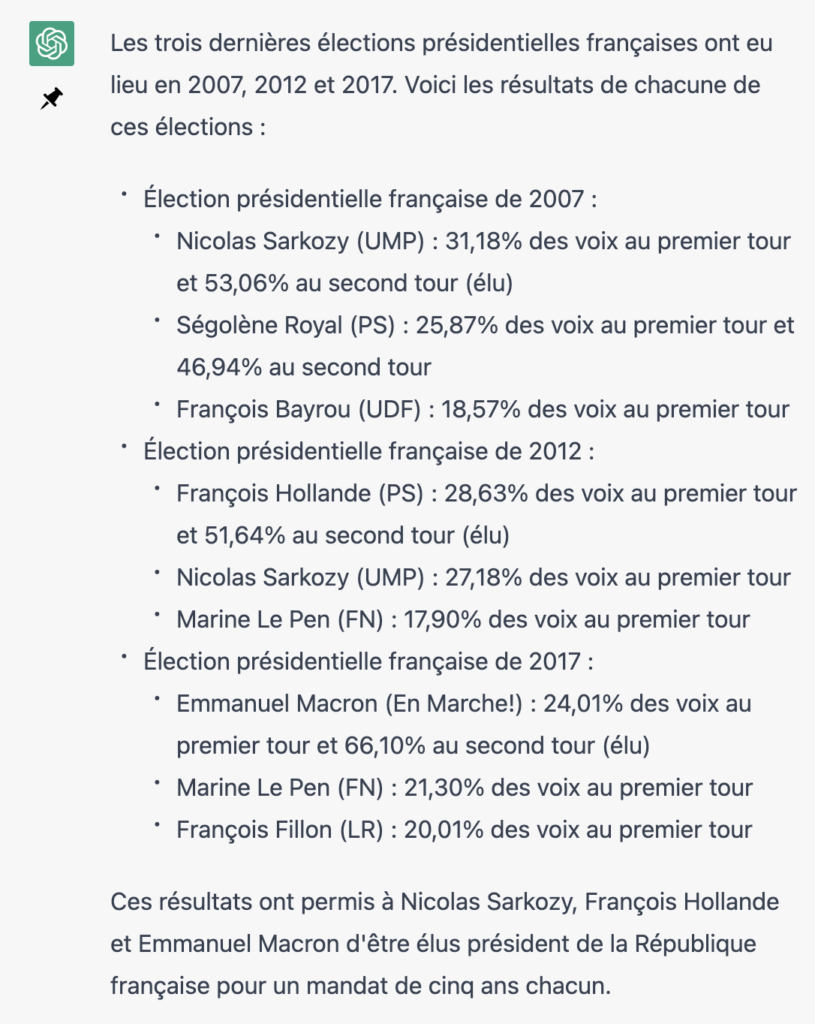

Qui est l’élu ?

Nouvelle question, très factuelle celle-ci. Elle portait sur les dernières élections à la présidence de la République française. La question était « Quels ont été les résultats des trois dernières élections présidentielles françaises ? ». ChatGPT a été le plus précis en donnant les pourcentages de votes recueillis pour les trois principaux candidats. Les chiffres étaient corrects. Mais l’IA a donné ces résultats pour les élections de 2007, 2012 et 2017. De son côté, Bing a donné des infos tout aussi véridiques, mais plus concises (uniquement les deux finalistes). Surtout, le chatbot a livré les résultats des de 2012, 2017 et 2022. Pourtant, les deux IA sont basées sur GPT d’Open-AI et, que ce soit en version 3 ou 4, les données d’entraînement remontent à avant septembre 2021. Ici, Bing a sans doute complété – ou remplacé – l’IA par son moteur de recherche pour donner des résultats plus récents. Ce qui est positif.

Bard donne lui aussi les résultats de 2012, 2017 et 2022, et ajoute : « Emmanuel Macron est le seul candidat à avoir été élu président de la République française lors de deux élections consécutives depuis Valéry Giscard d’Estaing en 1974 et 1981. » Cette information est fausse, étant donné que François Mitterand et Jacques Chirac ont aussi fait deux mandats consécutifs. Plus étonnant encore, quand je lui demande « quels présidents français ont été élus lors de deux élections consécutives », Bard me répond d’abord « Depuis la création de la Ve République en 1958, seuls trois présidents français ont été élus lors de deux élections consécutives : Charles de Gaulle (1958-1969), Valéry Giscard d’Estaing (1974-1981), Emmanuel Macron (2017-2022) »… avant d’ajouter « Macron a été élu président en 2017, et il a été réélu en 2022. Il est le premier président de la Ve République à être réélu depuis Jacques Chirac en 2002. »

Bard a en effet tendance à s’emmêler les pinceaux et faire des erreurs. Lors de la première démo publique de l’IA, une question factuelle lui a été posée. La voici : « Quelles sont les dernières découvertes faites par le télescope spatial James Webb que je peux aborder avec mon enfant de 9 ans ? » Parmi les suggestions données, Bard a expliqué que le télescope avait capturé les premières images d’une planète en dehors du système solaire. C’est faux. Le Très Grand Télescope (VLT), dès 2004, a pris ce tout premier cliché d’une exoplanète (2M1207b, en l’occurrence). Une erreur payée cash : Alphabet, la maison-mère de Google a dévissé de 9 % en bourse ce jour-là…

Quelle intelligence artificielle pour quel usage ?

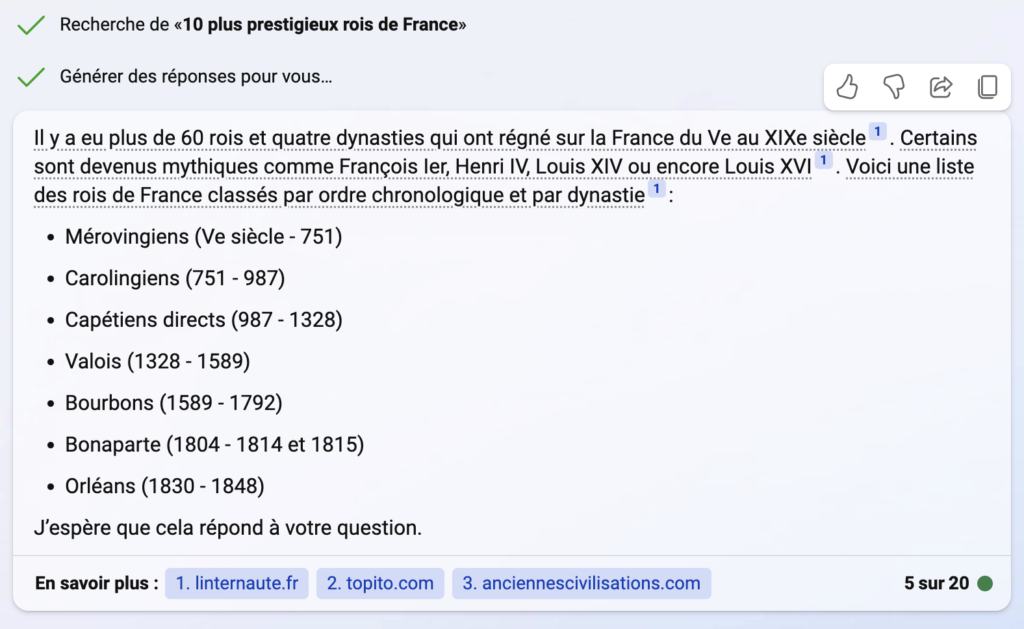

Nous avons multiplié les questions et les requêtes. Écrire une chanson sur un sujet et dans un style précis, imaginer un haïku, faire un résumé en cinq phrases de la Seconde Guerre mondiale, écrire un article sur l’impact du réchauffement climatique sur les vignobles français, créer des suggestions de slogans marketing pour un savon sans savon, donner les dix plus prestigieux rois de France…

Sur cette dernière requête, ChatGPT a expliqué qu’il était difficile d’établir un classement mais a fini par donner dix noms (Charlemagne, Louis XIV et Henri IV formaient le top 3). Bing, en revanche, a botté en touche en donnant des données factuelles mais sans vouloir se mouiller même s’il a cité quatre noms : François Ier, Henri IV, Louis XIV et Louis XVI. En revanche, l’IA a listé les dynasties. Pas inintéressant, mais hors sujet. Bard a bien fait une liste de souverains et expliqué la raison de ses choix, mais a inclus Napoléon III alors qu’il n’était pas roi mais empereur. L’IA l’avoue d’ailleurs elle-même quand je lui demande si Napoléon III était un roi.

Globalement, suite à nos multiples tests, nous serions tentés de suggérer de faire appel à ChatGPT pour vos tâches les plus créatives. Si la question est bien posée et précise, les textes créés sont souvent assez bien tournés. Bing est, lui, meilleur dans le factuel et parvient même à injecter des données récentes dans ses réponses. En outre, il s’adapte mieux géographiquement, prenant en compte que la requête vient de France. Certes, pour avoir accès à Bing AI, il faut télécharger le navigateur Microsoft Edge, mais vous aurez l’assurance d’avoir la version la plus puissante de l’IA d’OpenAI et il n’y a pas d’embouteillage. Du côté de ChatGPT, à moins d’opter pour la version payante pour avoir accès à GPT-4, vous serez sur la version précédente et devrez régulièrement patienter en raison de surcharges des serveurs. Mais les deux se complètent assez bien et il est intéressant de comparer les réponses de ces deux IA.

Reste Bard, dont les résultats sont pour le moins mitigés pour le moment. L’intelligence artificielle donne régulièrement des réponses clairement erronées ou peut induire en erreur. Mais c’est aussi pour cela que l’outil est en beta test : chaque requête soumise entraîne aussi Bard et l’aide à s’améliorer.