Le HDR est une fonctionnalité mise en avant par tous les constructeurs de TV, qui s’appuient sur cet acronyme pour ajouter un argument de vente à bon nombre de termes techniques qu’il est bien souvent difficile de comprendre. Mais cette technologie est-elle vraiment utile ? (Spoiler : oui !). Décryptage.

Ici toutefois, le High Dynamic Range n’est pas tout à fait nouveau, puisqu’il est employé dans l’univers de la photographie. Il désigne alors la combinaison logicielle de plusieurs clichés à l’exposition différente afin d’obtenir des résultats à la fois plus lumineux et plus contrastés, sans zones bouchées ni surexposées. Dans l’univers de la télévision, le HDR, même si son résultat est similaire, s’appuie sur des principes techniques bien différents.

Ce dossier a été mis à jour en septembre 2022.

Le HDR sur les TV, avant tout une histoire de luminosité

Par opposition au SDR (Standard Dynamic Range), c’est-à-dire le type d’images auquel vous avez affaire depuis les débuts de la télévision, le HDR (High Dynamic Range) propose d’étendre la plage dynamique de l’image. Tout est une histoire de luminosité, ou plutôt de luminance, laquelle s’exprime en nits ou en candelas par mètre carré (cd/m²).

Les téléviseurs HDR sont ainsi capables d’offrir une plage de luminosité plus étendue que leurs homologues SDR, et de monter bien plus haut dans la luminance et de descendre très bas dans le noir. Et comme chacun y va de ses recommandations, le plus simple est encore de s’en remettre aux recommandations de l’UHD Alliance pour y voir plus clair.

Cette coalition de studios de cinéma, de chaînes de TV, de constructeurs de téléviseurs et autres fournisseurs de contenu recommande ainsi un pic de luminosité d’au moins 1000 nits et un niveau de noir à moins de 0,05 nit, ou d’au moins 540 nits, avec un niveau de noir à moins de 0,0005. De quoi espérer que les scènes les plus éclairées soient particulièrement lumineuses, que les zones sombres ne soient pas délavées, et qu’entre les deux, les détails de l’image ne se perdent pas dans des zones bouchées et/ou surexposées. Car c’est bien l’idée derrière le HDR : il est conçu pour laisser voir les détails de l’image quelle qu’en soit l’exposition, et pour offrir une image la plus proche possible de ce que voit l’œil humain dans la réalité.

Une bonne gestion des différents spectres colorimétriques est également garante d’un HDR de qualité.

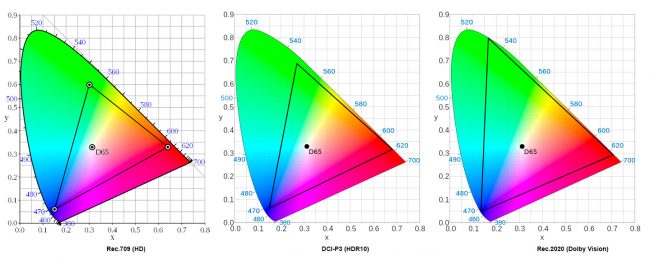

La luminosité est certes le nerf du HDR, mais ce n’est pas le seul élément à prendre en compte. Elle doit également être associée aux bonnes couleurs. C’est là qu’intervient la deuxième recommandation de l’UHD Alliance : non seulement les appareils doivent disposer d’une entrée compatible avec l’espace colorimétrique Rec.2020 (ou BT2020), mais aussi de l’affichage d’au moins 90 % de l’espace colorimétrique DCI-P3.

Comprenez que les téléviseurs doivent être capables d’afficher l’intégralité des couleurs situées à l’intérieur d’un triangle (gamut) plus étendu de 25 % que le traditionnel sRGB, notamment dans les rouges et les verts. Les constructeurs peuvent évidemment aller plus loin et afficher davantage de couleurs, mais ils doivent conserver l’équilibre entre chaque teinte pour éviter les dérives, ce qui n’est pas toujours une mince affaire. Il faut également noter que la norme P3 est utilisée pour la projection cinématographique.

Quelles sont les conditions pour regarder des vidéos en HDR ?

Pour profiter de contenus en HDR, il est nécessaire que tous les éléments de la chaîne allant de la production à la diffusion soient compatibles. C’est-à-dire que les images doivent être tournées avec des caméras proposant une grande dynamique, soit par assemblage de deux images à des expositions différentes, soit avec un mode HDR.

Le signal vidéo incluant des métadonnées correspondant au format HDR retenu – nous les détaillerons plus bas –, il faut une connexion Internet adaptée à ce flux plus “gros” dans le cadre d’une diffusion en streaming. Netflix recommande ainsi “une vitesse de connexion Internet stable d’au moins 25 mégabits par seconde”.

Mieux vaut donc être équipé de la fibre optique. Ce n’est pas tout : si vous utilisez une box Internet ou un boîtier TV, lui aussi doit être compatible, de même que votre téléviseur, en bout de chaîne.

On citera par exemple, parmi les boîtiers adaptés au HDR, les Shield de Nvidia, dont la dernière mouture date de 2019 (Dolby Vision et HDR10), mais aussi le boîtier Chromecast avec Google TV, que nous avons essayé pour vous (HDR10, HDR10+, Dolby Vision). Il est à noter que Netflix et Amazon Prime Video ne sont plus les seuls à fournir des contenus en HDR : comme eux, le plus récent Disney+ est compatible avec les normes HDR10 et Dolby Vision, qu’il a tardé à fournir à son lancement français, pour mieux épargner la bande passante hexagonale durant le premier confinement. Apple TV+ est, lui aussi, compatible HDR et Dolby Vision.

Deuxième et indispensable élément de la chaîne, le téléviseur doit bien sûr être compatible avec le HDR. Pour reconnaître les écrans adaptés, il faut s’en remettre aux logos qui accompagnent les écrans. Mais attention, les recommandations de l’UHD Alliance, qui se traduisent par un petit pictogramme sur les cartons des TV, datent de 2016, soit une éternité dans l’univers des téléviseurs. Et elles ne sont que facultatives. C’est donc là que les choses se corsent pour le consommateur final qui, face à des TV qui sont, en 2021, tous ou presque annoncés compatibles HDR, ne sont pas capables des mêmes performances finales. Leur luminosité maximale peut varier du simple au double, et cette donnée est rarement accessible en un coup d’œil sur les fiches techniques.

Vous l’aurez compris, la mention HDR ne signifie que peu de choses en soi, si ce n’est que l’écran de TV ou le moniteur d’ordinateur est capable de recevoir et de déchiffrer les données HDR qui leur sont envoyées, mais sans garantie de leur capacité à afficher pleinement ces contenus.

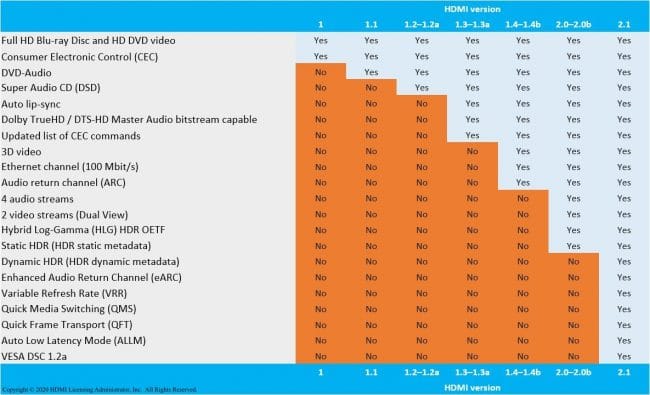

Ajoutons tout de même que la connectique du téléviseur et de sa source vidéo doit être adaptée. Il leur faut donc un port HDMI 2.0a, cette norme étant nécessaire à la gestion de l’espace colorimétrique étendu inhérent au HDR. La question se pose d’autant qu’une console PlayStation 4, censée être compatible avec le HDR grâce à une mise à jour, était initialement équipée d’un port HDMI 1.4. La question ne se pose plus aujourd’hui avec l’arrivée des consoles dites next-gen, les PlayStation 5 et Xbox Series X, toutes pourvues d’une connectique HDMI 2.1. Celle-ci, nous y reviendrons plus bas, est capable de prendre en charge un HDR dynamique.

Le HDR côté jeux vidéo

Diverses certifications sont disponibles, et pas seulement pour les TV. Car si le HDR intéresse les amateurs de films et de séries, il concerne également les joueurs : en 2019, on parlait d’une centaine de jeux HDR sur le marché, pour des résultats finaux très hétérogènes. Ce qui a d’ailleurs poussé les consoliers et éditeurs de jeux à fonder le HDR Gaming Interest Group (HGIG) en 2018 pour mieux établir un ensemble de bonnes pratiques, sans certification à la clé, disponibles auprès des acteurs de l’univers vidéoludique. Depuis, nouvelle génération de consoles oblige, le HDR s’est généralisé dans les jeux vidéo avec l’arrivée des PS5 et Xbox Series.

Quant au DisplayHDR par Vesa, il s’agit d’une certification tout aussi facultative que celle de l’UHD Alliance, mais soutenue par les fabricants de moniteurs (BenQ, AOP…). Sa dernière version, baptisée Display HDR CTS v1.1, date de septembre 2019 et la certification est entrée en vigueur en juin 2020. Celle-ci permet de visualiser, en un logo donc, la performance assurée par le moniteur. DisplayHDR 400, 500, 600, 1400, 400 TrueBlack et 500 TrueBlack permettent de connaître le niveau minimum de luminosité à en attendre (400, 500, 600, 1400 cd/m2 ou nits) et, pour les deux dernières versions, garantissent un niveau de lumière particulièrement bas à l’affichage des noirs (0.0005 cd/m2 au centre des écrans). L’intégralité des spécifications que recouvrent les certifications Vesa DisplayHDR v1.1 est consultable à cette adresse.

Le point sur les normes HDR

Il existe actuellement plusieurs normes HDR qui cohabitent dans le plus grand flou aux yeux des néophytes. Certains fabricants promettent le support d’une, deux voire de davantage de normes, et des TV s’offrent même des mentions bonus, tel ce LG OLED65BX6LB, testé il y a quelques temps au sein de notre Labo, et qui cumule le support des HDR10, Dolby Vision IQ et HLG, certifications auxquelles il ajoute l’estampille HGIG.

Quoi qu’il en soit, le match se joue aujourd’hui encore essentiellement entre le HDR 10, une norme ouverte, et le Dolby Vision, dont la certification est payante. S’il y a quelques années, des marques telles que Panasonic nous avaient confié ne pas avoir opté pour cette norme en raison de son coût, mais aussi parce que les contenus Dolby étaient encore trop peu nombreux, la donne a aujourd’hui changé. Samsung s’y refuse toujours, mais les marques concurrentes (LG, Sony, Panasonic, Philips, TCL…), les contenus compatibles s’étant largement développés, n’ont pas hésité.

HDR10

Le HDR10 est soutenu par l’Ultra HD Alliance, qui délivre sa marque commerciale Ultra HD Premium, dont le logo est apposé aux cartons d’emballage des TV, lorsque le HDR10 est assuré. Il n’est pas toujours indiqué comme tel sur les emballages de téléviseurs, et parfois résumé à un simple HDR.

Ce standard, défini par la Consumer Electronics Association, impose notamment la compatibilité avec l’espace colorimétrique Rec.2020, un encodage en 10 bits par couleur primaire (1024 nuances), avec un sous-échantillonnage de la chrominance réalisé en YCbCr 4:2:0.

L’intégralité des spécifications techniques du HDR10 est disponible à cette adresse. S’il faut retenir un point, c’est bien qu’avec le HDR10, toutes les métadonnées, c’est-à-dire les détails de la vidéo permettant d’obtenir un rendu HDR, sont envoyées en une fois, au début du flux vidéo.

HDR10+

Trois ans après le HDR10, l’association regroupant la 20th Century Fox, Panasonic et Samsung lançait son évolution, le HDR10+. Depuis 2018 donc, la norme reprend bien sûr les bases du HDR10, enrichies justement au niveau des métadonnées évoquées plus haut.

Si celles qui accompagnent les vidéos en HDR10 sont dites statiques, c’est-à-dire paramétrées une fois pour toutes en fonction du type de vidéo à l’écran (en s’appuyant sur la scène la plus lumineuse du contenu), le HDR10+ est flanqué de métadonnées dynamiques. La courbe de correspondance de tonalité est réévaluée à chaque scène, pour un rendu bien plus précis.

HDR10+ Adaptative

Vous vous en doutiez, trois années plus tard, une évolution était à attendre. L’association en charge du HDR10+ n’a pas fait défaut début 2021, annonçant le HDR10+ Adaptative. Plus que jamais soutenue par Samsung, la norme est avant tout une réponse à celle de Dolby, Dolby Vision IQ sur laquelle nous reviendrons plus bas.

Disponible sur les TV de Samsung annoncés début 2021, le HDR10+ Adaptative reprend les bases du HDR10+, à savoir ses métadonnées dynamiques, auxquelles s’ajoutent des “informations en temps réel sur la luminosité ambiante”. L’idée est donc ici que la luminosité de l’image soit optimisée non seulement scène par scène, mais aussi en fonction des conditions de visionnage.

Samsung, ambassadeur désigné de la technologie, indique que le FilmMaker Mode, c’est-à-dire le mode “réalisateur” permettant aux créateurs de contenu de s’assurer que le mode de visionnage de leurs vidéos respectera leurs choix esthétiques, sera compatible avec le HDR10+ Adaptative.

Dolby Vision

Contrairement au HDR10, le HDR Dolby Vision propose un encodage en 12 bits, ce qui permet d’obtenir 4096 nuances par couleur. Le Dolby Vision va donc plus loin que le HDR10, en proposant également des métadonnées associées à chaque image, ce qui assure la restitution fidèle des vidéos, conformément à ce qu’a voulu montrer le réalisateur.

Côté pic de luminosité, le Dolby Vision peut monter jusqu’à une luminance de 4000 nits, et entrevoit jusqu’à 10 000 nits dans le futur… même si en réalité, certains téléviseurs certifiés Dolby Vision n’excèdent pas les 1000 nits et affichent du 10 bits. Le standard, plus exigeant dans la mesure où il doit être respecté de la production à la diffusion des images, mais aussi plus précis que le HDR10, souffre néanmoins d’un défaut : il est plus onéreux, Dolby commercialisant sa licence. Il était moins répandu il y a quelques années, mais, soutenu notamment par les plateformes de streaming vidéo, il est désormais largement répandu. On trouve des TV compatibles chez Sony, LG, TCL ou encore Panasonic… mais pas chez Samsung.

Dolby Vision IQ

Si le HDR10+ Adaptative date du CES 2021, c’est lors de la précédente édition du salon américain que le Dolby Vision IQ a été officialisé. En partenariat avec LG et Panasonic, qui intègrent donc la technologie à certaines de leurs gammes de téléviseurs, il “utilise les métadonnées dynamiques du Dolby Vision et les capteurs de luminosité situés à l’intérieur des TV pour détecter le niveau de luminosité de la pièce, affichant intelligemment chaque détail du contenu pour qu’il s’affiche au mieux”. Là aussi, il s’agit donc, pour les constructeurs adoptant la technologie, d’adapter leurs TV au niveau matériel.

HLG

Le HLG, pour Hybrid Log Gamma, est un standard nettement moins répandu. Développé par la BBC et par le diffuseur japonais NHK, il vise à simplifier la diffusion de contenus HDR en direct, ce que la transmission de métadonnées imposées par le HDR10 et le Dolby Vision compliquent.

L’encodage est lui aussi réalisé en 10 bits, mais la technologie employée par le Britannique et son homologue nippon ne s’appuie pas sur un système de métadonnées, et assure de ce fait une compatibilité avec les écrans SDR, comme il l’explique ici. Les premiers appareils compatibles avec le HLG ont été annoncés fin 2016 et début 2017, notamment chez LG et Sony, tandis que le support de ce standard a été ajouté à la norme HDMI 2.0b. Le nombre de modèles compatibles n’a cessé de croître depuis lors.

Découvrez nos promotions pour Black Friday 2022 !

À lire aussi

Quels sont les contenus HDR disponibles ?

Investir dans du matériel compatible avec (les) HDR, c’est une chose, mais encore faut-il avoir des contenus à visionner. Parmi eux bien sûr, des Blu-ray Ultra HD, eux-mêmes compatibles HDR (avec cette même certification délivrée par l’Ultra HD Alliance). Ils sont donc intrinsèquement liés à la 4K.

Difficile d’obtenir des statistiques précises, mais on note par exemple que, d’après les déclarations publiées début janvier par l’association en charge du HDR10+, il existe “un certain nombre de Blu-ray disponibles qui utilisent la technologie HDR10+, dont le détenteur de l’Oscar du Meilleur Film Parasite, qui est distribué par Universal Pictures Home Entertainment”. Elle ajoute d’ailleurs que “la distribution de contenus dans le monde s’est élargie”, évoquant le cas de chaînes de TV en Allemagne ou en Corée du Sud.

La plupart des constructeurs de téléviseurs mettent en avant les services de streaming vidéo à la demande que sont Amazon Prime Video et Netflix, et pour cause : les deux concurrents proposent une offre de contenus compatibles HDR. Côté standards pris en compte, l’idéal est encore de disposer d’un appareil compatible HDR10 ou Dolby Vision, puisque tous deux s’appuient sur ces normes.

Ajoutons que Google, partenaire de Samsung pour l’occasion, propose via son service Play Films, des films HDR10+.

Terminons ce tour d’horizon malheureusement encore rapide par l’univers du jeu vidéo, où le HDR est également à l’honneur. Il l’est d’autant plus que les dernières générations de consoles, à savoir les PlayStation 5 et Xbox Series X, disposent de la connectique HDMI 2.1 désormais incontournable dans le monde du gaming. Celle-ci, comme nous le rappelions dans notre dossier consacré à la connectique, prend en charge les métadonnées dynamiques du HDR10+ et du Dolby Vision.

Pour les joueurs ayant réussi à investir à la sortie des consoles, des titres tels que Demon’s Souls, Call Of Duty: Black Ops Cold War ou encore Spider-Man: Miles Morales sont donc encodés en HDR.

Ajoutons tout de même que les propriétaires de consoles de générations précédentes ne sont pas laissés pour compte. À ce titre, la PlayStation 4 Pro est elle aussi compatible avec le HDR10, de même que la PS4 standard, via une mise à jour 4.0 de leur système, déployée en 2016. Il faut néanmoins rappeler que, bien souvent, les téléviseurs ne proposant des contenus HDR que s’ils sont également affichés en 4K, il ne sera pas possible d’en profiter pleinement avec la PS4, cantonnée à la Full HD.

HDR et smartphones : où en est-on ?

La notion de HDR était initialement l’apanage de la télévision. Mais depuis l’automne 2016, le HDR apparaît sur les écrans de smartphones très haut de gamme ainsi que de tablettes.

Aujourd’hui, il ne s’agit plus simplement d’une caractéristique réservée à quelques terminaux très haut de gamme : si bien des smartphones prenaient en charge le HDR côté décodage, mais n’en profitaient pas pleinement en raison des limitations de leur écran, la donne a changé. On voit désormais fleurir la mention HDR, mais aussi les certifications HDR10 appliquées aux écrans de smartphones ou même HDR10+.

Sans surprise, la toute récente série Galaxy S22 de Samsung en est affublée. Dès l’an dernier, le groupement HDR10+ annonçait que “en plus de Samsung Mobile, les constructeurs de smartphones OnePlus, Oppo, Realme et Xiaomi ont aussi annoncé le support du HDR10+ sur leurs terminaux mobiles”.

Vous l’aurez compris, c’est tout de même du côté des smartphones orientés milieu/haut de gamme qu’il faut se tourner. Vous vous en douterez, le marché des tablettes tactiles évolue de la même manière que celui des smartphones.

Il est d’ailleurs intéressant de constater que l’UHD Alliance, qui permet aux fabricants intéressés d’apposer son logo Ultra HD Premium (avec les exigences minimales HDR qui lui incombent) sur leurs téléviseurs, propose son pendant mobile depuis 2017 : le logo Mobile HDR Premium. Celui-ci requiert que les smartphones et tablettes soient capables d’afficher de 0,0005 à 540 nits. Il s’applique également aux ordinateurs portables, auxquels ils demandent d’afficher de 0,1 à 600 nits. La certification impose également ses exigences en termes de résolution, de profondeur de couleurs (au moins 10 bits) et d’espace colorimétrique (représentation d’au moins 90 % de l’espace P3).