Intel Labs a collaboré avec un autre labo pour développer un nouveau modèle d’IA générative. Une IA capable de générer des images en 3D, avec de la profondeur, plutôt que simplement en 2D, en se basant sur du texte.

Un nouveau modèle que l’entreprise qualifie de révolutionnaire grâce à son potentiel d’utilisation dans de nombreux domaines. Cette IA, baptisée LDM3D (pour Latent Diffusion Model for 3D) ne se contente pas simplement d’imprimer une image avec de la profondeur. Celle-ci est visible à 360 degrés.

Faire avancer la génération en 3D

Si de nombreuses IA génératives à la mode aujourd’hui sont capables de générer aisément des images en 2D à partir d’une commande textuelle, Intel Labs, qui a travaillé sur le projet en collaboration avec Blockade Labs, a constaté que très peu pouvait générer des images en 3D. Le labo veut aller encore plus loin en permettant de générer à la fois une image mais aussi une carte de profondeur, autorisant alors des vues à 360 degrés. Une bonne nouvelle pour les chercheurs, une moins bonne pour les artistes.

L’objectif ici, selon les mots du communiqué de presse, est d’améliorer grandement le réalisme et l’immersion afin de permettre des applications innovantes. Si la technologie vient à se perfectionner, il sera alors possible de l’utiliser dans des secteurs comme le métavers, la réalité virtuelle, les jeux vidéo mais aussi la décoration d’intérieur, les annonces immobilières, ou bien encore les musées virtuels.

Une application pour essayer le modèle

C’est bien beau tout ça pour qui s’intéresse à l’IA générative mais concrètement, sur quoi repose LDM3D ? Le modèle a été entrainé sur un ensemble de données construit par un sous-ensemble de 10 000 échantillons de la base de données LAION-400M, une grande base de données comprenant 400 millions de paires d’images et de légendes. Intel y a ajouté son précédent modèle Dense Prediction Transformer, qui fournit des profondeurs relatives très précises pour chaque pixel.

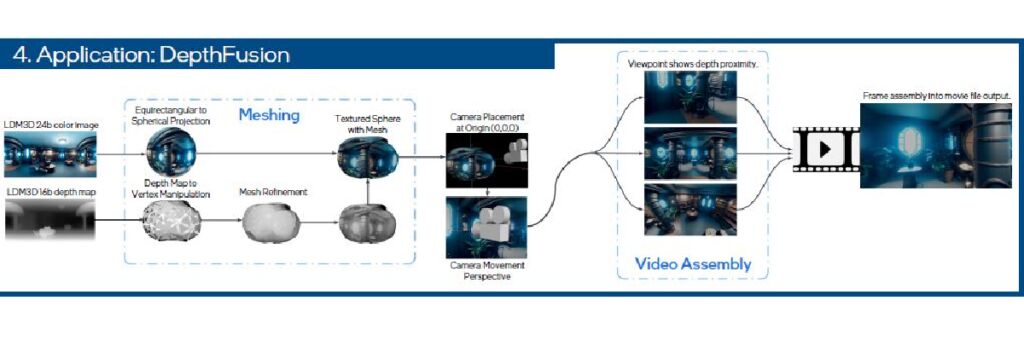

Le modèle est alors capable de générer des images en 2D RGB d’un côté et un champ de profondeur de l’autre. Il va ensuite intégrer le premier dans le second pour générer un panorama à 360 degrés tout en économisant la mémoire utilisée. Pour montrer en action l’efficacité de leur modèle, Intel Labs et Blokade Labs ont développé et mis à disposition une application appelée DepthFusion. Intel Labs annonce enfin avoir mis son modèle LMD3D en open source via HuggingFace afin que les chercheurs et praticiens de l’IA puissent s’approprier l’outil et l’améliorer dans des applications personnalisées.