Utilisée par les médias depuis plusieurs années, l’intelligence artificielle leur est utile à bien des égards. Mais, au fur et à mesure que cette technologie progresse, elle représente aussi une menace pour eux.

Alors que l’intelligence artificielle (IA) menace des millions d’emplois, la question se pose de savoir si cette technologie peut remplacer les journalistes. D’autant plus depuis le lancement de ChatGPT, qui est notamment capable de générer des articles complets. C’est dans ce contexte que plusieurs médias ont commencé à utiliser l’IA générative pour produire des contenus.

Si cela peut surprendre, en réalité, les médias se servent de l’IA depuis de nombreuses années. L’utilisation de ces technologies leur est bénéfique, mais elle peut aussi leur poser problème. Explications.

Une technologie utile au sein des rédactions

Tout le monde ne le sait pas, mais certains médias publient des contenus générés par l’IA depuis plusieurs années. C’est notamment le cas de l’agence Associated Press, pionnière dans ce domaine. Elle a commencé à tirer parti de cette technologie en 2014, publiant des dépêches générées par des machines à propos des résultats d’entreprise, puis des résultats sportifs. « Avant d’utiliser l’IA, nos rédacteurs et journalistes consacraient d’innombrables ressources à une couverture importante, mais répétitive et, plus important encore, détournée du journalisme à plus fort impact », explique l’agence sur son site.

Comme d’autres médias, Associated Press se sert également de l’IA pour la retranscription des interviews, une tâche chronophage qui peut être confiée à des machines plus rapides que les humains, mais aussi capables de traiter des textes en plusieurs langues. Cette technologie permet en effet d’automatiser certaines tâches, notamment dans le domaine de la production journalistique.

L’IA est surtout utilisée par les médias pour recommander des articles. Comme les suggestions que l’on peut voir sur les réseaux sociaux ou sur les plateformes comme Netflix, un algorithme propose des articles susceptibles d’intéresser le lecteur en fonction de ses habitudes de lecture. Selon une étude du Reuters Institute for the Study of Journalism, 67% l’utilisent dans une certaine mesure pour les recommandations. C’est par exemple le cas de Flint, une « newsletter intelligente, créée sur mesure grâce à un savant mélange d’intelligence artificielle et collective ». Elle propose d’aider les internautes à trouver les meilleures informations pour eux, notamment à l’aide d’« algorithmes analysant le comportement d’un panel de 22 000 experts sur plusieurs millions de contenus d’information ».

Proposer de nouveaux contenus

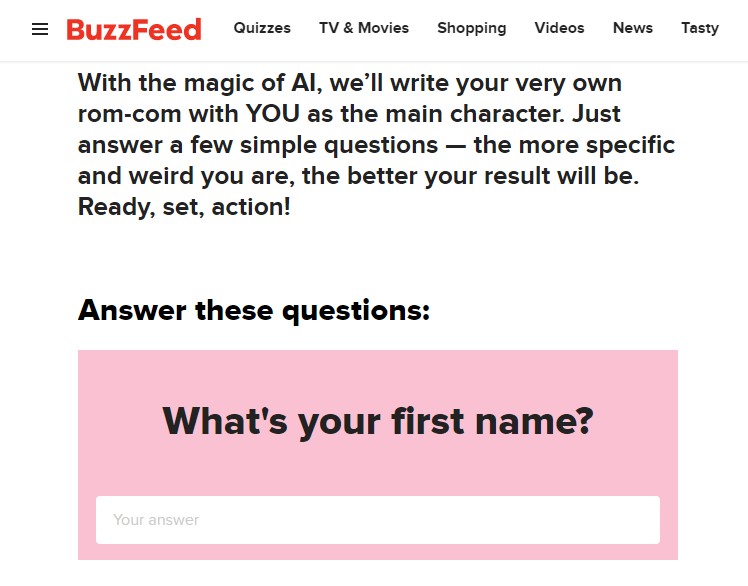

Outre la recommandation de contenus, l’IA permet aussi aux médias d’offrir de nouveaux types de contenus aux lecteurs. Depuis quelque temps, certains en France, à l’instar du Monde ou du Figaro, proposent par exemple d’écouter les articles au lieu de les lire : c’est bien une intelligence artiicielle qui transforme le texte écrit en production orale. L’IA générative leur permet d’aller plus loin dans leur offre de contenus. Après avoir annoncé qu’il allait travailler avec OpenAI – startup à l’origine de ChatGPT – pour produire des quiz et personnaliser des contenus, BuzzFeed a dévoilé son tout premier format de quiz alimenté par l’IA. Six de ses « Infinity Quiz » ont été lancés pour aider les internautes à « créer [leur] propre comédie romantique » ou encore « générer un texte de rupture ». Le site vient aussi de publier 40 articles de voyage écrits avec l’aide de l’IA.

D’autres médias préfèrent cependant jouer la carte de la prudence avec l’IA générative. Wired vient par exemple de publier une charte sur l’utilisation de cette technologie par sa rédaction. « Nous voulons être à l’avant-garde des nouvelles technologies, mais aussi être éthiques et prudents », indique le site. Parmi les règles de cette charte, il précise qu’il ne publiera pas d’articles avec du texte généré ou modifié par l’IA, mais qu’il pourrait l’utiliser pour la génération d’idées d’articles ou la suggestion de titres pour de courtes publications sur les réseaux sociaux.

La menace des faux contenus

Ce n’est pas pour rien, toutefois, que les médias se méfient dans le même temps de l’IA générative. Bien que cette technologie leur soit utile, elle peut aussi être problématique. Fin 2022, le site CNET a par exemple publié des articles générés par une IA, mais a été contraint de suspendre ce test, notamment à cause d’erreurs factuelles trouvées dans plusieurs d’entre eux. Si les systèmes comme ChatGPT sont doués pour produire des contenus, ces derniers peuvent parfois contenir de fausses informations. À titre d’illustration, une étude a récemment révélé que GPT-4, le dernier modèle de langage alimentant le chatbot d’OpenAI en diffusait encore plus que son prédécesseur.

À cela s’ajoute la menace des deepfakes, ces vidéos produites à l’aide de l’IA pour falsifier les propos d’une personne ou donner l’impression qu’elle fait quelque chose alors que ce n’est pas le cas. Selon un rapport du laboratoire d’innovation d’Europol publié l’année dernière, les progrès de cette technologie et la disponibilité publique des banques de grandes bases de données d’images et de vidéos contribueront à augmenter le volume et la qualité des deepfakes. Cela, alors que 90% du contenu en ligne pourrait être généré artificiellement d’ici à 2026, ouvrant la voie à une désinformation croissante. Il sera ainsi plus difficile de distinguer le vrai du faux avec ces contenus. On le voit déjà avec des outils comme Midjourney, qui a récemment été utilisé pour générer des images du pape François en doudoune blanche, que plusieurs internautes ont cru réelles.

Certains médias cherchent ainsi à détecter ces vidéos truquées proliférant déjà sur les réseaux sociaux. Le Wall Street Journal a par exemple créé une équipe dédiée à cela, qui forme les journalistes à identifier ces contenus. Pour ce faire, le quotidien américain se sert de divers outils, comme TinEye, qui permet de faire des recherches inversées pour trouver d’anciennes versions de la vidéo.