À l’aide d’une application, des utilisateurs américains vont pouvoir parler avec son système d’intelligence artificielle appelé LaMDA à travers une série de démos expérimentales.

En juin, Google a suspendu Blake Lemoine, un de ses ingénieurs qui avait affirmé que son système d’intelligence artificielle (IA) LaMDA était une personne douée de sensibilité pour ensuite le licencier. Développé pour créer des chatbots basés sur les modèles de langage les plus avancés, ce système va pouvoir être testé par le public. Le 25 août, la firme de Mountain View a annoncé l’ouverture des inscriptions sur une liste d’attente pour l’application AI Test Kitchen. Présentée lors de la conférence annuelle, Google I/O, en mai dernier, elle « offre une nouvelle façon pour les individus d’apprendre, d’expérimenter et de donner leur avis sur la technologie d’IA émergente, comme LaMDA ».

Le géant américain a commencé à la déployer progressivement auprès de petits groupes d’utilisateurs aux États-Unis : lancée sur Android le 25 août, elle le sera sur iOS dans les semaines à venir. Elle inclut une série de démos explorant les capacités de la dernière version de LaMDA.

Des tests pour améliorer LaMDA

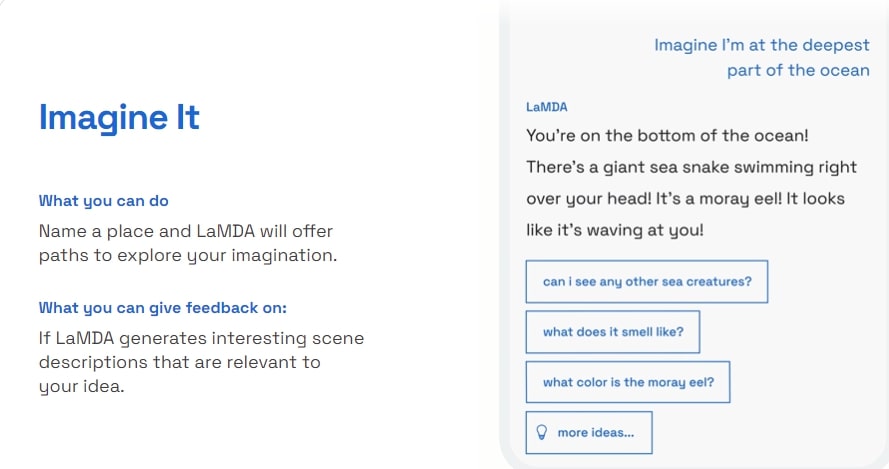

Trois démos sont proposées dans AI Test Kitchen. La première appelée « Imagine It » permet de nommer un lieu et propose des pistes pour explorer son imagination. Avec la seconde, « List It », les utilisateurs peuvent partager un objectif ou un sujet qui sera ensuite décomposé en « une liste de sous-tâches utiles » par LaMDA. Enfin, la démo « Talk About It (Dogs Edition) », qui offre la possibilité d’avoir une conservation sur les chiens, a pour but d’explorer la capacité du système d’IA à rester sur le sujet, même lorsque l’utilisateur essaie de s’en écarter.

Avec ses démos, Google entend permettre au public de voir la capacité de LaMDA à « générer des réponses créatives à la volée ». D’un autre côté, l’entreprise américaine reconnaît que cette aptitude peut poser problème à cause de réponses pouvant être inexactes ou inappropriées. Assurant l’avoir amélioré grâce à des tests menés en interne au cours de l’année, elle explique en avoir réalisé d’autres plus récemment afin de trouver des failles supplémentaires dans le modèle d’IA. Des experts ont ainsi découvert des résultats nuisibles comme le fait que LaMDA puisse « produire des réponses nocives ou toxiques basées sur des biais dans ses données de formation, générant des réponses qui stéréotypent et représentent faussement des personnes en fonction de leur sexe ou de leur origine culturelle ».

Google assure avoir ajouté des couches de protection à son application pour répondre à ces problèmes, permettant de minimiser les risques. La société a conçu ses systèmes pour détecter et filtrer automatiquement les mots ou expressions enfreignant ses politiques. Ils interdisent aux utilisateurs de générer sciemment des contenus sexuellement explicites, haineux ou encore illégaux. Après avoir amélioré LaMDA en interne, Google espère en faire de même avec les commentaires du public. « Lorsque vous évaluez chaque réponse LaMDA comme étant agréable, offensante, hors sujet ou fausse, nous utilisons ces données – qui ne sont pas liées à votre compte Google – pour améliorer et développer nos futurs produits », a indiqué la firme.