L’IA est devenue incontournable dans nos appareils numériques, et elle n’a pas fini de transformer notre quotidien. Mais à quel moment l’intelligence artificielle est passée de la fiction à la réalité ? Comment ce rêve d’une machine douée d’intelligence est-il devenu un ensemble d’applications très concrètes ? Retour sur la folle histoire de l’IA.

Automates et raisonnement formel

L’IA a toujours existé dans les fantasmes de l’Humanité. Bien avant l’émergence de l’informatique au XXe siècle, l’idée d’une intelligence qui n’est pas d’origine humaine a fait son chemin dans l’esprit des hommes. La mythologie grecque y fait référence à travers Talos, le gardien de l’île de Crète décrit comme un automate géant fait de bronze. Au XIIe siècle, l’inventeur arabe Ismail Al-Jazari s’est fait une spécialité de la création d’automates programmables, les ancêtres de la robotique.

Au fil des siècles, les philosophes ont phosphoré autour du raisonnement formel, d’Aristote en Grèce à Guillaume d’Ockham en Angleterre en passant par Al-Khwârizmîn en Perse – père de l’algèbre qui a donné le mot « algorithme ». Leur point commun : tenter de formaliser la pensée humaine, la systématiser de manière mécanique pour pouvoir la reproduire. C’est notamment la direction qu’a prise Thomas Hobbes au XVIIe siècle en estimant que « penser, c’est calculer ».

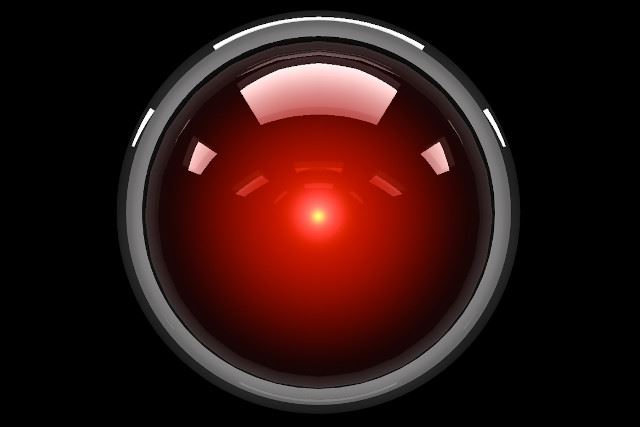

La science-fiction a pris le relais au XIXe siècle, interrogeant notamment la capacité des machines à développer une conscience, notamment Frankenstein de Mary Shelley en 1818. Certains imaginent même la révolte des robots, comme William Grove dans The Wreck of the World en 1889. Des thèmes que l’on retrouvera au siècle suivant dans des œuvres tels que le film 2001, L’Odyssée de l’espace de Stanley Kubrick en 1968 ou Terminator de James Cameron en 1984.

Le célèbre HAL 9000, le supercalculateur doté d’intelligence artificielle du chef d’oeuvre 2001, l’Odyssée de l’espace de Kubrick.

Les prémices de l’informatique

L’intelligence artificielle telle que nous la concevons aujourd’hui est intimement liée à l’apparition de l’ordinateur au XXe siècle. Mais dès le XIXe siècle, l’Analytical Engine du Britannique Charles Babbage préfigurait l’informatique, alors à base de cartes perforées pour donner des instructions à cette machine à calculer. Ada Lovelace développera même pour l’occasion le premier algorithme – faisant d’elle la première programmeuse de l’histoire. Sa conception était toutefois encore éloignée de l’intelligence artificielle : « La machine analytique n’a nullement la prétention de créer quelque chose par elle-même. Elle peut exécuter tout ce que nous saurons lui ordonner d’exécuter. »

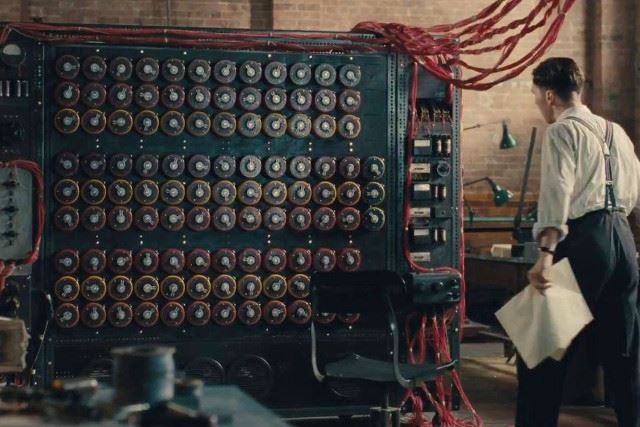

Dans la première moitié du XXe siècle, l’informatique fait une première percée lors de la Seconde Guerre mondiale sous l’impulsion du Britannique Alan Turing. Ce mathématicien créera en effet la « Bombe », une machine électromécanique de cryptanalyse permettant d’automatiser le décryptage des transmissions allemandes. Elle aurait contribué à réduire le conflit de deux ans d’après un consensus historique, en permettant d’abattre chaque jour le travail de 10 000 personnes. Une histoire passionnante racontée dans le film Imitation Game, qu’on vous recommande.

À lire aussi

Et John McCarthy créa l’IA !

Il faut attendre 1949 pour voir apparaître le terme d’intelligence artificielle. On le doit à John McCarthy, l’un des pionniers de l’IA. Il est alors étudiant en mathématiques à Princeton, et tente à son tour de traduire le raisonnement humain en programme informatique. Il définit l’IA comme « toute tâche exécutée par un programme ou une machine qui, si un humain effectuait la même activité, devrait appliquer l’intelligence pour accomplir la tâche ». Il résume le concept comme « la science et l’ingénierie de la fabrication de machines intelligentes ».

L’intelligence artificielle devient une discipline académique à l’été 1956 lors de la conférence de Dartmouth. John McCarty est entouré d’une vingtaine de chercheurs et impose la notion d’IA, tandis qu’Allen Newell, Herbert Simon et Cliff Shaw dévoilent leur programme Logic Theorist capable de reproduire le raisonnement humain lors de la résolution d’un problème. La machine est lancée !

Les premières applications concrètes de l’intelligence artificielle

Logic Theorist – que l’on peut traduire par « Théoricien logique » – est donc la première IA fonctionnelle connue. Développé à partir de 1955, ce programme informatique fut le premier à utiliser des méthodes de raisonnement formel grâce à des algorithmes de recherche et de déduction capables d’effectuer des tâches intellectuelles. Ce raisonnement par tâtonnements permet de prouver des théorèmes mathématiques, de jouer aux échecs – en s’appuyant sur les travaux de Claude Shannon – ou encore aux dames – un programme signé Arthur Samuel capable d’apprendre et de s’adapter.

Peu avant, Alan Turing a également ouvert la voie à l’IA via son « imitation game » qui deviendra « le test de Turing ». En 1950, celui qui travaille alors au développement de l’informatique s’intéresse en parallèle à l’intelligence artificielle et propose une expérience basée sur des questions-réponses dans lequel une machine tente de convaincre l’évaluateur que c’est un humain. C’est notamment la grande force d’ELIZA, premier agent conversationnel créé en 1966… qui en fait ne délivrait que des réponses « bateau » en reformulant la question.

Des promesses et des revers

Les balbutiements de l’IA entre les années 1950 et 1960 ont fait naitre de grandes attentes et soulevés d’importants financements auprès des universités (Stanford, Harvard, MIT, Edimbourg, etc.). Mais les résultats ne sont pas à la hauteur des espoirs suscités lorsqu’un Herbert Simon déclarait en 1965 que « des machines seront capables, d’ici vingt ans, de faire tout travail que l’homme peut faire ». Le rythme des avancées ralentit, les prédictions les plus optimistes se heurtent aux limites techniques de l’informatique, les critiques fusent et les financements vont s’estomper. On entre dans « l’hiver de l’IA ».

Il faut attendre le boom des systèmes experts dans les années 1980 pour relancer l’intérêt autour de l’intelligence artificielle. Elle sort des laboratoires de recherche pour être adoptée par les entreprises afin de se substituer aux hommes dans la réalisation de tâches spécifiques. Il s’agit de programmes informatiques imitant l’expertise humaine dans un domaine précis, en se basant sur des règles établies par des professionnels. Le raisonnement déductif est à l’œuvre et l’ambition se limite à effectuer un diagnostic médical pour les professionnels de santé ou encore prédire le risque de défaillance pour les assureurs. Malgré les progrès dans des domaines tel que les réseaux neuronaux, une nouvelle hibernation attend le domaine au tournant des années 1980/1990, période de démocratisation de l’ordinateur personnel qui relègue la recherche scientifique au second plan.

L’IA entre dans notre quotidien

L’avancée technologique va néanmoins permettre aux ingénieurs de relancer l’IA. Ils s’appuient pour cela sur le machine learning, la capacité de la machine à accumuler des connaissances et s’en nourrir pour adapter en continu et améliorer ses performances de manière autonome. Grâce à cette approche innovante, de nouveaux résultats spectaculaires en matière de reconnaissance vocale, de robotique remettent l’intelligence artificielle sur le devant de la scène.

Le fait majeur de ce renouveau intervient en 1997 lorsque l’ordinateur d’IBM Deep Blue domine le champion du monde des échecs Garry Kasparov. La puissance des ordinateurs – qui augmente selon le principe de la loi de Moore avec un doublement des capacités tous les deux ans – et le développement d’internet, avec ses données à profusion – le Big Data – permettent aux machines d’accomplir des progrès phénoménaux.

Le champion d’échecs Garry Kasparov affronte l’ordinateur d’IBM Deep Blue en 1997.

Du machine learning, on accède au deep learning dans les années 2010, en reprenant le concept des réseaux de neurones pour apprendre à la manière d’un cerveau humain. Avec des algorithmes d’apprentissage perfectionnés et une puissance de calcul démultipliée, la machine progresse par elle-même et devient capable de générer des contenus (du texte avec ChatGPT, des images avec MidJourney) et se met à la portée de tous.

Apple Siri, Amazon Alexa, Google Now : les assistants personnels intelligents interagissent avec les utilisateurs de smartphones et d’enceintes connectées. L’IA est parmi nous, bouleverse nos usages et réinvente notre rapport à la technologie.