À l’occasion de sa Google I/O, le groupe américain a levé le voile sur de multiples avancées en matière d’intelligence artificielle distillées au sein de ses applications phares.

Lors de sa grand-messe qui s’est tenue les 11 et 12 mai dernier, la firme de Mountain View a présenté ses Pixel 6a et Pixel Buds Pro. Le géant a également profité de l’évènement pour lever un peu le voile sur sa future Pixel Watch, ses Pixel 7, sa Pixel Tab, ainsi qu’un prototype de lunettes de réalité augmentée qui permet de converser plus facilement avec ses pairs.

Initialement dédiée aux développeurs, la Google I/O a été l’occasion pour le groupe de Sundar Pichai d’exposer toute une série de nouvelles fonctionnalités, qui seront bientôt disponibles au sein de ses services. Le mastodonte a insisté sur certaines avancées en matière d’intelligence artificielle (IA), dont la traduction. Ses outils ont en effet significativement évolué au cours de ces dernières années, avec l’intégration de la traduction automatique et en temps réel des contenus YouTube, la retranscription des dialogues et surtout la prise en charge d’un nombre toujours plus conséquent de langues dans la solution Google Traduction. L’optimisation de l’intelligence artificielle au coeur des fonctionnalités de travail collaboratif, de l’assistant vocal ou encore de la recherche en ligne étaient également au coeur de la conférence annuelle.

Un résumé automatique propulsé dans Google Docs et Google Chat

Les emails et conversations instantanées font partie intégrante du quotidien des professionnels. Entre les réunions et les tâches qui se multiplient dans l’agenda, il peut parfois être difficile de trouver le temps (et le courage !) pour se plonger dans un long rapport ou un compte rendu de réunion. Google Docs devrait prochainement aider les utilisateurs à gagner un temps précieux, tout en leur permettant de ne pas perdre de vue les informations essentielles. Avec l’appui de l’intelligence artificielle, Google Docs proposera en effet bientôt un résumé automatique. Une manière de parcourir rapidement les grandes thématiques abordées dans un document, avant de le parcourir plus dans le détail ultérieurement. De quoi limiter les risques de pertes de données, un enjeu majeur aujourd’hui pour bon nombre d’entreprises.

Cette fonctionnalité sera également disponible dans les applications Google Chat et Spaces. Une manière rapide et efficace de découvrir les idées phares qui ont été échangées, sans avoir à relire des dizaines voire des centaines de lignes de discussions.

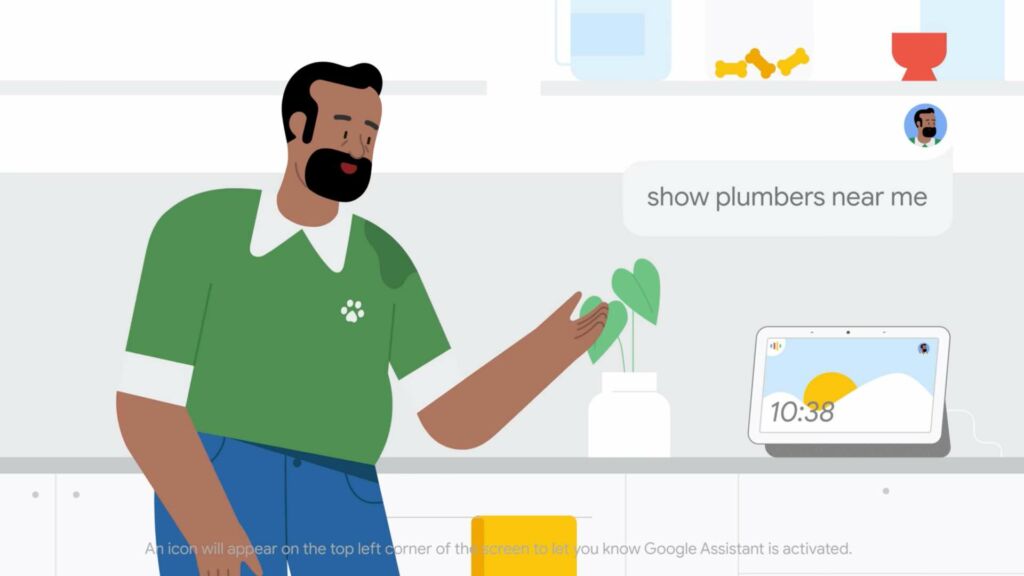

Converser plus naturellement avec Google Assistant

Les assistants vocaux s’invitent partout. Ils permettent de contrôler les smartphones, mais aussi un grand nombre d’objets connectés de la maison. À la longue, il peut être usant d’avoir à systématiquement verbaliser « Ok Google » pour introduire une nouvelle requête. Aussi, pour fluidifier les interactions avec l’assistant vocal, et gommer un peu plus encore l’interface homme-machine, Google annonce la fonction « Look and talk » pour son enceinte intelligente Nest Hub Max.

Grâce à cette nouvelle fonctionnalité, il suffit de simplement regarder l’enceinte puis d’énoncer sa demande (« quelle est la météo du jour »). Pour ce faire, la caméra et le micro de l’appareil lancent une reconnaissance faciale et/ou vocale pour s’assurer qu’il s’agisse bien d’un utilisateur autorisé. Les capteurs analysent ensuite une centaine de paramètres comme l’inclinaison de la tête et le mouvement des lèvres pour détecter si la personne souhaite bien lancer une commande vocale.

En complément, toujours en vue de proposer une alternative à l’accroche « Ok Google », mais aussi pour permettre à la machine de mieux appréhender les subtilités du langage humain, l’assistant vocal des Pixel 6 et Nest Hub Max intègrera l’option « Quick talk ». Comme le précise l’éditeur américain, il s’agit de phrases courtes pré-programmées correspondant aux demandes les plus courantes telles que « allume les lumières du couloir » ou « règle une minuterie sur 10 minutes ».

Au départ, seuls les États-Unis pourront profiter de ces avancées. Le groupe n’a encore pas communiqué de date de déploiement à l’international.

L’avenir de la recherche visuelle se précise

En marge de ces deux nouvelles fonctionnalités pratiques au quotidien, l’IA viendra au renfort de la recherche visuelle, à travers Lens. Il sera possible de trouver un restaurant à proximité sur la base d’un plat photographié, ou encore un magasin proposant un article spécifique. Il suffira d’ajouter « près de chez moi », pour que la fonctionnalité trouve la pièce disponible en stock autour de soi, où encore le restaurant le plus proche où déguster le plat.

Enfin, Google devient plus inclusif et prend en charge dans son moteur de recherches une plus grande palette de teintes de peau, de couleur et de texture de cheveux. Les requêtes sont ainsi affinées et chaque spécificité mieux référencée pour des résultats plus pertinents.