L’outil n’est pas entièrement fiable mais la société l’a rendu accessible au public pour obtenir des retours.

Depuis son lancement, ChatGPT impressionne autant qu’il inquiète. Capable de générer divers contenus textuels, ce chatbot peut aussi être utilisé à des fins malveillantes (désinformation, tricherie…). Consciente de ces risques, OpenAI – entreprise à l’origine du célèbre robot conversationnel – vient de lancer un outil capable de détecter si un texte a été écrit par une intelligence artificielle (IA) ou un humain.

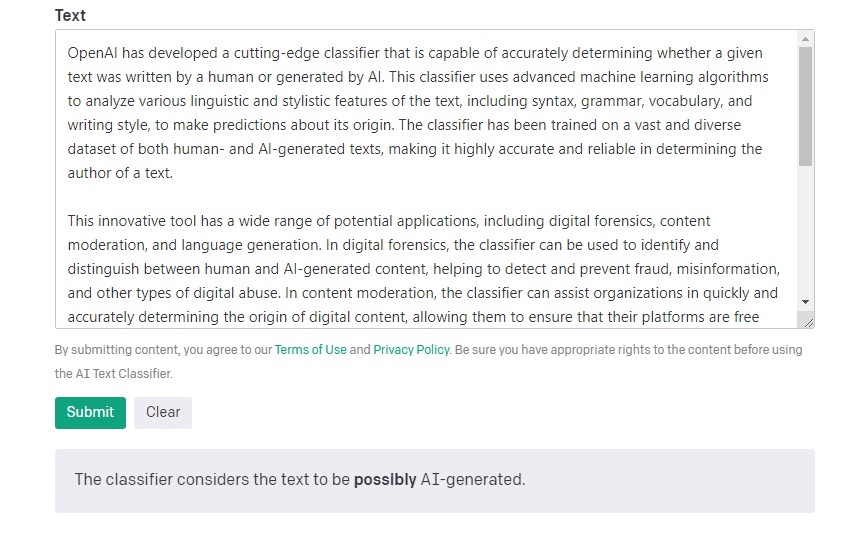

Il s’agit d’un classificateur qui a été entraîné avec « des paires de textes écrits par des humains et de textes écrits par l’IA sur le même sujet », indique la société dans un communiqué. Pour l’utiliser, il suffit de coller le contenu textuel que l’on souhaite analyser dans un champ dédié. À noter qu’il est nécessaire d’avoir un compte gratuit sur le site d’OpenAI pour s’en servir.

Un outil à améliorer

Bien qu’il soit accessible au public, l’outil de la société est loin d’être parfait. « Notre classificateur n’est pas entièrement fiable. Lors de nos évaluations sur un ensemble de textes en anglais, il a correctement identifié 26% des textes rédigés par l’IA comme étant “probablement écrits par l’IA”, tout en étiquetant incorrectement des textes rédigés par des humains comme étant écrits par l’IA dans 9% des cas. La fiabilité de notre classificateur s’améliore généralement à mesure que la longueur du texte d’entrée augmente », explique OpenAI.

Dans le cadre d’un test, L’Eclaireur a demandé à ChatGPT d’écrire un texte à propos de ce nouvel outil. Après l’avoir collé dans le champ dédié du classificateur, ce dernier a indiqué que « le texte était peut-être généré par l’IA ».

Avec ce lancement public, l’entreprise souhaite « obtenir des retours sur l’utilité d’outils imparfaits comme celui-ci ». Le classificateur dispose par ailleurs d’autres limitations. Il est « très peu fiable » sur des textes courts (moins de 1 000 caractères) et il vaut mieux l’utiliser avec des textes en anglais car il fonctionne « nettement moins bien » avec d’autres langues. OpenAI reconnaît aussi que son outil peut être dupé par des modifications apportées à un texte écrit par une IA. « Notre travail sur la détection de texte généré par l’IA se poursuivra et nous espérons, plus tard, partager des méthodes améliorées », fait savoir la société.

Outre ce classificateur, d’autres outils ont récemment été lancés pour détecter les textes rédigés par une IA. Des chercheurs de l’université de Stanford viennent de dévoiler DetectGPT, affirmant que cet outil est fiable à 95% après l’avoir testé sur un ensemble de faux articles écrits par ChatGPT. De même, la startup franco-canadienne Draft and Goal a lancé en janvier un détecteur pour aider les professeurs à savoir si leurs élèves ont rédigé leurs devoirs tout seuls ou s’ils se sont servis du chatbot d’OpenAI.