Pour célébrer les 70 ans de la Fnac, nous vous invitons à un petit voyage à travers l’histoire de l’enseigne et de ses différentes spécificités. L’occasion de revenir sur les grandes évolutions technologiques de ces 7 décennies, pour les principales catégories vendues dans nos magasins. Dans cet article, place à la révolution informatique !

Depuis l’invention des premiers calculateurs électroniques dans les années 1940 jusqu’à l’intégration de l’intelligence artificielle dans nos ordinateurs d’aujourd’hui, l’informatique a connu une évolution fulgurante qui a profondément transformé notre société. Nous vous proposons de découvrir ensemble les grandes étapes qui ont marqué son histoire.

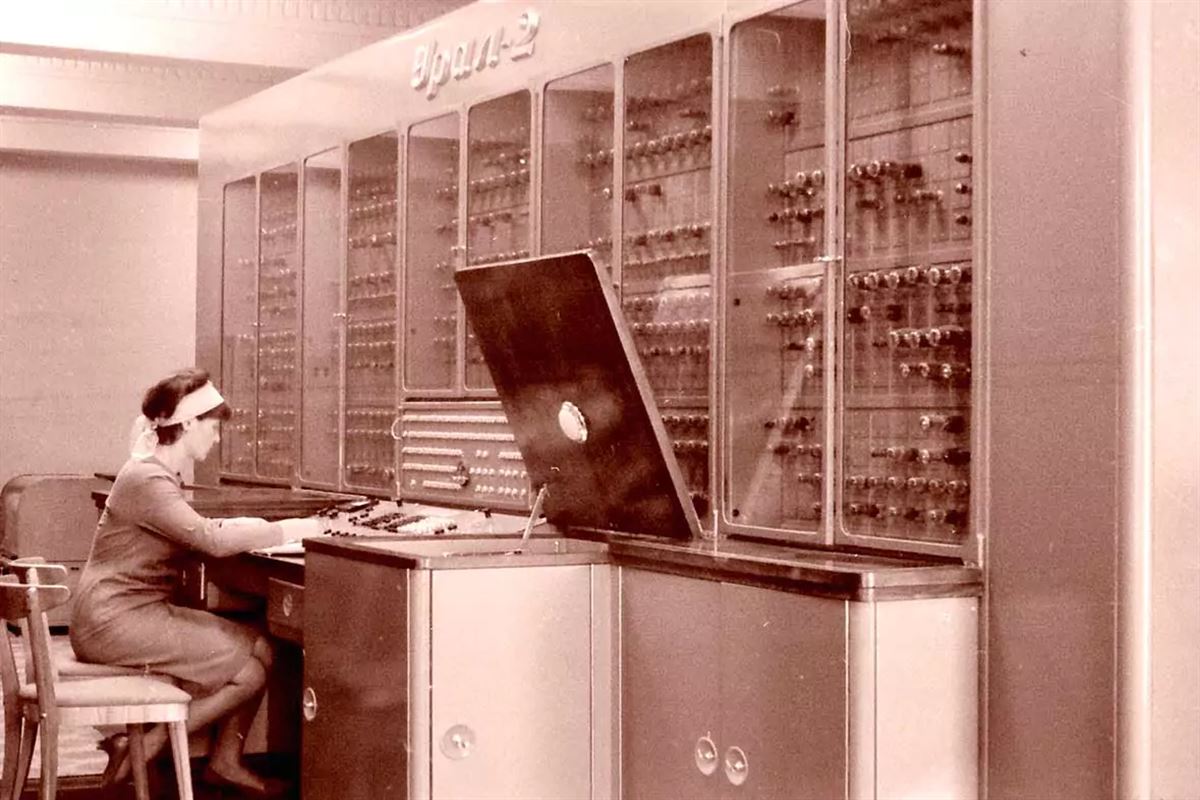

Et si l’Homme n’avait jamais inventé l’informatique ? Posez-vous donc la question et essayez d’imaginer à quoi ressemblerait notre monde. L’informatique, c’est-à-dire la science du traitement automatique de l’information, a transfiguré notre façon de travailler, de communiquer et de nous divertir en à peine 80 ans. Des premiers calculateurs électroniques comme l’ENIAC (Electronic Numerical Integrator and Computer) en 1945, capables d’effectuer 5000 additions par seconde, aux ordinateurs équipés d’intelligence artificielle générative d’aujourd’hui, l’informatique a connu un développement spectaculaire qui a totalement façonné le monde moderne.

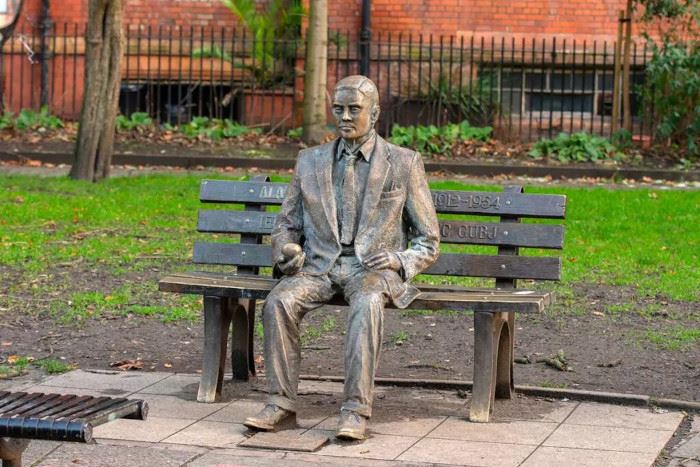

Son histoire trouve ses racines dans les travaux pionniers de Charles Babbage sur la machine analytique au XIXe siècle, puis dans les théories fondatrices d’Alan Turing et John von Neumann dans les années 1930-1940. Mais c’est véritablement avec l’invention du transistor en 1947 et l’avènement des circuits intégrés dans les années 1960 que l’informatique prend son envol, ouvrant grand la porte de la miniaturisation des composants et à l’augmentation exponentielle de la puissance de calcul.

À Manchester (Royaume-Uni), le Mémorial et la statue d’Alan Turing, dans les jardins de Sackville. ©Dutchmen Photography

La naissance de l’ordinateur personnel (1970-1980)

Les années 1970 vont marquer l’histoire de l’informatique avec l’émergence des premiers ordinateurs personnels. En 1973, le Micral, créé par la société française R2E, devient le premier ordinateur commercial à intégrer le premier microprocesseur, l’Intel 8008. Commandé par l’INRA, il dispose de 2 Ko de RAM.

Mais c’est assurément avec l’Altair 8800 en 1975 que le marché des ordinateurs personnels prend son envol. Vendu en kit à assembler soi-même, l’Altair 8800 séduit de nombreux passionnés, dont deux jeunes programmeurs nommés Bill Gates et Paul Allen, qui fondent Microsoft pour développer un interpréteur BASIC pour cette machine. Lors de la première réunion de l’équipe de Microsoft en 1975, Bill Gates aurait déclaré : « Un jour, il y aura un ordinateur sur chaque bureau et dans chaque foyer ». Une vision qui semblait alors totalement folle, mais qui s’est réalisée au-delà de toutes les espérances.

À Mountain View en Californie, le Musée d’histoire de l’ordinateur abrite l’une des plus grandes collections d’objets informatiques au monde. Ici, l’Altair 8800. ©Around the World Photos

En 1977, trois machines symbolisent la démocratisation de l’informatique personnelle : l’Apple II, le Commodore PET et le TRS-80. Parmi elles, l’Apple II, conçu par Steve Wozniak et Steve Jobs dans leur garage, devient le premier ordinateur personnel à connaître un véritable succès commercial. Avec son microprocesseur 8 bits, ses 4 Ko de RAM et son lecteur de cassettes intégré, il séduit par sa facilité d’utilisation et sa capacité à afficher des graphismes en couleur.

Le légendaire Apple II. ©Grand Warszawski

En 1980, le Commodore VIC-20 devient le premier ordinateur à dépasser le million d’unités vendues. Grâce à son prix abordable et sa connectivité à la télévision, il contribue à populariser l’informatique auprès du grand public. La même année, Hewlett-Packard lance le HP-85, premier modèle de sa série d’ordinateurs de bureau HP 80, destiné aux professionnels et aux scientifiques.

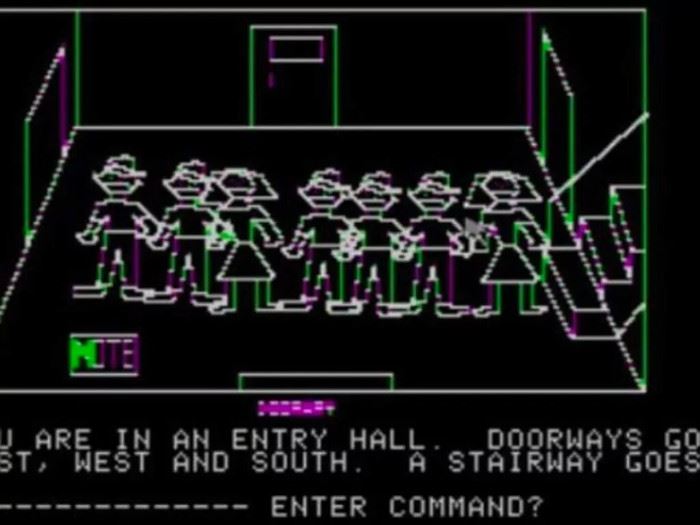

Cette décennie foisonnante voit également l’essor des langages de programmation comme le Pascal, le C et le BASIC, ainsi que l’apparition des premiers jeux vidéo sur ordinateur, comme Mystery House (1980) de Roberta et Ken Williams, qui pose les bases du jeu d’aventure graphique.

Mystery House est le premier jeu d’aventure avec une interface graphique.

L’âge d’or des ordinateurs personnels (1980-1990)

Les années 1980 marquent l’âge d’or des ordinateurs personnels, avec l’émergence de machines emblématiques qui vont poser les jalons de ce que sera l’informatique pour les décennies suivantes. En 1981, IBM lance son PC (Personal Computer), un modèle qui va rapidement s’imposer comme un standard de l’industrie. Basé sur une architecture ouverte et un microprocesseur Intel 8088, il est livré avec le système d’exploitation MS-DOS de Microsoft et devient la référence des “compatibles PC”. Pourtant, le projet était considéré comme trop risqué par la direction d’IBM, mais Bill Lowe, directeur de la division Entry Level Systems, a réussi à les convaincre en promettant de le développer en un temps record de 12 mois.

Le premier IBM PC. ©Tada Images

Face à lui, Apple lance en 1984 le Macintosh, premier ordinateur grand public à populariser l’interface graphique et la souris. Malgré des débuts difficiles, le Mac va trouver son public dans les professions créatives et l’éducation, grâce à son design iconique et sa facilité d’utilisation. Même le lancement de la machine est devenu légendaire. Steve Jobs, vêtu d’un costume-cravate, avait en effet sorti le Mac d’un sac, inséré une disquette et laissé l’ordinateur se présenter lui-même d’une voix synthétique, provoquant l’enthousiasme de la salle.

Mais la décennie est aussi marquée par une guerre des standards entre de nombreux acteurs. Le MSX, standard japonais soutenu par Microsoft, rencontre un certain succès en Europe et surtout en Asie. L’Amiga de Commodore et l’Atari ST se livrent une bataille féroce sur le marché des ordinateurs multimédias, notamment dans le domaine des jeux vidéo et de la musique assistée par ordinateur.

Le Commodore 64. ©Federico Magonio

Dans les années 80, les innovations s’enchaînent à un rythme effréné. Ainsi, le Commodore 64, sorti en 1982, devient l’ordinateur le plus vendu grâce à son prix abordable et ses capacités graphiques et sonores. La technologie CD-ROM, présentée en 1984, sera capitale dans l’explosion de l’utilisation multimédia de l’informatique. Tandis que les ordinateurs portables comme le Macintosh Portable (1989) et le Compaq LTE (1989) inaugurent l’ère de la mobilité.

L’ère d’Internet et de la mobilité (1990-2010)

Les années 1990 et 2000 vont connaître deux révolutions concomitantes qui vont bouleverser à la fois le monde et l’informatique : l’essor d’Internet et l’avènement de la mobilité. En 1990, Tim Berners-Lee, chercheur au CERN, invente le World Wide Web sur une station de travail NeXT. Trente-quatre ans plus tard, nous pouvons mesurer à quel point cette innovation a révolutionné le numérique et a eu un impact considérable à l’échelle mondiale.

Tim-Berners-Lee, surnommé « l’inventeur d’Internet », même s’il n’était évidemment pas seul. ©drserg

Le Web se démocratise rapidement grâce à l’apparition de navigateurs graphiques comme Mosaic (1993) et Netscape Navigator (1994). Les entreprises commencent à créer leurs sites web et le commerce électronique émerge avec des pionniers comme Amazon (1994) et eBay (1995). L’ouverture d’Internet au grand public en 1992 et son expansion rapide dans les années suivantes vont transformer en profondeur l’économie et la société.

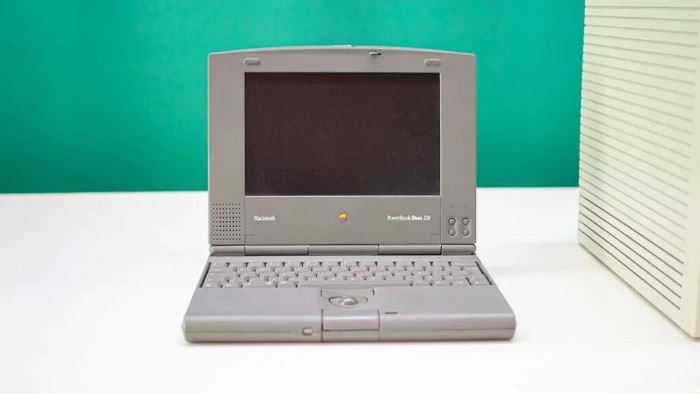

Parallèlement, les ordinateurs portables gagnent en puissance et en popularité. Apple lance le PowerBook en 1991, qui introduit le trackball et le clavier ergonomique. IBM riposte avec la gamme ThinkPad en 1992, qui deviendra une référence sur le marché professionnel. Les premiers ordinateurs portables à écran couleur apparaissent, comme le Compaq Concerto en 1993, qui préfigure le concept d’ordinateur 2-en-1 avec son écran détachable.

L’Apple PowerBook. ©Roman Belogorodov

Au fil de la décennie, les portables intègrent de nouvelles fonctionnalités comme le lecteur CD-ROM (IBM ThinkPad 775CD en 1994), le processeur Pentium (Gateway Solo 2100 en 1996) ou encore la webcam intégrée (IBM RS/6000 860 en 1996). Les ultra-portables comme le Sony VAIO 505, sorti en 1997 avec un poids record de 1,3 kg, séduisent un public avide de mobilité.

Dans les années 2000, Apple renouvelle le marché avec l’iMac G3 au design translucide et coloré (1998), suivi par les iBook (1999) et les MacBook (2006) qui démocratisent l’usage nomade du Mac. Les PC portables comme les très abordables Netbooks (Asus Eee PC en 2008) et les ordinateurs convertibles tactiles (HP TouchSmart tx2z en 2008) rencontrent aussi un vif succès.

Enfin, en 1997, Deep Blue, le supercalculateur d’IBM, bat pour la première fois Garry Kasparov, le champion du monde d’échecs.

Vers une informatique omniprésente et intelligente (depuis 2010)

Depuis 2010, l’informatique est entrée dans une nouvelle ère, celle de l’omniprésence et de l’intelligence artificielle. Les ordinateurs sont devenus plus abordables, plus portables et plus connectés que jamais, s’intégrant de manière transparente dans notre quotidien.

L’essor des netbooks et des ordinateurs à bas coût, comme l’Asus Eee PC en 2008 évoqué plus haut, a démocratisé l’accès à l’informatique. Parallèlement, l’explosion des tablettes tactiles et des ordinateurs hybrides, à l’image de la Microsoft Surface Pro, a brouillé les frontières entre ordinateurs portables et mobiles, offrant une polyvalence inédite.

Le cloud computing a également connu une croissance constante, permettant d’accéder à ses données et à ses applications depuis n’importe quel appareil connecté. Les Chromebooks de Google, lancés en 2011 et fonctionnant sous Chrome OS, illustrent parfaitement cette tendance en proposant une expérience centrée sur le navigateur et le cloud.

Un Chromebook signé Acer.

Mais la véritable révolution de cette période est toute récente, et même encore balbutiante, puisqu’il s’agit de l’intégration de l’intelligence artificielle dans nos ordinateurs. Les assistants vocaux comme Siri (2011) ou Alexa (2014) ont ouvert la voie, permettant d’interagir avec nos appareils de manière naturelle et intuitive. Les algorithmes d’apprentissage automatique se sont perfectionnés au fil du temps, offrant aux ordinateurs la possibilité de reconnaître des images, de comprendre le langage naturel et même de générer du contenu.

Nous n’en sommes encore qu’au tout début de cette tendance de l’IA, mais elle ne fait que s’accélérer, comme en témoigne l’intégration de l’IA dans la suite Microsoft 365 avec Copilot en 2023. Les perspectives sont vertigineuses : des ordinateurs capables de coder, de créer, d’analyser et de prendre des décisions de manière autonome, devenant de véritables partenaires intelligents dans notre vie quotidienne et professionnelle. Rien que ça.

Le PC Surface PRO 11 de Microsoft embarque son IA Copilot. ©Labo Fnac

Bien sûr, cette évolution ne manque pas de soulever des questions éthiques et sociétales majeures. Comment garantir la confidentialité de nos données personnelles ? Comment éviter les biais et les dérives des algorithmes ? Comment préparer la société à une transformation aussi profonde de la nature même du travail et de la création ? Autant de points qui n’ont pas encore été résolus, mais qui suscitent bien des débats, aussi bien du côté des utilisateurs que dans les milieux politiques.

Un futur pas si proche

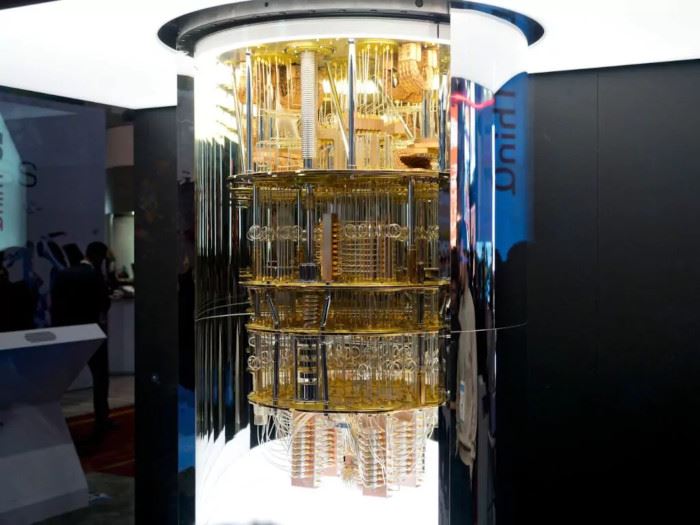

Une chose est néanmoins sûre : l’informatique du futur sera (encore plus) omniprésente, intelligente et profondément intégrée dans nos vies. Au terme de ce voyage dans l’histoire de l’informatique, une chose est frappante : la vitesse et l’ampleur des transformations qu’elle a engendrées en à peine 80 ans. Des premiers calculateurs électroniques aux ordinateurs quantiques, en passant par la naissance de l’ordinateur personnel, l’avènement d’Internet et l’essor de l’intelligence artificielle, l’informatique a révolutionné notre façon de travailler, de communiquer, de créer et de penser. Nous nous sommes penchés ici principalement sur le versant grand public de l’histoire de l’informatique. Mais les technologies évoquées tout au long de cet article ont également eu des impacts incommensurables dans le monde de l’industrie.

Aujourd’hui, l’informatique est devenue ubiquitaire et invisible, s’intégrant dans nos objets du quotidien, nos véhicules, nos villes et bientôt même nos corps. Elle est aussi devenue plus intelligente, capable d’apprendre, de s’adapter et d’interagir avec nous de manière naturelle. Les progrès de l’intelligence artificielle laissent entrevoir un futur où les machines seront capables de résoudre des problèmes complexes et sans doute même de créer et d’innover de manière autonome.

L’ordinateur quantique IBM Q System One au CES de Las Vegas en 2020. ©Boykov/Shutterstock

Les promesses de l’intelligence artificielle générale, capable d’égaler et de dépasser l’intelligence humaine dans tous les domaines, et de l’informatique quantique, qui repousse les limites de la puissance de calcul, ouvrent des perspectives proprement vertigineuses. Mais ne retenez pas votre souffle, au-delà des effets d’annonces, il faudra encore de nombreuses années avant que l’informatique quantique ou l’intelligence artificielle générale deviennent réalité.

D’ici là, l’aventure de l’informatique “classique” est loin d’être terminée et va continuer à être riche en rebondissements. Nous sommes d’ailleurs en ce moment même en train de vivre une petite révolution avec la montée en puissance des processeurs ARM pour ordinateur, au détriment de l’architecture x86 historique. Comme le disait le père de l’informatique Alan Turing : « Nous ne pouvons voir qu’un peu du futur, mais suffisamment pour réaliser qu’il y a beaucoup à faire. »