iOS 18 ne sera présenté que le mois prochain, mais Apple prend un peu d’avance et nous dévoile quelques fonctionnalités liées à l’accessibilité.

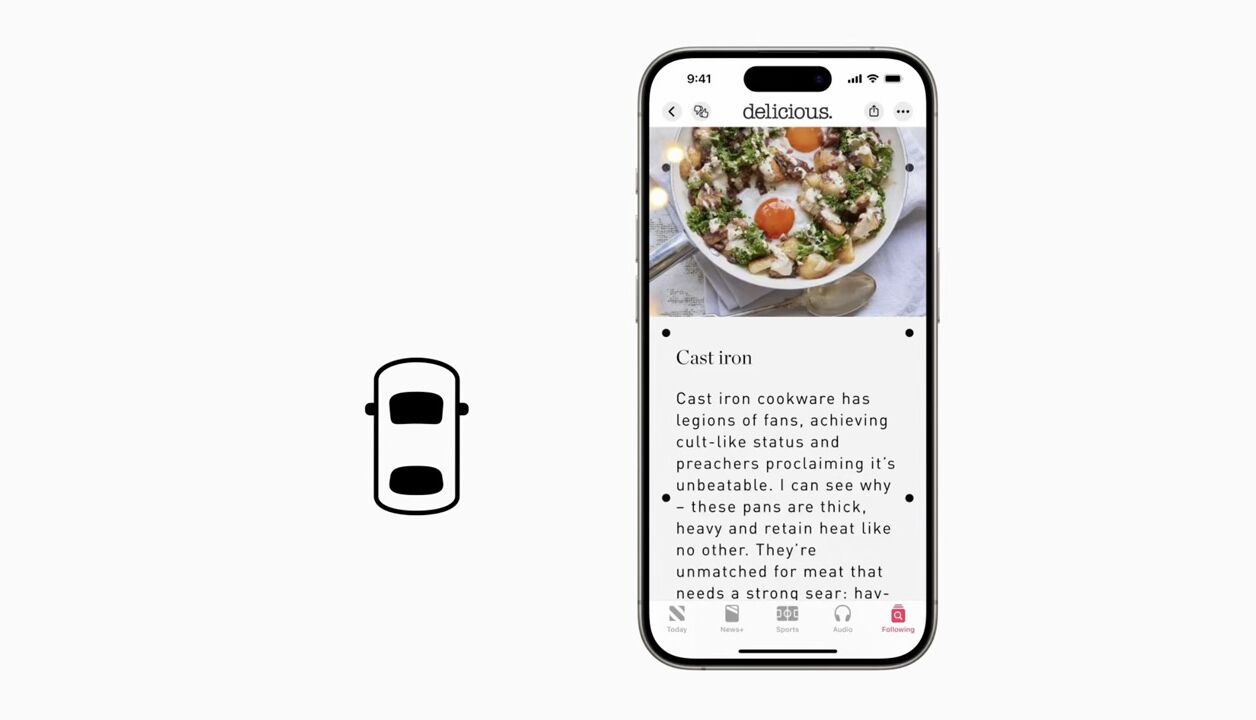

Certains sont épargnés et peuvent scroller sur leur smartphone, qu’importe la longueur du trajet. D’autres doivent à tout prix fixer un point à l’horizon et attendre que leur cinétose – leur mal des transports – passe. Mais si ce n’était pas une fatalité ? Apple présente Vehicle Motion Cues, une fonction d’accessibilité qui sera intégrée à la prochaine version d’iOS et qui pourrait aider à réduire le mal des transports.

Une fonction destinée à réduire les “conflits sensoriels”

Nausées, vomissements, maux de tête… Les troubles causés par le mal des transports sont tout sauf agréables. En revanche, les raisons qui les provoquent sont plutôt bien documentées et Apple est bien décidé à tenter de les neutraliser. D’après la recherche, explique la firme sur son blog, le mal des transports est la plupart du temps causé par un « conflit sensoriel ». C’est-à-dire un manque d’anticipation du cerveau par rapport à la trajectoire empruntée par le véhicule dans lequel l’usager se trouve.

Grâce à l’accéléromètre et au gyroscope des iPhone, Vehicle Motion Cues veut aider notre cerveau à mieux envisager les virages et les changements de cap. En activant l’option, six points noirs apparaîtront de part et d’autre de l’écran (comme sur l’image d’illustration de cet article). Des points qui vont se déplacer sur l’écran en fonction des mouvements détectés par l’iPhone, et qui vont donc renseigner notre cerveau sur la direction du véhicule sans avoir besoin de jeter un œil par la fenêtre.

L’efficacité de cette mesure face à des formes particulièrement sévères de cinétose reste à prouver. Mais c’est déjà un premier pas qu’on est curieux de mettre à l’épreuve. Cette fonction pourra être activée et désactivée facilement depuis le Centre de Contrôle des iPhone lorsqu’elle sera disponible plus tard cette année.

D’autres fonctions d’accessibilité innovantes

Les annonces d’Apple ne s’arrêtent pas là. La firme a également présenté une nouvelle façon d’interagir avec ses appareils, notamment pour les personnes en situation de handicap physique. Grâce aux caméras dédiées à Face ID et à l’intelligence artificielle, on pourra interagir avec l’iPhone et l’iPad grâce à son regard. Une technologie de tracking oculaire permettra de mettre en surbrillance les éléments de l’écran et de soutenir le regard pour les ouvrir.

Autre nouveauté intéressante : Music Haptics. Pour permettre aux personnes malentendantes de mieux ressentir la musique qu’elles écoutent, cette fonction va faire vibrer l’iPhone de concert avec le morceau en cours de lecture. Une fonction évidemment intégrée à Apple Music, mais pas seulement. Il s’agira d’une API disponible aux développeurs, qui seront libres de l’adapter pour leur propre application.

Enfin, la fonction Vocal Shortcuts permettra de définir des raccourcis vocaux pour que Siri exécute des tâches plus complexes sans trop d’effort. L’avantage de cette fonction est qu’elle s’accompagne d’une meilleure détection des différentes manières de s’exprimer (tels que des accents peu communs ou la voix de personnes ayant des difficultés à parler).

Un bel éventail de nouveautés qui seront probablement intégrées à iOS 18, en septembre prochain.