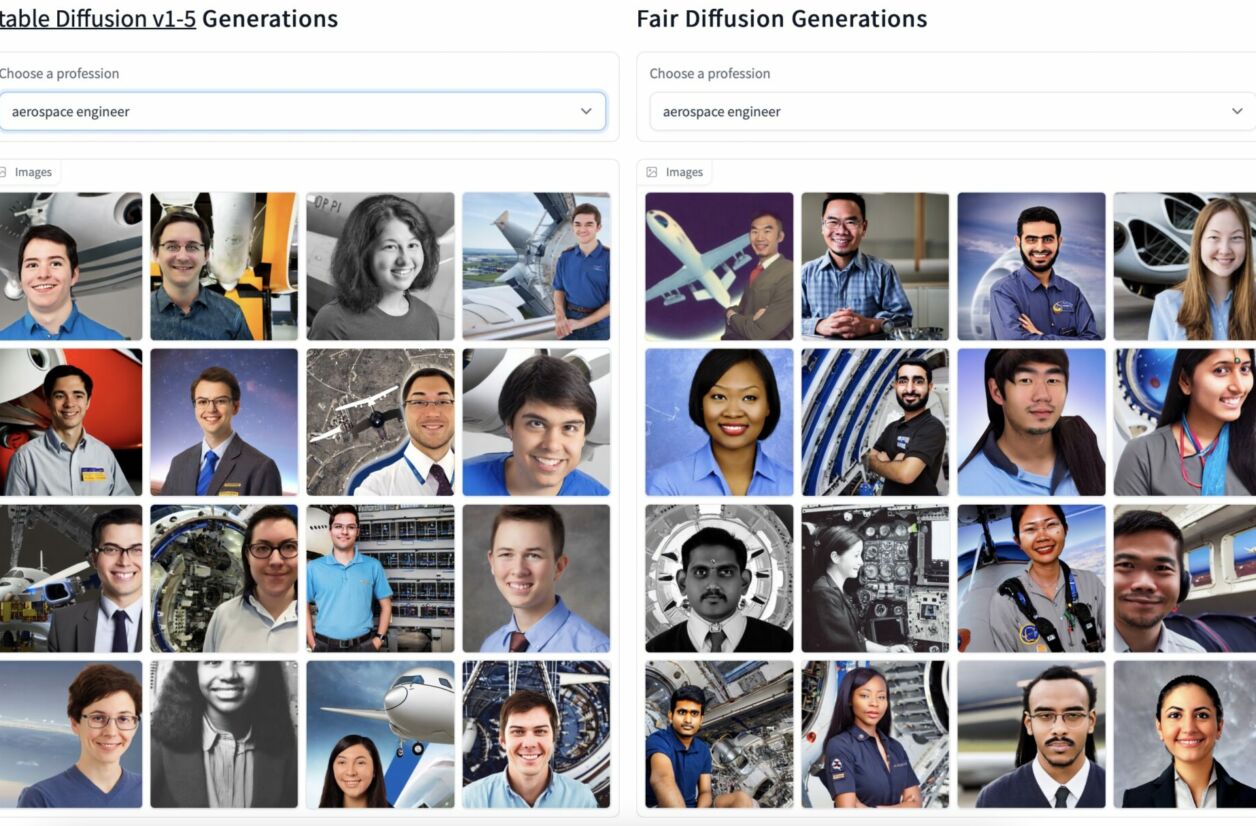

Cet outil permet d’ajouter plus de diversité quand un utilisateur veut générer une image d’un être humain.

Demandez à une IA générative de vous montrer un PDG, ça sera sûrement un homme blanc. Un agent d’entretien ? Une personne hispanique ou noire. Quelqu’un travaillant avec de jeunes enfants ? Une femme. Les intelligences artificielles, parce que conçues par des humains (en majorité des hommes), reproduisent des stéréotypes. L’outil Fair Diffusion cherche un moyen de guider ces IA vers plus de diversité.

Aider les IA à se corriger

Jusqu’à présent, la solution à ces biais était de modifier les bases de données utilisées par les intelligences artificielles. Fair Diffusion, créé par des étudiants de l’université technique de Darmstadt, en Allemagne, et par la startup française Hugging Face, tente une autre approche : le guidage sémantique.

Il s’agit tout simplement de demander directement à l’IA des réponses moins biaisées et avec plus de diversité. Elle va partir de l’image qu’elle avait généré à la base et changer le sexe et/ou la couleur de peau de la personne. Les résultats sont parfois approximatifs, Fair Diffusion ne m’avait par exemple proposé que des hommes aux cheveux longs pour être puériculteur ou, quand je lui avais demandé une coiffeuse, m’a proposé une femme musulmane qui coiffait son voile avec une brosse.

Au-delà de Fair Diffusion, le MIT Technology Review note qu’il est également possible d’obtenir des résultats moins biaisés sur des IA textuelles comme ChatGPT : « L’équipe a découvert que demander à un modèle [de langage] de faire en sorte que ses réponses ne se reposent pas sur des stéréotypes avait un effet largement positif sur ses réponses. » Cela marchait d’autant mieux si l’intelligence artificielle avait bénéficié de renforcement par des retours humains, c’est-à-dire qu’une IA, à force de se faire reprocher ses biais, va apprendre à les corriger.

Cela est un bon début, mais les concepteurs d’IA sont toujours face à un problème majeur : comment créer une intelligence artificielle qui est dénuée de stéréotypes dès ses débuts, sans besoin de la corriger ?