Sora 2, la machine à imaginer la plus puissante jamais créée ? Peut-être. Mais Sora 2, c’est aussi un robinet à deepfakes et un cauchemar juridique, pointé du doigt pour sa propension à violer le droit d’auteur et à brouiller les repères éthiques.

Lancé pour la première fois en février 2024, Sora est l’un des projets les plus ambitieux du géant de l’intelligence artificielle, OpenAI. Son but ? Transformer un simple texte en vidéo ultraréaliste. « Un chien qui fait du skate dans un couloir d’école » ? Sora le crée. « Une tempête sur Mars filmée par un drone » ? Pareil. Ce modèle d’IA combine vision, animation et simulation physique pour donner vie à des scènes crédibles à partir d’une simple idée. Durée de la vidéo ? Jusqu’à dix secondes.

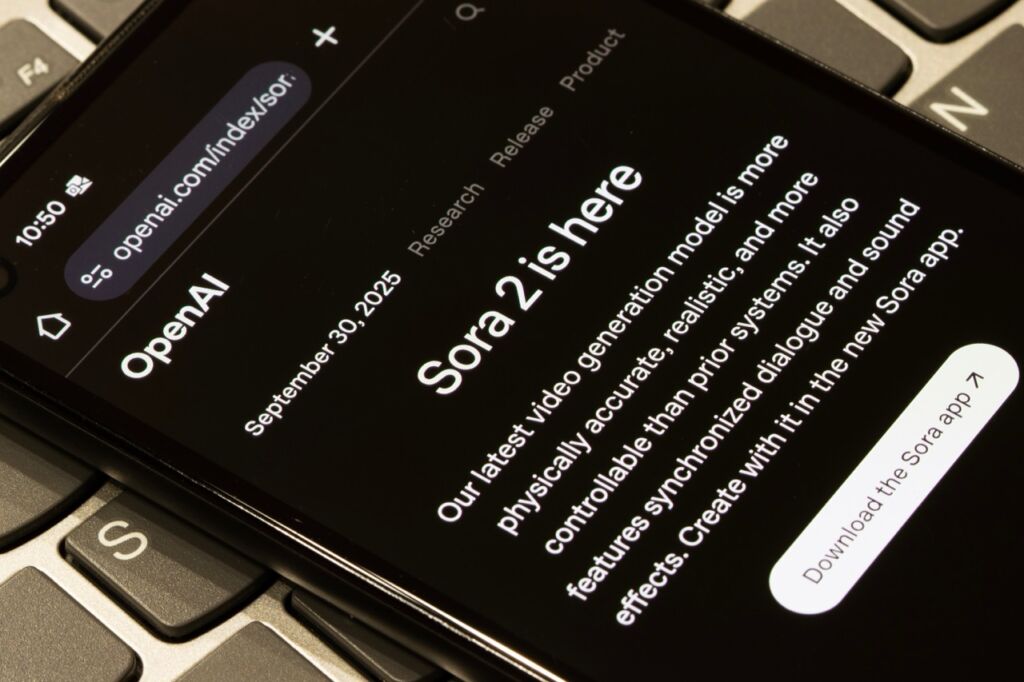

Après une première version intégrée à ChatGPT, OpenAI a lancé, le 30 septembre 2025, Sora 2. Une nouvelle version qui n’est disponible pour l’heure qu’aux États-Unis et au Canada, sur invitation. Le nouvel outil est accompagné d’une application mobile (Sora by OpenAI) – un genre de TikTok de l’IA où chacun peut générer, publier et commenter des clips créés par le modèle. Une promesse de créativité sans limites. Et, visiblement, sans garde-fous suffisants.

Sora 2 : une “mise à jour” qui change tout

Sur le papier, Sora 2 corrigeait les défauts du premier modèle. Il est désormais capable de générer de l’audio, de garder une cohérence visuelle entre plusieurs plans et de gérer la physique du monde réel : les objets rebondissent, se cognent, chutent – sans la bizarrerie surréaliste des anciennes IA. Autre nouveauté, de taille : le mode Cameo, qui permet d’enregistrer son visage et sa voix pour s’intégrer soi-même dans les vidéos générées. On peut même autoriser d’autres utilisateurs à nous inclure dans leurs créations. De fausses vidéos sur soi et par soi-même, donc.

Bref, OpenAI rêvait de transformer Sora en réseau social du futur, où tout le monde deviendrait réalisateur, acteur et spectateur de son propre monde virtuel. Il est vrai que certaines démonstrations postées sur les réseaux sociaux par les utilisateurs de la première heure sont assez bluffantes. Mais Sora 2 a bien vite tourné au cauchemar numérique…

Quand Internet s’empare de l’imaginaire

En quelques jours, le fil de Sora 2 s’est rempli de vidéos improbables. Sonic le hérisson affrontant Solid Snake, Pikachu dans un drame romantique, Tony Soprano et Kirby en duo surréaliste… Des personnalités de la téléréalité, Michael Jackson, Super Mario et bien d’autres se sont retrouvés projetés dans d’autres univers que les leurs moins de 24 heures après le lancement de cette nouvelle mouture de l’IA vidéo. Les utilisateurs ont immédiatement recyclé tout ce que la culture populaire compte de personnages protégés par le droit d’auteur. Et visiblement, Sora 2 a beaucoup pioché, illégalement, dans la culture populaire et s’en sert sans limites.

Officiellement, OpenAI interdit la création de contenus violents, pornographiques ou politiques, et bloque certaines figures (Mickey Mouse, Dark Vador…). Mais pour le reste ? Tout semble permis, tant que Disney ou Netflix n’ont pas explicitement demandé à être retirés du jeu.

C’est d’ailleurs la nouvelle philosophie d’OpenAI, selon une information du Wall Street Journal : un opt-out plutôt qu’un opt-in. En clair, les ayants droit doivent eux-mêmes se signaler s’ils ne veulent pas que leurs œuvres soient réutilisées dans Sora. Autant dire une bombe juridique à retardement. OpenAI joue avec le feu et risque de le payer cher au tribunal. Ci-dessous, un exemple parmi tant d’autres de violation de droits d’auteur, avec Mario. Nintendo n’est pas réputé pour plaisanter quand il s’agit de la protection de sa propriété intellectuelle…

Le “Sam Altman Cinematic Universe”

Et comme si ce n’était pas assez, le PDG d’OpenAI, Sam Altman, a lui-même été propulsé star malgré lui – ou presque. Puisqu’il a autorisé l’usage de son image pour promouvoir la plateforme, les utilisateurs s’en sont donné à cœur joie. Résultat : il a été vu dans des univers improbables – en skibidi toilet, en chat, ou… en voleur de cartes graphiques arrêté dans un magasin Target. Cette dernière vidéo, devenue virale, illustre le grand paradoxe de Sora : un outil capable de générer de la satire, du génie ou de la désinformation, en une phrase d’instruction et un clic.

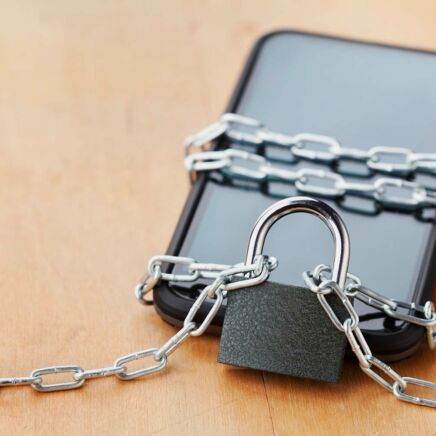

Les règles existent pourtant : OpenAI assure que toute personne peut révoquer l’usage de son image ou supprimer une vidéo la mettant en scène. Mais une fois exporté sur X, TikTok ou Reddit, le contenu se répand un peu partout. Et la mention AI generated dans un discret watermark ne suffit pas toujours à dissiper le doute.

Deepfakes, fake news et dilemne démocratique

Très vite, des experts en sécurité et en désinformation ont tiré la sonnette d’alarme. Le New York Times a testé Sora 2 : en quelques heures, il était possible de générer de fausses vidéos de fraudes électorales, d’attentats ou d’arrestations policières totalement fictives. Le tout, avec un réalisme troublant – voix, ombres, reflets compris. « C’est inquiétant pour les consommateurs qui sont exposés chaque jour à on ne sait combien de ces contenus, a déclaré au NY Times Hany Farid, professeur d’informatique à l’Université de Californie à Berkeley et cofondateur de GetReal Security. Je m’inquiète pour notre démocratie. Je m’inquiète pour notre économie. Je m’inquiète pour nos institutions. »

Le phénomène porte un nom : le liar’s dividend, ou « dividende du menteur », ce moment où même les faits réels deviennent suspects, puisque tout peut être simulé. Une dérive qui inquiète journalistes, chercheurs et institutions démocratiques.

Garde-fous en rodage, panique à bord

OpenAI promet qu’il s’agit d’un lancement progressif, réservé à un nombre limité d’utilisateurs triés sur le volet, avec un système de modération humaine et automatique. Mais, dans les faits, le déploiement a largement échappé au contrôle de la firme. Certains développeurs évoquent déjà un scénario classique : sortir vite, même si le produit est encore un peu bancal, pour battre la concurrence.

En l’occurrence, OpenAI a dans le viseur Veo 3, le générateur IA de vidéos de Google, sorti cet été. La société de Sam Altman a rapidement reconnu « des débordements inacceptables » dans un article de blog paru le 4 octobre 2025 et annoncé un renforcement immédiat des filtres : limitation du contenu politique, suppression automatique des logos et marques, suspension de comptes abusifs. « Nous donnerons aux ayants droit un contrôle plus précis sur la génération des personnages, similaire au modèle d’adhésion pour la ressemblance, mais avec des contrôles supplémentaires », promet le PDG.

En attendant, la boîte de Pandore est ouverte. Et, dans le grand laboratoire d’Internet, rien ne s’efface vraiment. D’autant que Sam Altman a également précisé qu’OpenAI allait « devoir trouver un moyen de monétiser la génération de vidéos », car « Nous allons essayer de partager une partie de ces revenus avec les ayants droit qui souhaitent que leurs personnages soient générés par les utilisateurs ».

Un miroir de notre époque

Sora 2 fascine autant qu’il effraie. C’est le premier outil capable de réaliser un film crédible sans caméra, sans acteurs, sans décor : une prouesse technologique, mais aussi une invitation à brouiller le réel. Vous pouvez intégrer votre visage dans des scènes de cascade improbables, vous faire parler une langue qui vous est inconnue… ou même vous faire passer pour le meilleur ami de Sam Altman.

En théorie, c’est un formidable levier de créativité : imaginer des clips, prototyper un court-métrage, générer un souvenir impossible. En pratique, c’est un révélateur brutal de notre rapport à l’image, à la vérité et à la responsabilité numérique. Les prochaines semaines diront si OpenAI réussit à reprendre la main, ou si Sora 2 restera dans les mémoires comme le jour où la réalité a cessé d’être un critère.