Face à l’évolution rapide des technologies, notamment dans le domaine de l’informatique, nous avons fait évoluer nos protocoles de tests pour les ordinateurs fixes et portables. Encore plus exigeants et toujours plus proches de la réalité des usages, ils nous permettent d’évaluer et de comparer toutes les configurations du marché.

Face à l’évolution rapide des technologies, à la création de nouvelles gammes et à la curiosité des passionnés, le Labo Fnac fait évoluer son protocole d’évaluation des performances informatiques. Encore plus exigeants et toujours plus proches de la réalité des usages, ils permet de tester tous les produits, du Cloud Computer (ChromeBook et Windows S) jusqu’aux unités centrales dédiées aux Gamers en passant par les tout-en-un. Un Protocole pour les dominer tous !

En effet, l’ancien protocole était basé sur des jeux tels que Call Of Duty Modern Warfare. Un titre exigeant, mais qui date tout de même de 2007. S’il représentait le nec plus ultra à l’époque, il est limité à 91 fps (images par seconde), et n’est plus du tout adapté pour tester les dernières générations de cartes graphiques. Il en va de même pour d’autres titres célèbres à l’image de Dirt Rally et de Far Cry, même si les mesures effectuées n’intervenaient pas dans le calcul de la note.

Côté bureautique, les solutions d’Adobe ainsi que les incontournables Word et Excel étaient utilisés. Les tests consistaient à créer de gros fichiers avec différents filtres et macros, des documents avec une centaine de chapitres ou feuilles de calcul, etc.

Cependant ces logiciels ont évolué vers des solution dites « cloud » et dont les performances sont maintenant plus liées à la qualité de la connexion Internet et aux serveurs disponibles, et rendent toutes mesures incompatibles avec un système d’évaluation cohérent.

Alors que faire ? Le Labo Fnac a choisi de repartir sur de nouvelles bases avec toujours le même souci d’équité entre tous les produits qui sont testés.

Des tests « maison »

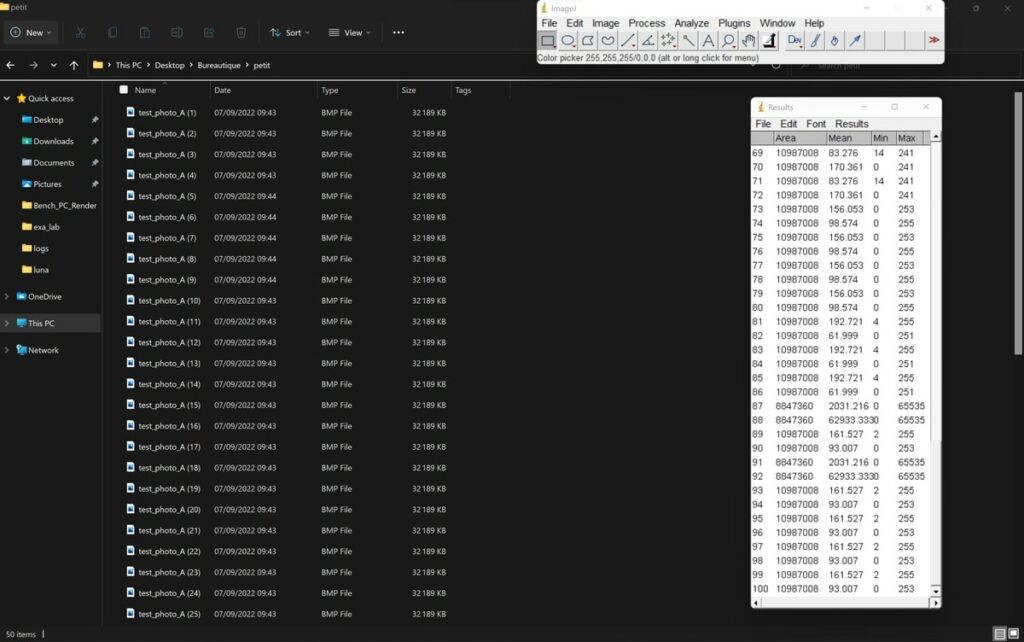

Les évolutions de la technologie ont poussé le laboratoire à aussi faire évoluer les protocoles de tests. Mais, quitte à tout changer, autant faire les choses différemment. Plutôt que d’utiliser les logiciels de tests classiques à l’instar de la plupart des sites spécialisés, Javare Traore (responsable des tests informatiques) à préféré des applications open source de renom, comme par exemple ImageJ qui a été développé par l’institut de la santé aux États-unis, et qui est largement utilisé par la communauté scientifique pour le traitement d’images. Bien entendu, les protocoles ont été conçus de sorte à se rapprocher de l’usage qui sera fait des ordinateurs par les utilisateurs et ImageJ servira a évaluer les performances en bureautique.

Accessoirement, après le déballage, il suffit désormais de simplement installer l’application maison baptisée PerfLab pour effectuer une partie des mesures. Notez que le test d’autonomie a lui aussi légèrement évolué et qu’il y a toujours des mesures au niveau de la partie audio et des écrans en ce qui concerne les ordinateurs portables.

Pousser les ordinateurs dans leurs derniers retranchements

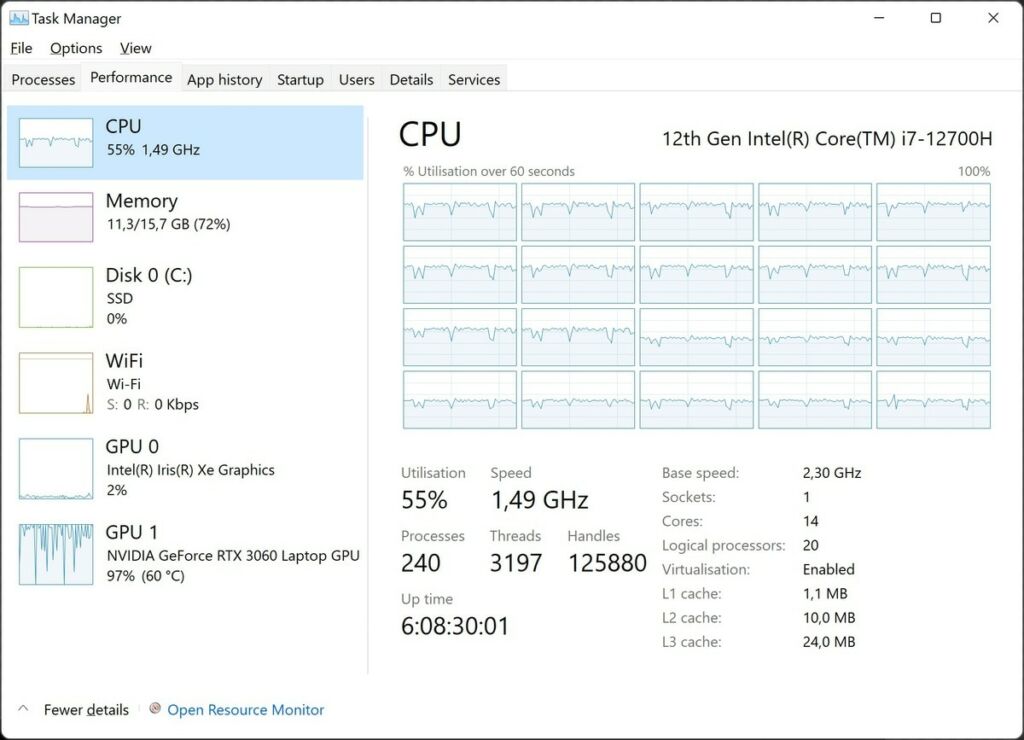

Les nouveaux protocoles de tests ont un objectif clair : il faut solliciter la machine au maximum de ses capacités, le tout en ciblant chaque composant individuellement, comme par exemple tous les cœurs du CPU (le processeur principal). Chose qu’il n’était pas possible de faire avec Word, par exemple.

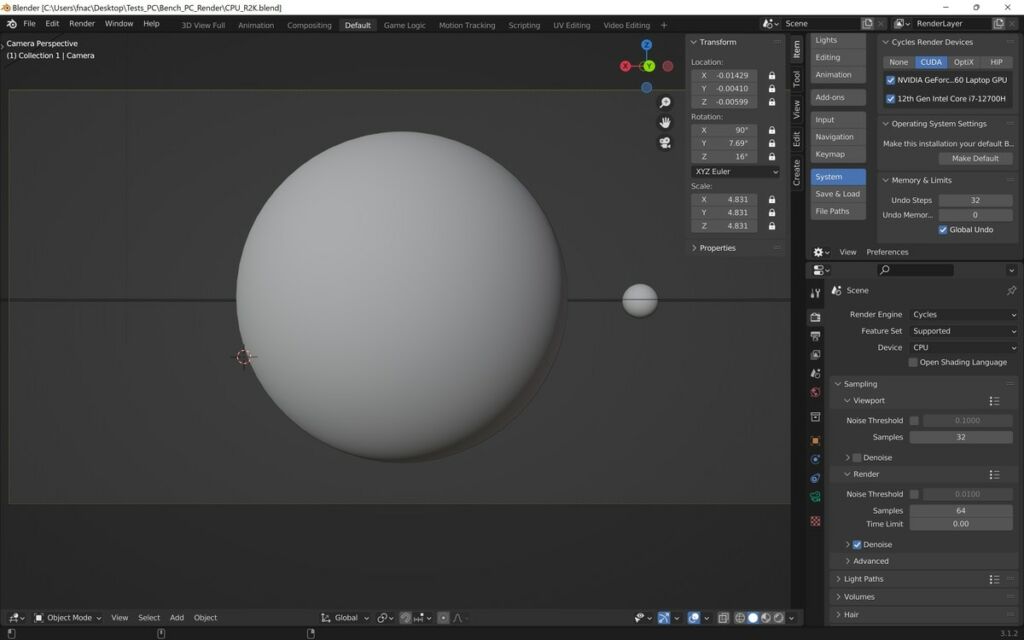

Pour ce premier test, le Labo Fnac utilise la célèbre application Blender. Une référence dans l’univers de la modélisation 3D permettant l’exploitation des nouvelles fonctions des cartes graphiques telles que le Ray-tracing jusque 360 images par seconde en HD, qui servira de base pour la note gaming

Le protocole consiste à modéliser la Terre entière en 3D, la lune et la Voie lactée en toile de fond. Et, comme si ce n’était pas déjà suffisant, à utiliser différentes textures jusqu’à 38K (21 600 x 10 800 pixels) qui ont été réalisées par la Nasa.

Comme nous l’écrivions plus haut, ce test permet de cibler spécifiquement le CPU en réalisant trois rendus différents en 2K, 4K et 8K. Sur la capture d’écran ci-dessous, on se rend bien compte que l’ensemble des cœurs est sollicité lorsque le rendu est lancé. La carte vidéo est également sollicitée et l’opération peut demander plusieurs minutes en fonction des performances de l’ordinateur. C’est d’ailleurs l’un des avantages de ce test spécifique : il ne s’agit pas de se contenter d’une simple vitesse de pointe.

Une fois le test terminé, un fichier est généré et ne peut plus être modifié et dans lequel sont inscrits les résultats. Rappelons également que l’opération est répétée en 2, 4 et 8K, non seulement pour le CPU mais aussi pour le GPU (le processeur graphique).

Mais ce n’est pas tout. Pour valider ces rendus 3D maison, le testeur utilise également le BMW 27. Il s’agit d’un fichier avec des spécifications de rendu qui est largement utilisé sur le Internet. Ce dernier nous permet de comparer les performances de rendu avec une base de données mondiales.

Enfin, à cela s’ajoute un rendu d’animation avec Eevee, le moteur en temps réel de Blender basé sur l’interface multiplateformes OpenGL. Ce dernier permet de cibler le GPU zéro, c’est-à-dire la puce graphique de base qui est généralement la moins puissante, et celle qui consomme le moins. Durant cette étape, un rendu d’animation est réalisé sur 11 images. Reste ensuite à relever la durée de création du rendu de ces dernières.

Tous les résultats de ces tests sont importés dans la base de données du laboratoire. Au passage, le labo obitent aussi les temps d’écriture sur le stockage interne, qu’il s’agisse d’un bon vieux disque dur ou d’un SSD. Et, de la même façon, le fichier log regroupe d’autres données utiles comme les performances de la mémoire vive.

Il n’est pas possible de tester une carte graphique Nvida comme un modèle d’AMD ou un processeur M1. Le nouveau protocole du Labo Fnac permet d’utiliser le moteur de rendu le plus adapté au composant graphique (directX, CUDA, OptiX, Metal), et de s’adapter à toutes les plateforme MacOS, Windows, Linux, ChromeOS, Windows S. Pruve de l’exigence de ces test, même la surpuissante RTX 3090 a plié les genoux lors de l’évaluation.

Des tests adaptés aux vrais usages

Outre les performances brutes, l’intérêt se porte également aux usages concrets des utilisateurs. Lors de l’étape suivante, le protocole simule les besoins d’un photographe ou d’un graphiste qui va manipuler de gros volumes de fichiers.

Pour ce traitement par lot, des photos sont utilisées qui vont être traitées par le logiciel ImageJ. Le principe est assez simple, avec un dossier cible qui regroupe les photos en entrée, et un dossier vide en sortie qui va regrouper les fichiers sur lesquels sera appliquée une macro. Celle-ci va inscrire de nombreux des tags sur chaque image, les redimensionner et les enregistrer sous un nouveau nom.

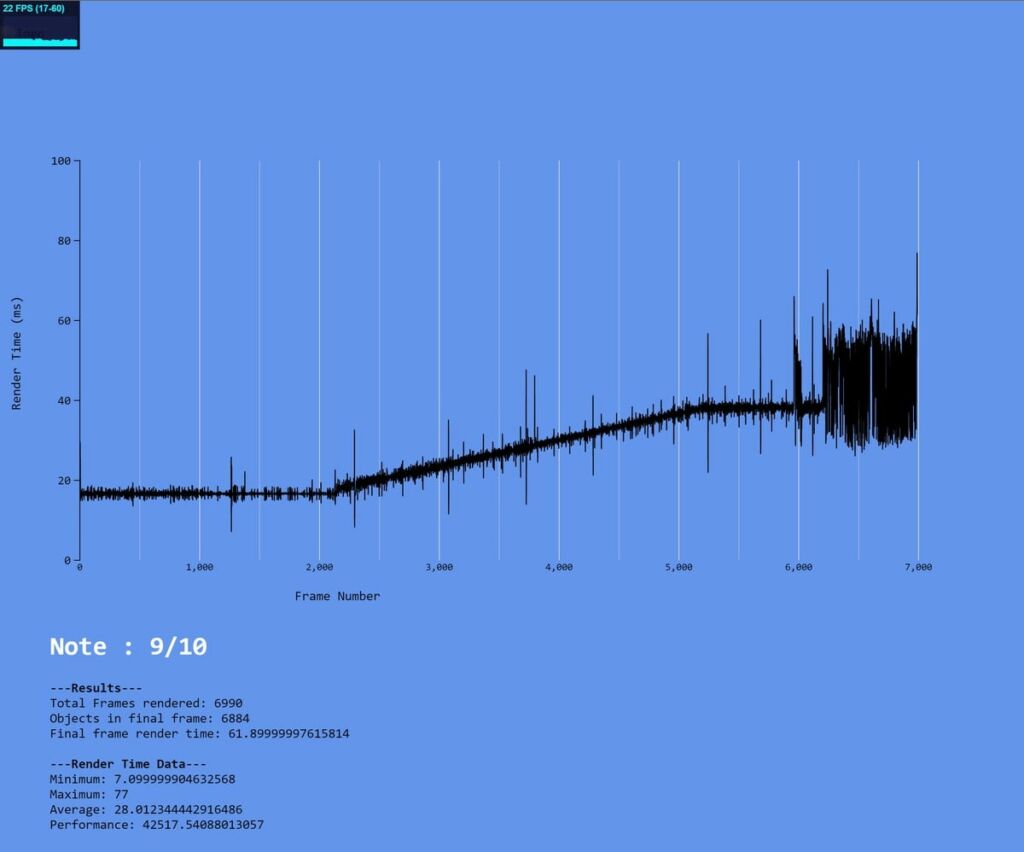

Les applications web sont désormais incontournables, tant sur nos ordinateurs que sur les smartphones, les tablettes et même les téléviseurs. Pour évaluer leurs performances, le laboratoire utilise le test Pixel Fill Rate qui permet de cibler la carte vidéo de base (le GPU 0 dont nous vous parlions plus haut, plutôt que le deuxième GPU plus puissant), et sa capacité à générer un nombre de pixels par seconde.

Ce test permet d’obtenir le FPS max, et d’identifier la gestion intelligente des performances sans que le système ne bascule automatiquement sur le GPU 1 le plus puissant lorsqu’il est fortement sollicité. Avantage de ce script, il peut s’adapter aux performances du produit sur lequel il est exécuté (PC, appareil mobile, etc.), et aller jusqu’à la saturation du GPU. La courbe obtenue affiche le temps en milliseconde en ordonnée, et le nombre de mégapixels en abscisse. Sa forme indique la stabilité ou non du composant.

Enfin, impossible de tester un ordinateur sans s’intéresser à la partie gaming. Le nouveau protocole de test se décompose en deux parties. D’une part les rendus GPU vus plus haut, et d’autre part un rendu en temps réel. Ce dernier est là encore réalisé avec Blender, mais aussi avec FPS Monitor.

Le logiciel est configuré pour d’abord utiliser un rendu filaire (Wire), puis un rendu solide et enfin un rendu avec le moteur EeVee qui utilise le raytracing, c’est-à-dire en affichant les reflets de l’animation à l’écran. FPS Monitor fournit le nombre d’images par seconde (fps en anglais) pendant les trois tests. Ces résultats associés aux performances de rendu GPU permettent d’établir la note globale pour la partie gaming.

Des tests poussés dans tous les domaines

Comme précédemment, d’autres tests sont aussi réalisés pour évaluer les écrans, la qualité audio ou encore l’autonomie en ce qui concerne les ordinateurs portables. À ce titre, le test d’autonomie a lui aussi légèrement évolué avec la mise en place d’une solution de lecture vidéo continue en streaming depuis VLC.

Les écrans sont testés avec le matériel professionnel qui sont utilisés pour les téléviseurs. Pour rappel, sont évaluées : la colorimétrie (mais uniquement en sRGB contrairement aux télévisions qui sont testées en DCI-P3 et rec2020), le gamma, et la directivité. Autre différence majeure avec les tests qui sont réalisés sur les téléviseurs, la mesure du taux de contraste ne repose pas sur un rapport du niveau de noir sur blanc, mais plutôt avec un noir à 5 % (afin de comparer de manière réaliste les dalles LCD et les dalles OLED !). Enfin, la densité de pixels est indiquée, chose que nous ne faisons pas avec les TV.

Pour finir, les tests audio ont légèrement évolué eux aussi. En effet, le test de la prise jack a été supprimé, car chronophage pour peu d’interêt (avec l’arrivée des casques bluetooth et la suppression des ports jacks sur les nouveaux chassis d’ordinateurs). Par ailleurs, les haut-parleurs sont testés dans une chambre anéchoïque en plaçant l’ordinateur sur une table de test à une hauteur de 40 cm. Le micro est placé en face de sorte à simuler la position de l’utilisateur lorsqu’il est assis sur une chaise et devant son ordinateur portable qui est posé sur le bureau. L’angle de l’écran est toujours le même afin de pouvoir comparer les résultats.

Pendant cette étape, une mesure de la réponse en fréquence est réalisée avec une bande passante qui s’étale généralement entre 63 Hz et 16 kHz (les ordinateurs portables sont limités en matière de basses fréquences). Enfin une mesure de distorsion à 1 kHz pour 3 % de distorsion qui est la fréquence la plus courante, et toujours avec la même configuration au niveau du microphone.

Tous ces tests permettent d’obtenir les différentes notes du radar afin de comparer les ordinateurs et vous accompagner dans votre choix.