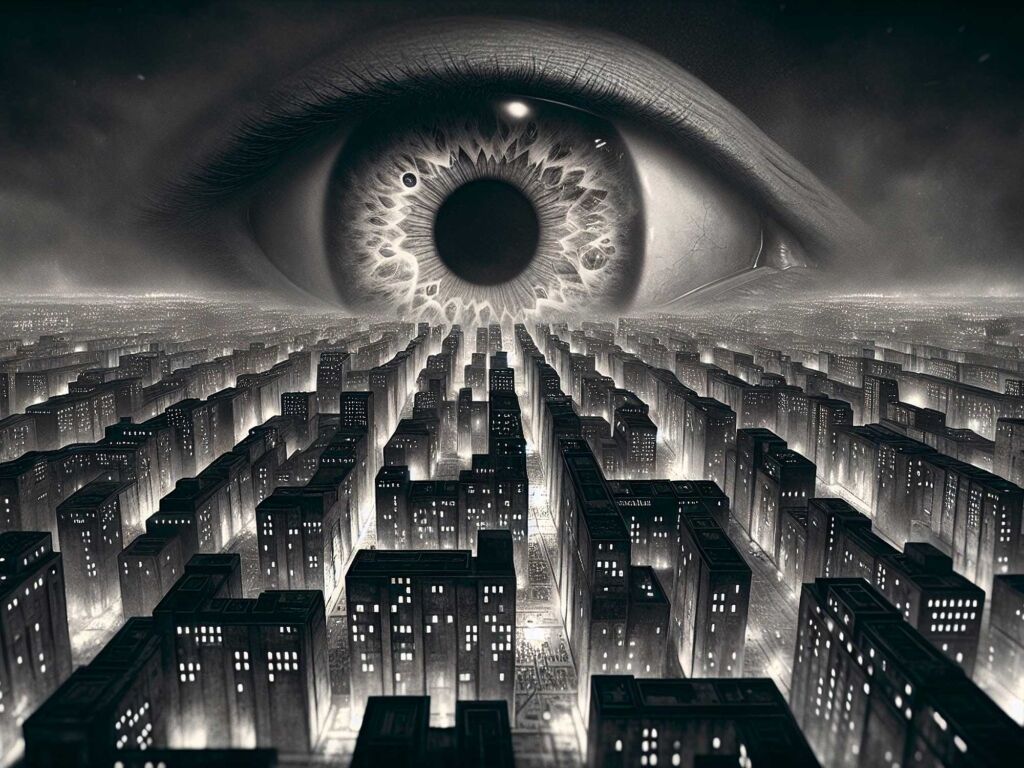

Alors que les géants de la Tech nous promettent l’avènement imminent d’une « super-intelligence » capable de rivaliser avec le cerveau humain, des voix scientifiques dissonantes s’élèvent pour briser l’illusion. Loin du marketing californien, voici pourquoi l’idée d’une machine consciente et omnisciente relève encore largement de la science-fiction, et pourrait le rester longtemps.

C’est la promesse ultime. Le Saint Graal. Ce que Sam Altman (OpenAI) ou Elon Musk (xAI) appellent l’AGI (Artificial General Intelligence). Une intelligence artificielle qui ne se contenterait plus de jouer aux échecs, de résumer de longs rapports complexes ou de générer des mails, mais qui serait capable de raisonner, de s’adapter à n’importe quelle situation inconnue, de ressentir et, in fine, de surpasser l’humain dans la plupart, si ce n’est toutes, les tâches cognitives. Si l’on en croit certains acteurs les plus optimistes de la Silicon Valley, elle serait pour demain matin, ou au pire pour la fin de la décennie.

Pourtant, une fois passée l’euphorie de voir ChatGPT écrire un poème à la manière de Baudelaire ou de vous décrocher les bons arguments pour une augmentation, une réalité plus froide se dessine. Et si nous avions atteint un plafond de verre de l’intelligence artificielle ? Et si, structurellement, la technologie actuelle n’était qu’une immense illusion ? De nombreux chercheurs reconnus estiment que l’AGI telle qu’elle est fantasmée aujourd’hui relève de la chimère, du moins avec les approches actuelles. On vous explique pourquoi votre ordinateur a très peu de chances de devenir le HAL 9000 du film 2001, l’Odyssée de l’espace.

Le syndrome du « Perroquet Stochastique »

Pour comprendre pourquoi l’IA générale est peut-être inatteignable, il faut soulever le capot de nos outils actuels. Que ce soit GPT-5, Claude 4 ou Gemini 3, tous reposent sur le même principe : les LLM (Large Language Models). Ce sont des champions de la statistique, entraînés sur des quantités astronomiques de textes pour deviner… le mot suivant.

À lire aussi

C’est ici que le bât blesse. Prédire le mot le plus probable après « Le chat boit du… », ce n’est pas comprendre le concept de « chat », ni celui de « lait ». C’est un calcul de probabilité. L’écrivain de science-fiction Ted Chiang a résumé cette limite avec une analogie brillante publiée dans le New Yorker en 2023, comparant ces IA à un algorithme de compression d’image : « ChatGPT est un JPEG flou du web. Il conserve une grande partie des informations du Web, de la même manière qu’un fichier JPEG conserve une grande partie des informations d’une image haute résolution, mais, si vous recherchez une séquence de bits exacte, vous ne la trouverez pas ; vous n’aurez qu’une approximation. »

Concrètement, un modèle de langage ne « sait » rien par lui-même : il manipule des corrélations de mots, sans accès direct à la réalité. C’est pour cela qu’il hallucine des faits juridiques ou historiques, qu’il invente des citations. C’est parce qu’il n’a aucun accès à la vérité, seulement à la vraisemblance linguistique. Pour atteindre une intelligence générale, il faudrait passer de la syntaxe (l’ordre des mots) à la sémantique (le sens des choses). Or, empiler des milliards de phrases ne crée pas miraculeusement du sens, pas plus qu’empiler des briques ne crée une cathédrale si l’on n’a pas un plan créé par un architecte.

L’intelligence, ce n’est pas (que) la mémoire

L’autre grand malentendu réside dans la définition même de l’intelligence. Aujourd’hui, on s’extasie parce qu’une IA réussit des examens mathématiques poussés, le concours du barreau en droit ou celui de médecine. Mais est-ce de l’intelligence, ou du « parcœurisme » à l’échelle industrielle ? François Chollet, créateur de la librairie Keras (utilisée par des millions de développeurs) et ancien chercheur chez Google, est l’un des critiques les plus pertinents de cette course à la puissance. Selon lui, nous confondons la compétence (savoir faire une tâche spécifique) et l’intelligence (la capacité à s’adapter à l’imprévu).

Il a mis au point un test redoutable, le ARC-AGI, composé de puzzles logiques visuels qu’un enfant peut résoudre, mais que les IA les plus puissantes échouent massivement. Pourquoi ? Parce que ces puzzles ne sont pas dans leurs données d’entraînement. L’IA ne sait pas improviser. Elle est totalement démunie face à une situation qui lui est totalement étrangère. Dans un de ses articles de référence, publié en 2019, « On the Measure of Intelligence », François Chollet explique : « L’intelligence est l’efficacité avec laquelle un système acquiert de nouvelles compétences à partir de l’expérience, et non la performance qu’il atteint après un entraînement immense sur des tâches connues. » Tant que l’IA aura besoin de voir 10 000 images d’un vélo pour reconnaître un vélo (alors qu’un enfant n’en a besoin que d’une ou deux), nous serons face à un système de mémorisation, pas une intelligence générale.

Faire le lien entre la théorie et la pratique

C’est sans doute l’obstacle le plus difficile à saisir, mais le plus crucial : une intelligence peut-elle exister sans corps pour éprouver la réalité ? Imaginez que vous lisiez tous les livres existants sur la natation, l’hydrodynamisme et la respiration. Vous saurez théoriquement tout sur la nage. Mais si on vous jette à l’eau pour la première fois, vous coulerez. Pourquoi ? Parce que vous n’avez pas intégré la « physique » du monde. L’intelligence, ce n’est pas seulement stocker des données, c’est comprendre la relation de cause à effet par l’expérience.

C’est le cheval de bataille de Yann LeCun, l’ancien directeur scientifique de l’IA de Meta. Il explique que les IA actuelles (les LLM) connaissent le langage, mais ne comprennent pas le monde. Elles n’ont pas de « modèle du monde ». Elles peuvent, certes, écrire une dissertation sur la gravité, mais ne « savent » pas physiquement que si elles lâchent un verre, il va se briser. Elles n’ont jamais ressenti le moment où vous lâchez un objet dans le vide. Dans une comparaison devenue célèbre, LeCun rappelle que l’apprentissage par le texte est superficiel comparé à l’apprentissage par le vivant : « Les plus intelligents des systèmes d’IA qu’on a aujourd’hui ont beaucoup moins de bon sens qu’un chat. Ils sont très supérieurs à l’humain dans certains domaines très étroits, mais il leur manque l’aspect de la connaissance générale du monde. Un chat sait que s’il pousse un objet, il tombe. Il a un modèle physique du monde que les LLM n’ont pas. »

Tant que l’IA restera un « cerveau dans un bocal » (en l’occurrence, un serveur), déconnecté des lois de la physique, elle ne pourra que simuler le raisonnement, sans jamais acquérir le « bon sens » qui permet à un enfant de 4 ans – ou n’importe quel mammifère – de comprendre que l’eau mouille et que le feu brûle. Pour beaucoup d’experts, cette « barrière du réel » semble difficilement franchissable pour une IA purement numérique, sans lien sensoriel avec le monde.

Le mur des rendements décroissants

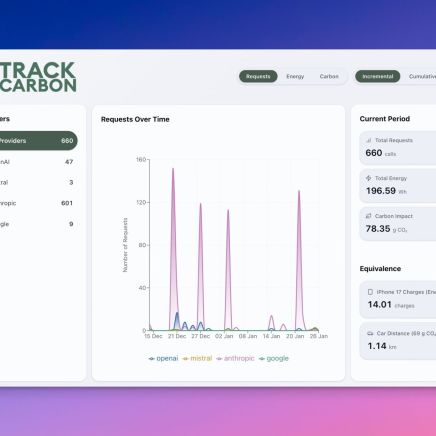

Enfin, il y a aussi une limite pragmatique : l’énergie et les données. La progression de l’IA suit une courbe exponentielle de consommation. Pour gagner quelques points de performance supplémentaires, il faut désormais multiplier la puissance de calcul (et donc la facture électrique) par dix ou 100.

Les IA les plus avancées auront bientôt exploité l’essentiel des corpus textuels de haute qualité disponibles en ligne. Les chercheurs d’Epoch AI estimaient en 2024 que nous pourrions manquer de données textuelles de haute qualité d’ici 2026. Si les IA commencent à s’entraîner sur des textes générés par d’autres IA (ce qu’on appelle le Model Collapse), elles risquent de devenir de plus en plus stupides, amplifiant leurs propres erreurs en boucle fermée.

Alors, c’est grave ?

Pas vraiment… Si on y réfléchit bien, que l’AGI ne voie jamais le jour, ou n’ait finalement qu’une forme bien plus limitée que ce que promet la science-fiction, serait peut être une excellente nouvelle. Cela signifie que nous n’avons pas à craindre un scénario à la Terminator ou à 2001, l’Odyssée de l’espace. Cela veut dire que nous devons revoir nos attentes : arrêter de fantasmer sur une machine-dieu consciente, et apprécier l’IA pour ce qu’elle est.

Un outil surpuissant, une « Narrow AI » (IA étroite) capable de nous aider à coder, à détecter des cancers, à argumenter pour négocier un prêt avec sa banque, à résumer ce rapport beaucoup trop long ou à optimiser notre consommation d’énergie. C’est déjà énorme. Finalement, pas besoin que votre calculatrice ait une âme pour qu’elle soit utile.