Source de fantasmes il y a encore quelques années, l’intelligence artificielle a fini par rejoindre la réalité quotidienne et bousculer les habitudes. Elle a non seulement donné la parole aux smartphones, mais contrôle désormais aussi certains équipements de la maison, et bat à plates coutures des champions d’échecs. Et demain ? Elle vous conduira peut-être au travail, qui sait ? C’est donc une véritable révolution qui se joue aujourd’hui. Et il était temps puisqu’elle se prépare depuis plus de 60 ans déjà. Il aura donc fallu du temps pour que l’intelligence artificielle devienne ce qu’elle est, et plus encore de persévérance. Retour sur la techno incontournable de ce début de siècle.

Qu’est-ce que l’intelligence artificielle ? La réponse à cette question n’est pas forcément aussi évidente qu’elle en a l’air. Bien sûr, l’intelligence artificielle a pour but de simuler des comportements humains sur des systèmes informatiques. Mais une autre question se pose alors : à partir de quand peut-on réellement parler de comportements humains ? C’est évidemment là que les choses se compliquent. Même les grands spécialistes du domaine sont loin d’y répondre d’une seule et même voix. Ces divergences ont d’ailleurs mené à différentes tentatives de segmentation au cours de l’histoire de l’intelligence artificielle, et surtout différentes approches. Il nous faudra donc revenir un peu en arrière pour comprendre ce qu’est aujourd’hui l’intelligence artificielle.

Des débuts laborieux

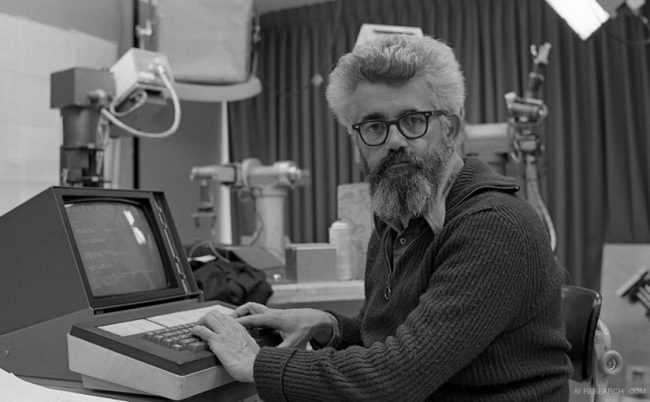

Tout a commencé au milieu du 20e siècle. L’année généralement retenue est 1956. C’est durant celle-ci que fut inventée l’expression “intelligence artificielle”. Le premier homme à l’avoir formulée était un certain John McCarthy, alors enseignant de mathématiques à l’université américaine de Dartmouth, où il avait justement réuni d’autres scientifiques afin de partager sur le sujet. Il est toutefois bon de souligner que de nombreux travaux avaient été engagés en amont. Le premier d’importance remonte même à 1943, année de naissance du neurone artificiel, bien sûr inspiré par le cerveau humain, qui mènera, en 1957, à l’invention du perceptron. Comprenez le premier réseau neuronal ou, autrement dit, le premier algorithme de machine learning (ou « apprentissage automatique » en bon français).

John McCarthy, père de l’intelligence artificielle

Nous retiendrons également l’année 1950 pour la création du test dit, désormais, de Turing par lequel son créateur, Allan Turing, avait tenté de définir de manière simple ce qu’était l’IA. Pour passer ce fameux test avec succès, une machine devait être capable de tenir une conversation avec un humain sans se faire démasquer. Aujourd’hui encore, aucune n’y est vraiment parvenue de manière incontestable. Alors, vous imaginez bien qu’à l’époque, qui était aussi celle des débuts de l’informatique, c’était tout bonnement impossible. Les machines manquaient de puissance comme de mémoire. Cela vaut d’ailleurs autant pour le test de Turing que pour les autres travaux des années 50/60 qui serviront, pour beaucoup, aux grandes avancées futures, mais n’atteindront jamais réellement leurs objectifs initiaux.

S’en suivit donc une période de grande remise en question dans les années 70, et une nouvelle approche. Finalement conscients du décalage entre leurs ambitions et les moyens techniques alors à leur disposition, les scientifiques abandonnèrent pour la plupart l’idée de créer une intelligence artificielle capable de rivaliser avec l’Homme dans tous les domaines pour s’orienter vers des domaines spécifiques, comme le diagnostic médical ou le jeu. C’est ce que l’on appelle des systèmes experts. L’avantage, c’est évidemment qu’ils demandent moins de connaissances, et donc aussi de ressources pour stocker et traiter ces dernières. Les résultats sont alors moins décevants, et relancent l’intérêt pour l’intelligence artificielle.

La fin de cette décennie verra ainsi naître les premiers travaux sur la rétropropagation qui mèneront très vite aux perceptrons multicouches. Il s’agit toujours d’algorithmes, mais capables de résoudre des problèmes beaucoup plus complexes que les perceptrons à une seule couche utilisés par le passé pour le machine learning, qui revient ainsi sur le devant de la scène. Cela deviendra même un domaine de recherche à part entière de l’intelligence artificielle dans les années 80, avec ses propres sous-domaines que sont par exemple l’apprentissage supervisé ou non-supervisé ou encore le désormais célèbre apprentissage profond (deep learning) qui accélérera grandement le développement des IA des années 90 à aujourd’hui. Une véritable révolution donc.

L’ère du deep learning et des grandes avancées

Si l’on entend tant parler de deep learning aujourd’hui, ce n’est donc pas pour rien. Mais que se cache donc derrière ces deux petits mots ? Assez peu de choses nouvelles finalement. Cet « apprentissage profond » résulte essentiellement de divers progrès techniques, bien plus que théoriques. Comme indiqué plus tôt, c’est une méthode de machine learning. Elle s’appuie ainsi sur des algorithmes d’apprentissage (supervisé, non-supervisé et/ou par renforcement) comme il en existait déjà, et qui s’appuient eux-même sur des calculs statistiques utilisés depuis plus longtemps encore. Ce n’est donc pas une nouvelle manière d’appréhender l’IA. C’est même très proche de ce qui se faisait auparavant. La grande différence, c’est la quantité de données traitées. Elle est infiniment plus importante. Ce phénomène de massification des données porte d’ailleurs un nom depuis 2005. On parle de “big data”.

Ce sont donc des « big data » en devenir qui ont permis aux machines de s’améliorer rapidement puisque, sans conscience ni réel sens logique, elles s’appuient sur l’expérience pour apprendre. Plus on leur sert de données en guise d’exemples, plus elles affinent leurs “raisonnements” et plus les résultats sont pertinents. Encore faut-il avoir accès à autant de données, et pouvoir les stocker et les traiter bien sûr. C’est pourquoi il aura fallu attendre les années 90 pour observer des progrès très rapides. C’est à cette période qu’a commencé à se démocratiser internet, rapidement devenu la plus grande banque de données au monde, tandis que les machines profitaient de processeurs de plus en plus puissants et de capacités de stockage de plus en plus élevées. Des progrès techniques qui leur ont finalement permis de rivaliser avec l’Homme.

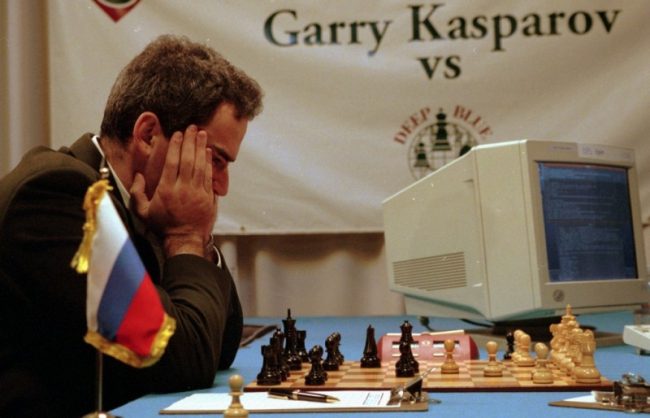

Troisième rencontre entre Garry Kasparov et Deep Blue, 1996 (AP Photo/George Widman)

On retiendra par exemple la victoire de l’ordinateur Deep Blue conçu par IBM sur le champion du jeu d’échecs Garry Kasparov en 1997. La firme continuera d’ailleurs ses expérimentations jusqu’à remporter un autre succès qui fera date dans l’histoire de l’intelligence artificielle avec son projet Watson. Cette machine reliée à 2880 processeurs et quelque 15 To de mémoire vive répartis sur 90 serveurs a été invitée à participer au jeu télévisé américain Jeopardy! en 2011, face aux meilleurs candidats de l’époque rassemblés pour l’occasion. Et elle a bien évidemment gagné. IMB n’est toutefois pas la seule entreprise à travailler sur l’IA. C’est d’ailleurs le cas de la plupart des fournisseurs de matériel informatique, à l’image d’Intel ou Nvidia, mais aussi d’entreprises issues d’autres secteurs d’activité.

L’intelligence artificielle au quotidien

L’intelligence artificielle ne serait pas ce qu’elle est aujourd’hui non plus sans les travaux menés par Google, Microsoft, Apple, Facebook ou encore Amazon. Des entreprises aux activités diverses, mais qui partagent néanmoins un même avantage lorsqu’il s’agit d’IA. Toutes amassent chaque jour, de manières plus ou moins transparentes, des millions de données via leurs activités respectives : Android, Search, Youtube ou encore Gmail pour Google, Facebook pour l’entreprise du même nom, etc. Ces données sont ainsi utilisées afin d’améliorer les services par le biais desquels elles sont récoltées en utilisant le deep learning, mais aussi pour en créer d’autres que nous utilisons désormais au quotidien. C’est donc principalement grâce à ces initiatives que l’intelligence artificielle a fini par sortir des laboratoires des plus grands groupes d’informatique pour rencontrer le grand public.

Cortana, l’assistant virtuel de Microsoft

Siri chez Apple, Now puis Assistant chez Google, Cortana chez Microsoft ou encore Alexa chez Amazon. Ces assistants virtuels que l’on a pour la plupart connus sur smartphones avant qu’ils n’intègrent d’autres appareils du quotidien (les ordinateurs, les montres, les enceintes et même, désormais, les réfrigérateurs) profitent tous du deep learning, qui a autant servi à faire progresser la reconnaissance vocale qu’à étendre leurs domaines de compétences. Google Assistant peut ainsi, via l’enceinte Google Home connectée au réseau domestique, contrôler divers équipements en réponse à des commandes énoncées en langage naturel, en plus de pouvoir discuter de sujets très variés. Il est même possible de faire discuter deux enceintes Google Home ensemble, mais mieux vaut avoir beaucoup de temps devant soi. L’expérience a déjà été tentée, et même rediffusée en direct sur internet. Elles ont toujours quelque chose à se raconter.

Google Home, l’enceinte intelligente grâce à Google Assistant

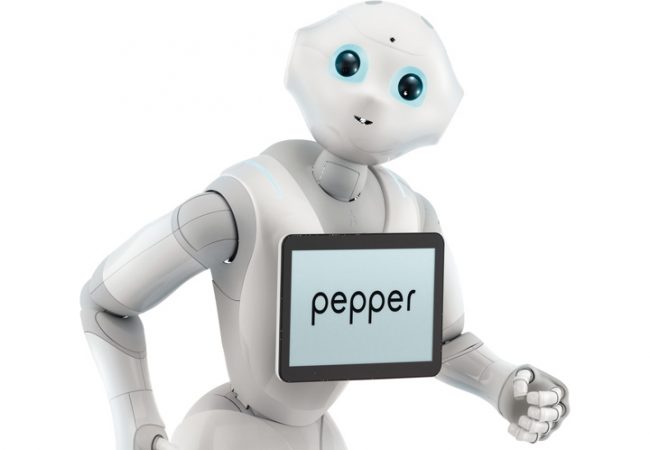

L’intelligence artificielle se cache désormais aussi derrière des outils bien plus communs. Google l’utilise par exemple sur son moteur de recherche, où elle sert à l’analyse sémantique des requêtes pour offrir des résultats plus pertinents, ou encore sur Gmail, pour écarter automatiquement les spams ou la pub. Comme Facebook, il travaille en outre beaucoup sur l’analyse des images même si l’usage n’est pas le même. Google automatise la classification des images postées sur la toile tandis que le réseau social vise plutôt à reconnaître les visages. Et les robots humanoïdes dans tout ça ? Aucun des acteurs cités jusqu’ici ne semble en avoir fait une fin en soi, mais quelques start-ups y travaillent. L’une des plus célèbres était d’ailleurs française, avant d’être rachetée par le groupe japonais Softbank en 2012 et de devenir Softbank Robotics Europe. C’est à elle que nous devons Pepper, embauché notamment par Renault pour jouer les mascottes dans ses spots publicitaires, mais aussi par d’autres entreprises afin de servir leurs clients.

Pepper, le robot star de Softbank Robotics Europe

Il faudra néanmoins attendre encore quelques années avant que les humanoïdes n’arrivent dans nos foyers pour nous assister au quotidien. L’intelligence artificielle pourrait même d’ici là révolutionner d’autres secteurs que l’aide à la personne, comme la médecine avec l’automation des diagnostics ou la sécurité avec l’analyse continue et automatique des images fournies par les caméras de surveillance. Sans oublier l’automobile. De nombreux constructeurs proposent déjà des fonctions permettant de garer un véhicule sans avoir à toucher le volant, mais les voitures pourraient aussi se conduire toutes seules dans quelques années. L’intelligence artificielle en a donc encore sous la pédale et nous sommes certainement très loin d’avoir vu tout ce dont elle est capable.

Des craintes plus ou moins justifiées

Faut-il alors se méfier de l’intelligence artificielle ? Au vu des scénarios pour le moins sombres qu’elle a presque toujours inspirés au cinéma et des prévisions effrayantes de certains scientifiques comme Stephen Hawkings, difficile de faire autrement. L’intelligence artificielle est pourtant loin de constituer une réelle menace pour l’humanité dans son état actuel et, si les développements futurs lui permettront très certainement de dépasser les capacités humaines, nous pourrions d’ici là voir aussi nos propres capacités décuplées pour y faire face.

L’intelligence artificielle sous son plus mauvais jour avec SkyNet, dans la saga Terminator

C’est en tout cas l’idée récemment présentée par Elon Musk. Grand visionnaire et fondateur de Tesla et Paypal, l’homme d’affaires vient de lancer la start-up Neuralink avec laquelle il travaillerait sur des implants cérébraux. L’objectif serait dans un premier temps de soigner des troubles neurologiques comme l’épilepsie, mais la porte reste ouverte à d’autres applications. Il n’hésite d’ailleurs pas à évoquer l’augmentation pure et simple des capacités cognitives grâce au mariage de l’intelligence biologique et artificielle, qui permettrait selon lui de garder une longueur d’avance sur les machines.

Et quand on sait qu’Elon Musk lance rarement des paroles en l’air et que ses projets souvent un peu fous au départ se concrétisent assez rapidement, son idée de véritable Homme augmenté pourrait laisse rêveur !